通过分析54场美联储演讲,汇丰发现,对于与货币政策高度相关的演讲,人工智能工具在大多数情况下接近人类专家的结论;然而,当处理不太相关的语音时,人工智能可能会生成不准确甚至虚构的内容。人工智能有提高生产力的潜力,但还不足以完全取代人类分析师。

近日,汇丰银行发布了一篇题为《AI能追踪美联储吗? 》报告,深入探讨了生成人工智能在分析美联储官员讲话和预测货币政策方向方面的潜力和局限性。

汇丰银行开发了基于GPT-4的AI工具,可以自动评估美联储讲话的相关性、内容摘要、政策倾向(鹰派/鸽派/中性)及其背后的原因。

通过分析 54 篇美联储演讲,汇丰发现,对于与货币政策高度相关的演讲,AI 工具的表现接近于“勤奋的初级分析师”,并且在大多数情况下接近人类专家的结论。

然而,在处理与货币政策无关或不太相关的言论时,人工智能可能会生成不准确甚至虚构的内容,降低用户信任度。

因此,汇丰得出的结论是,尽管人工智能工具具有提高生产力的潜力,但还不足以完全取代人类分析师,特别是在需要高精度的任务中。

01 美联储讲话人工智能分析

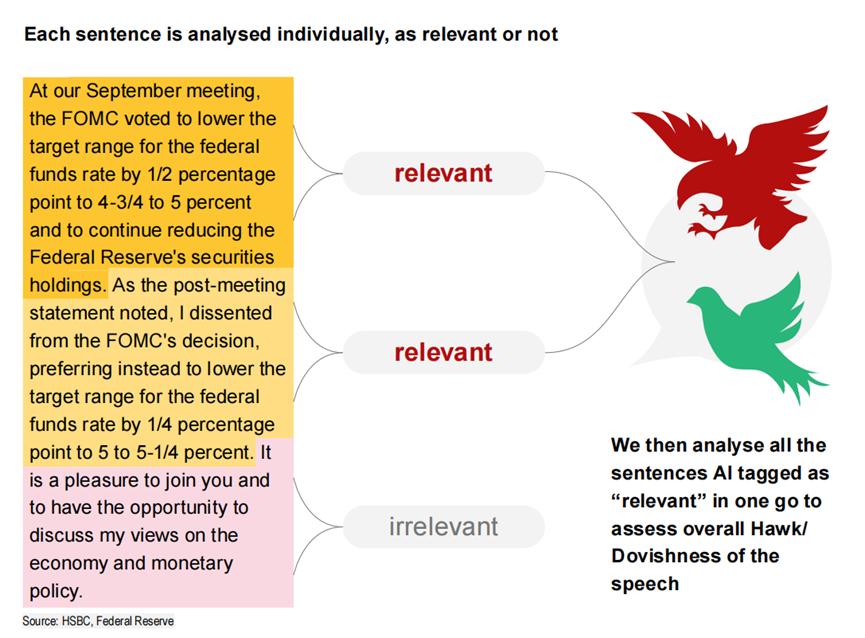

汇丰开发的AI工具采用“逐句筛选+整体分析”的方法,从关联性筛选、内容总结、政策倾向判断(鹰派、鸽派或中性)四个方面对美联储官员的讲话进行分析决策依据的描述。

研究团队希望利用这个工具来回答一个核心问题:人工智能是否能够可靠、准确地分析美联储的政策信号,从而为投资者提供实际参考。

报告指出,该人工智能工具在分析高度相关的语音方面表现出色,其输出质量可与“勤奋的初级分析师”相媲美。尤其是在判断政策倾向时,人工智能的结果与人类专家基本一致。

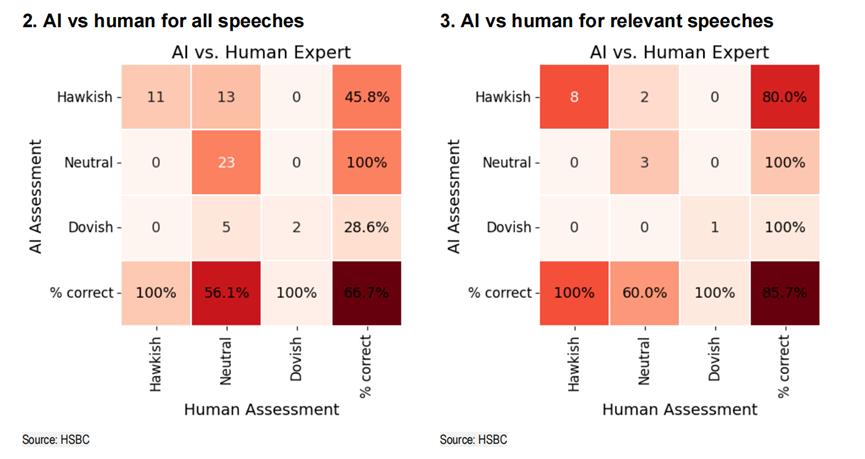

例如,在研究的 54 篇演讲中,人工智能在判断其“中性”时与人类专家完全一致,在评价“鹰派”或“鸽派”时表现出较小的偏差。

“我们可以看到,现在对于鸽派或中立的演讲没有分歧。对于模型认为鹰派的 10 篇演讲,我们的人类专家对其中 8 篇演讲同意了这一观点,而其他专家中只有 2 人认为是这样。”讲话是鸽派或中立的。”

02 AI的缺点:随机性和“创造性”挑战

尽管人工智能工具展示了一定的能力,但报告也指出了人工智能的一些缺陷。

首先,生成式人工智能的“创造力”有时会引发问题,尤其是在处理与货币政策无关的演讲时。人工智能可能会伪造信息来“满足”用户的需求。这种现象被称为“幻觉”,会严重损害用户对该工具的信任。

“经过训练,表现出强烈的帮助愿望的人工智能模型往往会编造信息来给你答案,而不是提醒你你的问题令人困惑或无法回答。”

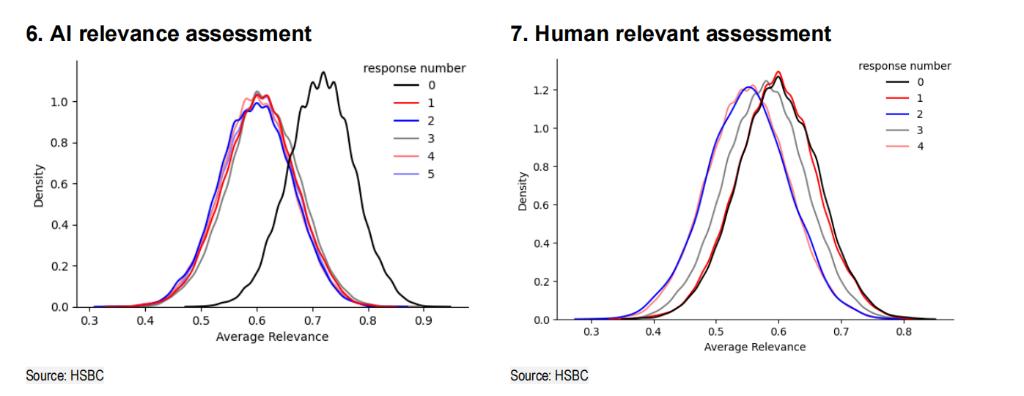

此外,AI工具在重复性任务中的不一致也是一个关键挑战。报告发现,即使在相同条件下,相同语音的人工智能分析结果也可能不同。

汇丰研究团队强调,虽然人类分析师在一定程度上也存在主观性,但单个分析师在不同时间对同一内容的解读通常是一致的,但人工智能无法保证这一点。

03 AI能否取代分析师?

汇丰银行的研究表明,虽然人工智能工具在分析任务中具有一定的表现,但仍然无法完全取代人类分析师的角色。

报告指出,人工智能在一些更基本和重复性的任务中表现良好,例如过滤相关信息和生成摘要。但在涉及复杂推理和深度解读的工作中,人工智能与人类的差距依然明显。

汇丰表示,人工智能工具的表现与初级分析师的水平相似,但它无法像人类一样通过经验和反馈不断改进。这对于企业来说尤其重要,因为他们不仅要培训当前产出的分析师,还要培训未来增长潜力的分析师。

报告还强调,人工智能的“随机性”和“创造性”品质虽然给技术带来了灵活性,但也成为广泛应用的障碍。在金融市场等精度要求较高的领域,用户对结果的稳定性和可信度有着极高的要求。如果AI工具的产出需要人类专家的反复验证,其所谓的效率提升就会大打折扣。

“但是当你询问人工智能工具的意见时,它的意见会随时发生变化。除非人性发生根本性改变,否则人工智能工具很可能无法充当值得信赖的顾问。这在短期内是不可能的。看来不太可能。”

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/272713.html