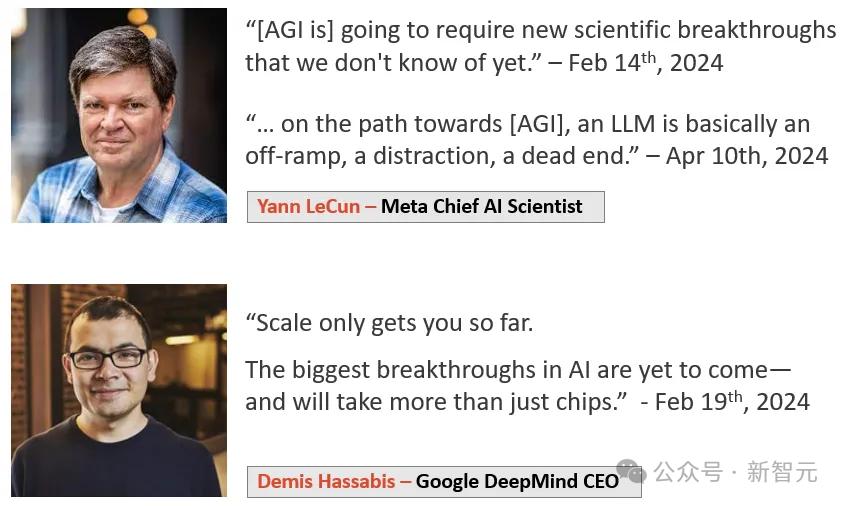

就在刚才,LeCun背叛了!

2023年12月,他坚定地坚称:人类水平的人工智能距离我们还有10到20年的时间。

然而就在最近,他却突然改变了说法!

现在,他说:五到十年内,我们将拥有人类水平的人工智能。

主持人问:我们感觉您之前不太喜欢这个观点。你之前不是说AGI离我们很远吗?

LeCun立即否决:不,我认为AGI离我们并不遥远。

他还强调,他对AGI何时到来的预测与Sam Altman和Demis Hassabis等人的预测没有什么不同。

简而言之,AGI很可能在十年内到来,但不太可能是明年或后年。

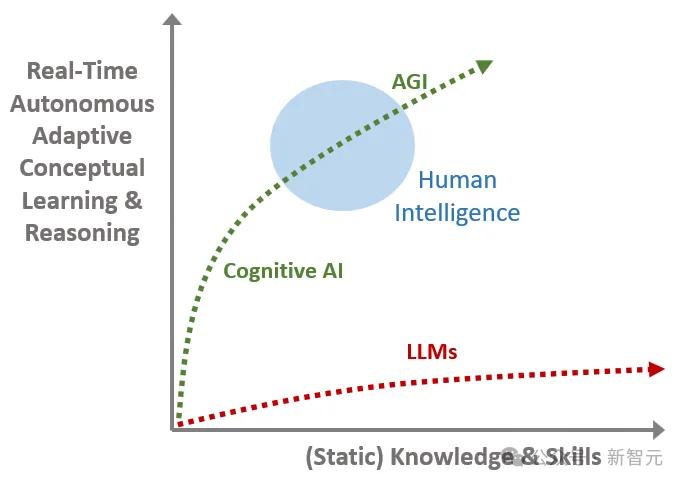

然而,尽管他改变了对时间的预测,但他并没有改变他认为当前的大型语言模型架构是死胡同的观点。

他表示,我们不能盲目推断LLM的能力并得出结论,只要我们继续扩展,使用更大的超级计算机和更多的数据,AGI就会出现。

我们需要的是像 JEPA 这样的新架构,即能够向周围世界学习的系统。这种AI可以根据重要性来规划一系列的行动,而不是像现在的LLM那样,一个词一个词地生成另一个词,而无需思考。

简而言之,我们需要系统2,而不是系统1。目前的LLM仅限于系统1阶段。 LeCun讨论的“目标驱动的人工智能”系统就是系统2。

不少网友对此感到震惊:他不是坚决拒绝AGI离我们很近的说法吗?

有人解释说,这很可能是因为大家还缺乏AGI共识的定义,因为AGI的定义很模糊,所以无论怎么说,都可以自圆其说。

其中,下面这条消息最搞笑。

网友们表示,可能有Meta内部人士与他交谈过。他表示,如果要实现AGI,就必须吸引大量投资。如果我们还说AGI遥不可及,我们就骗不了更多的投资者了!

人工智能的核心问题:更好的世界思维模型

近日,LeCun 接受了 Nikhil Kamath 主持的 People by WTF 专栏采访,讨论了许多有关 AI 的问题。

LeCun 在巴黎的学校学习 EE(电气工程),但随着学习的进展,他对数学、物理和人工智能中更基本的问题变得更感兴趣。

在EE的学习中,总有一些课程涉及到计算机。 20 世纪 80 年代,LeCun 就已经与数学教授一起开展独立项目。

现在,LeCun已经成为图灵三巨头之一。

作为一名科学家,他试图建立一个世界的因果模型。

在他看来,我们面临的几乎每一个问题都源于人类知识和智慧的缺乏。我们犯错误只是因为我们不够聪明,没有意识到问题的存在,因此无法找到解决方案。

LeCun 说,如果我们再聪明一点,如果我们对世界如何运作有更好的心智模型,我们就会比现在犯更少的错误,并做出更理性的决定。

而这也是AI领域的核心问题。

当今世界的一个大问题是人们对了解事实不感兴趣,不愿意自我教育。然而,人工智能有潜力放大全人类的整体智能,这是解决许多人类问题的关键。

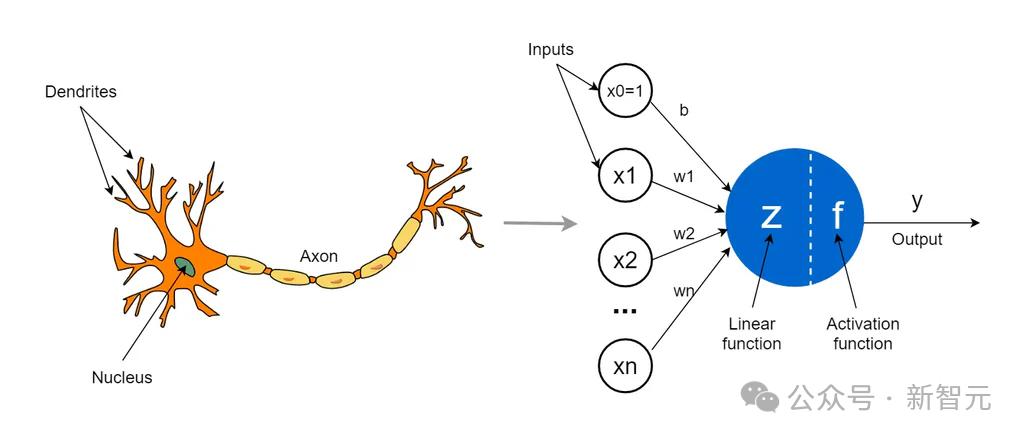

智能是当大量简单元素在网络中互连时发生的一种现象。

在 20 世纪 40 年代和 20 世纪 50 年代,人们开始发现智力和记忆来自于神经元之间连接强度的简化方法。大脑学习的方式是通过改变神经元之间的连接强度。

因此,有人提出了理论模型,并用电子电路重现了它们。

经典计算机科学的出现:启发式编程

根据解决问题的能力和学习能力,人工智能形成了两个分支。

后者在20世纪50年代和1960年代取得了一些成果,但在1960年代后期失败了。由于当时设计的神经网络学习程序非常有限,不可能用它们来创建真正的智能机器。

然而,它在模式识别工程领域产生了很大的影响。

接下来,他们讨论了启发式编程。

机器学习最简单的例子是感知、解释图像和解释声音。这就是经典计算机科学出现的原因。

我们编写一个程序,在内部搜索解决方案,并有办法检查它提出的解决方案是否合适。这是启发式编程。

然而,我们无法穷尽所有可能的解决方案来找到最佳解决方案,因为解决方案的数量非常大。

就像国际象棋一样,移动顺序是指数顺序的,之后我们需要启发式方法让树搜索或专家人工智能运行一个函数来尝试达到最终状态。

好系统和坏系统之间的区别在于系统是否足够聪明,能够在不执行详尽搜索的情况下找到好的解决方案。

这导致了人工智能领域的专家系统或基于世界的系统。它们与搜索的概念密切相关。

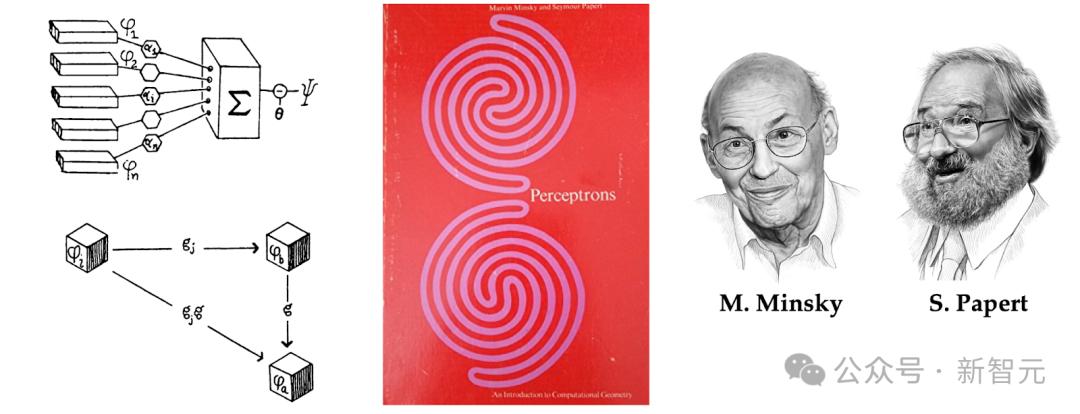

提出了一种算法来改变神经元之间的连接强度,以便它们能够学习任务。第一台这种类型的机器称为感知器,于 1957 年提出。

麻省理工学院教授 Marvin Minsky 和数学家 Seymour Papert 共同撰写了《Perceptron》一书。这种统计模型识别在现实世界中有着巨大的应用。

然而感知器有一个严重的问题,那就是它可以访问的函数类型非常有限。我们没有办法用一张自然的图片来训练系统来判断里面是否有狗、猫或桌子。

该系统不够强大,无法真正计算如此复杂的函数。

强化学习和自我监督学习

20 世纪 80 年代,神经网络和深度学习改变了这一切。事实上,神经网络是深度学习的鼻祖,深度学习可以算是它的新名字。

这个想法是,无需对机器进行完全编程来执行某些操作,而是可以对机器进行数据训练。

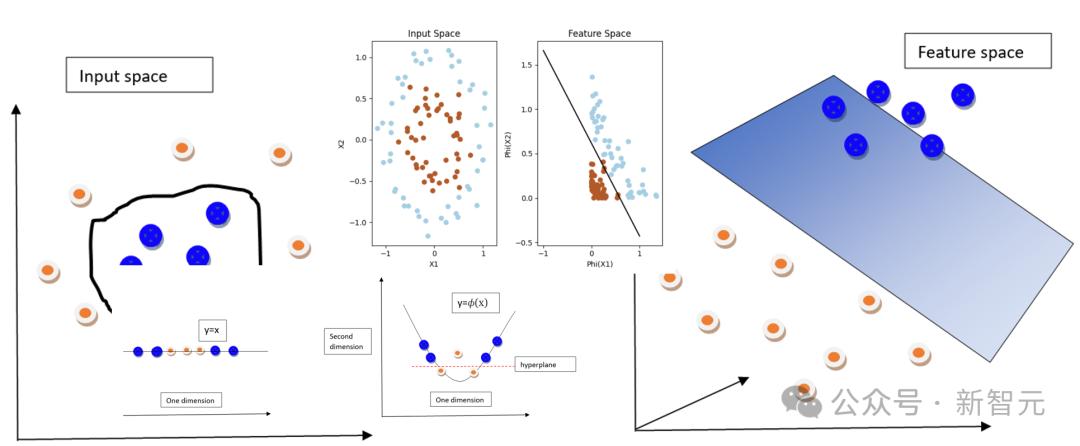

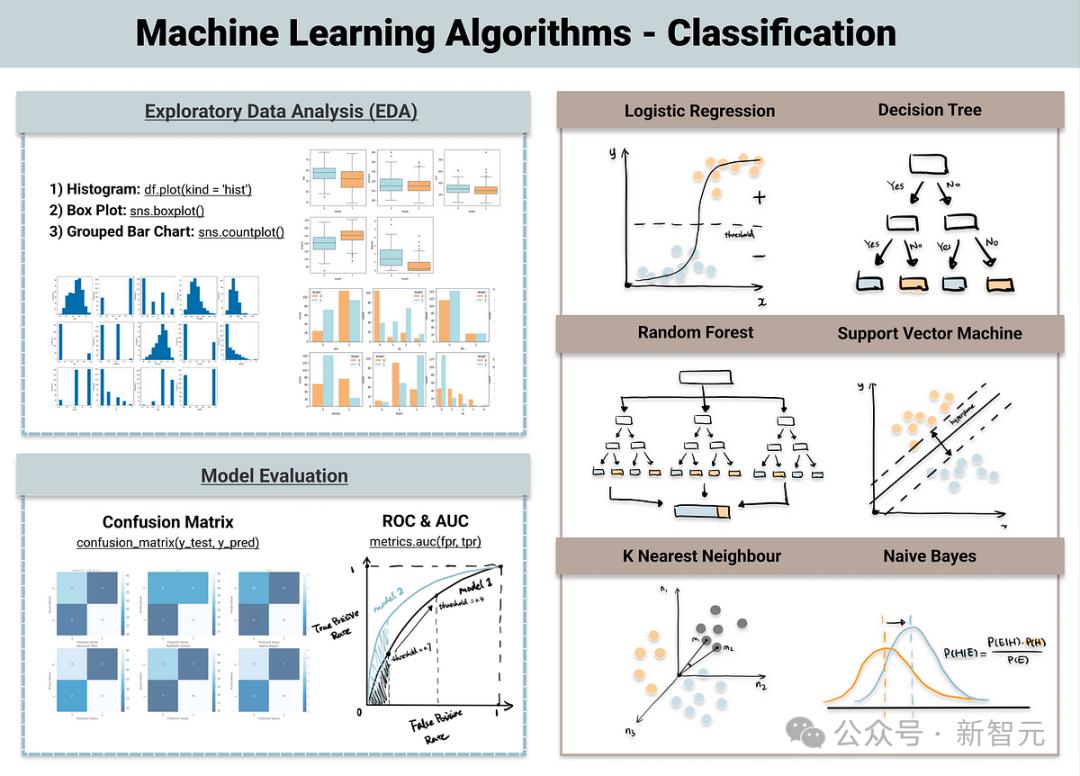

机器学习中,有线性回归、分类树、支持向量机、核方法、贝叶斯推理等。

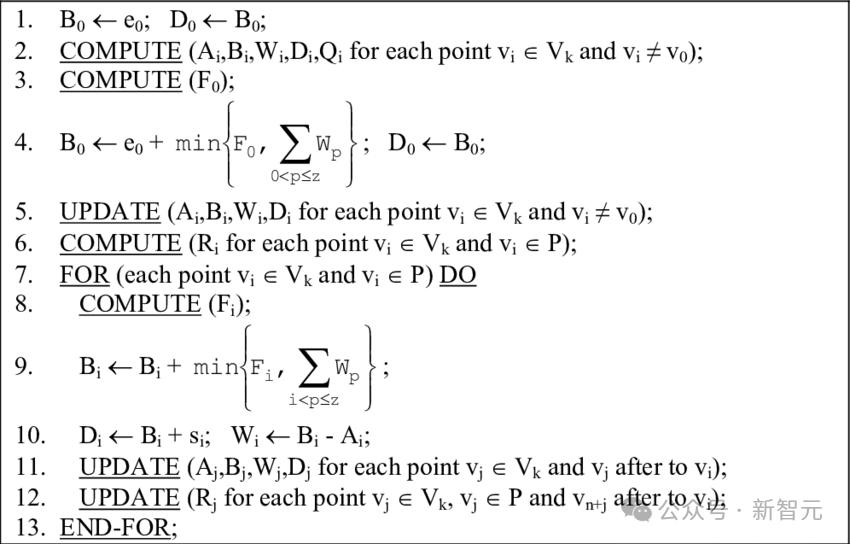

在某种程度上,他们都遵循这个模型:我们构建一个程序,但它实际上还没有完成。它有一堆可调整的参数,输入输出函数是由这些参数的值决定的。

因此,我们使用迭代调整技术从数据中训练系统。如果示例答案不正确,请调整参数以使其更接近我们想要的答案。

在强化学习中,我们不会直接告诉系统正确答案。只是告诉它它产生的答案是好还是坏。

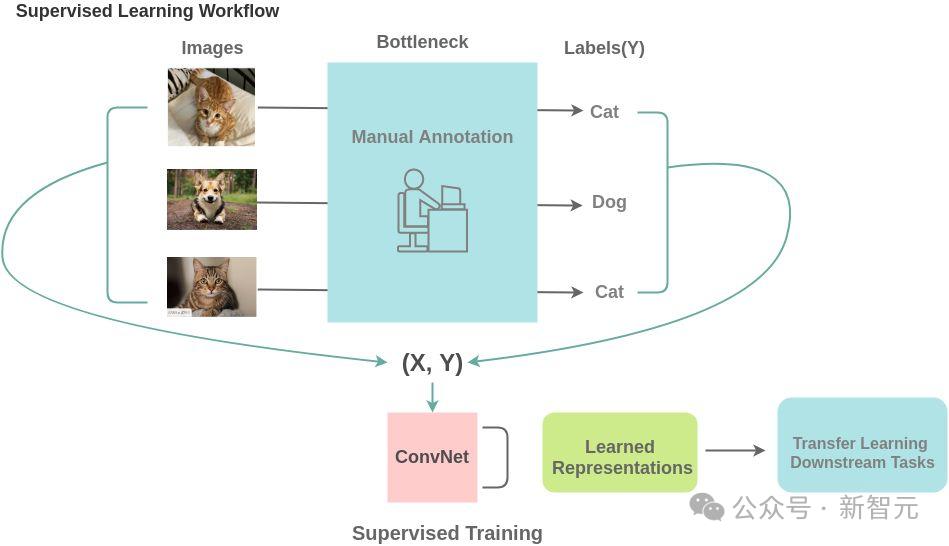

而近五六年表现非常突出的自监督学习,确实成为了聊天机器人和自然语言理解系统成功的主要因素。

它更类似于监督学习,但不同之处在于不需要有显式的输入和输出,系统被训练为从输入生成输出。

唯一的区别不在于算法本身,而在于系统的结构以及数据的使用和生成方式。

我们不需要有人一张一张地浏览数百万张图像并告诉它桌子旁边是一只猫还是一只狗。我们只需展示一张狗、猫或桌子的图片,对其进行损坏,部分更改,然后要求系统从损坏的图像中恢复原始图像。

这是自我监督学习的一种具体形式。

这对于自然语言理解的成功起着关键作用。

例如,在大型语言模型中,我们训练一个系统来预测下一个单词,但只允许它查看之前的单词。这需要以特定的方式构建神经网络,使得用于预测单词的连接只看到前面的单词,这样就不需要干扰输入。

最终,系统经过训练可以根据内容预测下一个单词。

在Transformer架构下,基本原理是将每个输入与其他输入进行比较并生成权重。

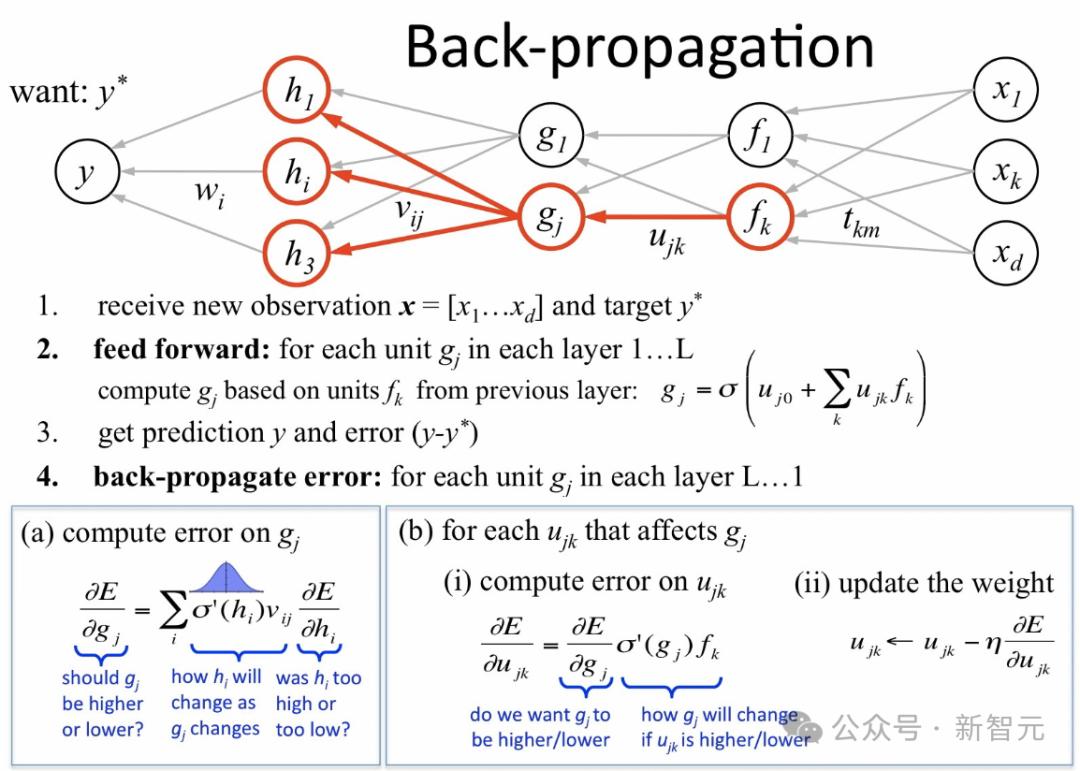

反向传播算法和卷积神经网络

反向传播算法的作用是,当我们展示C的图像并告诉系统这是C时,它可以激活相应的输出神经元,而不激活其他神经元。

它知道如何调整参数,使输出更接近我们想要的结果。这是通过向后传播信号来实现的,基本上确定每个权重对每个输出的敏感程度,从而改变权重,以便好的输出增加,坏的输出减少。

其实反向传播算法之前就已经存在了,只是当时人们并没有意识到它可以用于机器学习。后来从20世纪80年代开始流行。

反向传播算法至关重要,因为它打破了 Minsky 和 Papert 所说的 20 世纪 60 年代感知器的局限性,从而掀起了巨大的浪潮。

但人们后来意识到训练这些神经网络需要大量数据。

没有互联网,数据不充足,计算机速度也不快,所以兴趣减弱了。

但在 80 年代末和 90 年代初,LeCun 正在进行的项目之一是,如果想让这个系统识别图像,就需要以特定的方式连接神经元,以促进系统的注意力。

他从生物学中汲取灵感,借鉴 20 世纪 60 年代的经典神经科学研究,以分层方式组织神经元之间的连接,以便它们能够找到良好的图像识别解决方案。

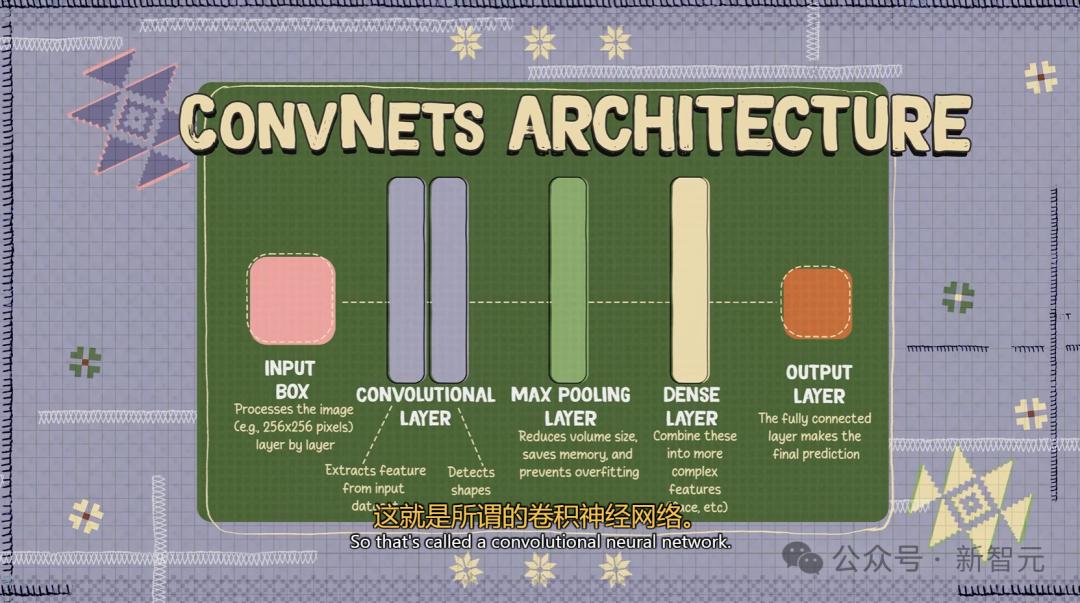

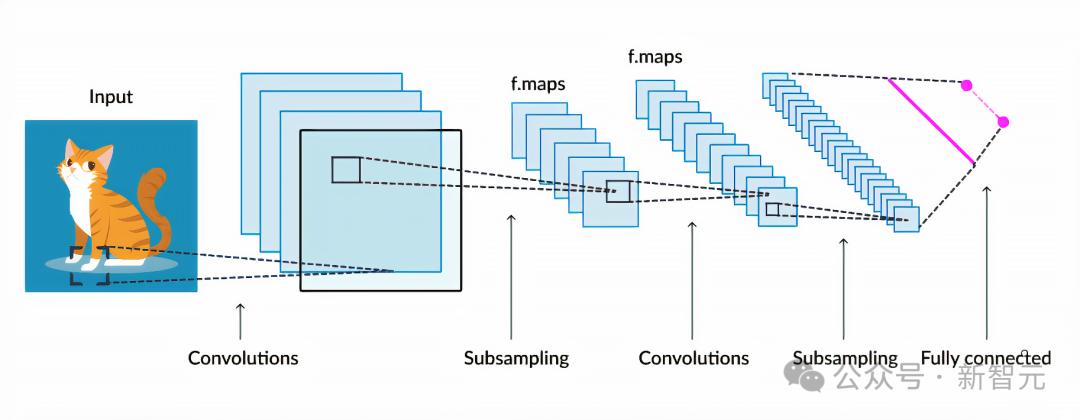

这称为卷积神经网络。

其设计灵感来自于视觉皮层的架构。

卷积神经网络特别适合处理来自自然世界的数据。如果我们拍摄一张照片并拍摄两个相邻的像素,它们很可能具有相同的颜色或相同的强度。

图像和音频等自然数据以及几乎所有类型的自然信号都具有固有的结构。如果我们以特定的方式构建一个神经网络来利用这种结构,它将学习得更快并且需要更少的例子来学习。

卷积是卷积神经网络的一个组成部分。

这个想法是,一个神经元查看输入的一部分,另一个神经元查看输入的另一部分,但它计算与第一个神经元相同的函数。

然后,将相同的神经元复制到输入中的所有位置,以便我们可以将每个神经元视为在输入的一个部分中检测特定模式,并且所有神经元在输入的不同部分中检测相同的模式。模型。

所以现在如果你接受一个输入并移动它,你会得到相同的输出,但在不同的位置,因为同一个神经元正在观察并检测不同位置的相同模式。

这就是为什么它给出了这种位移等方差,这称为卷积。

它们对于真正的神经元来说就像飞机翅膀对于鸟类翅膀一样——相同的功能,相同的概念。

AI 捕捉语法的机器学习机制

香农的 n 游戏模型是一种语言模型。

我们可以在字符级别执行此操作,但在单词级别执行此操作更加困难,因为可能有一万个可能的单词。

我们需要通过在大型文本语料库上训练来填充这个概率表,以训练单词模型或语言模型。

但超过一定的上下文长度,它就变得不切实际了。因为它需要大量的计算和工作,并且还涉及内存来存储所有这些表,所以这些表的填充也将非常稀疏,因为即使有数十亿字的文本,大多数短语组合也不会出现。 。

如果您使用像 Transformer 这样的架构,您可以构建一个可以根据上下文中的单词预测下一个单词的系统。

如果你让这个上下文尽可能大,比如数千、数万、甚至一百万个单词,你将得到一个具有紧急属性的系统。如果你让它们足够大,你可能能够达到数十亿或数百亿的参数。

在这种情况下,如果是文本,他们会重述谜题的答案,并为您提供可能需要的问题的答案。

这个过程主要是检索,有一点推理,但不多。

真正令人惊讶的是这些系统操纵语言的方式令人印象深刻。

要知道,人类在操纵语言方面实际上相当有限,但人工智能似乎做得很好——它们捕获了语法的机器学习机制。

大语言模型不是通向 AGI 的道路

在语言中,可能性是有限的,我们确实可以输出概率列表。

但如果你想预测视频中会发生什么,帧数是无限的。一张图像有一千个像素和三个像素颜色值,因此需要生成三百万个值,但我们还不知道如何表示所有可能的图像集上的概率分布。

这就是我们许多人看到人工智能的下一个挑战的地方。

如果从视频和图片中学习是下一阶段,那么它应该放在哪里?属于目前大语言模型的范围吗?

不,它与大型语言模型完全不同。这就是为什么LeCun一直明确表示大型语言模型并不是通往人类水平智能的道路。

这也是为什么大型语言模型无法理解物理世界,无法真正理解和处理当前形式的现实世界。

尽管法学硕士非常擅长处理语言,但他们也可能犯非常愚蠢的错误,这表明他们不了解世界是如何运作的。

我们确实没有一个系统来理解您的猫可以理解的基本事物。

所以LeCun一直直言最聪明的LLM并不比你的猫聪明。

JEPA:LeCun的“世界模式”

这就引出了人工智能领域的下一个挑战——如何构建一个可以通过视频学习世界规则的系统。

人类对周围世界的认识,尤其是在生命的早期阶段,很大程度上是通过“观察”获得的。

以牛顿的“第三运动定律”为例。即使是婴儿或猫,在多次将东西从桌子上推下并观察结果后,自然会明白任何高处的物体最终都会掉落。

这种理解并不需要长期指导或阅读大量书籍才能达到。

相比之下,现在的LLM只适合离散的语言世界,无法理解连续的高维物理世界,比如视频中的动态。

这种限制使得LLM很难处理现实世界的问题,这也是为什么LLM可以通过考试、写文章,但我们还没有家用机器人和L5级自动驾驶。

目前LLM的内存分为两种:

1.参数记忆:训练过程中学到的知识,但无法逐字重复训练数据。

2、情境记忆:通过输入提示词暂时存储信息,但范围有限。

然而,真正理解物理世界的人工智能需要持久的记忆,类似于人脑中的海马体,能够存储和检索长期信息。然而,目前的LLM缺乏独立的记忆模块,无法高效地搜索和评估多个可能的答案。

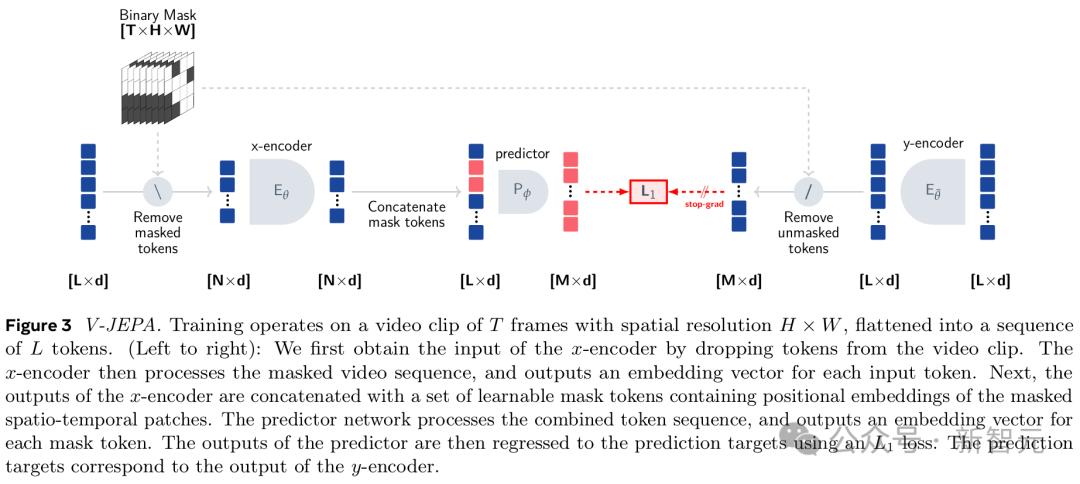

为了实现这一目标,我们需要新的架构来摆脱法学硕士的自回归方法,而是应用视频的自监督学习。

具体做法是让AI通过预测视频接下来的变化来了解世界的底层结构,而不是简单地生成每个像素的变化。

这种预测能力可以帮助AI构建“世界模型”来支持规划和推理。例如,预测推杯子、抓东西、举东西等动作的结果是否能够达到目标。

回到如何让机器通过观察世界来学习的问题。显然,我们不能依赖当前仅生成视频中每个像素的生成架构。

为此,LeCun团队尝试了近15年,并于5年前提出了一种全新的方法——JEPA(联合嵌入式预测架构)。

LeCun始终相信世界有“世界模型”,并致力于开发新的类脑AI架构,旨在通过更真实地模拟现实世界来解决当前系统的局限性,例如错觉和逻辑缺陷。 。 。

这也是为什么如果人工智能要接近人类智能,它需要像婴儿一样学习世界是如何运作的。

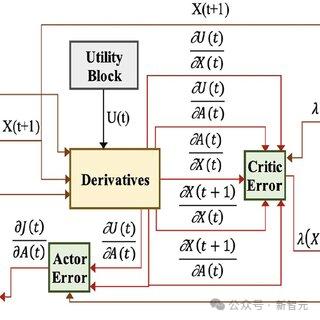

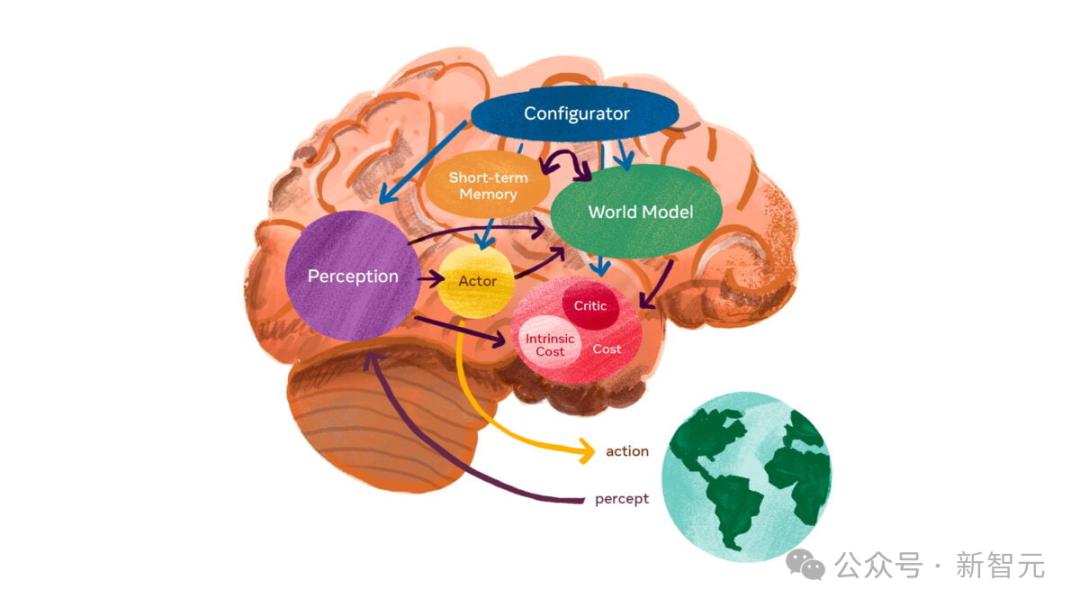

该世界模型的架构由6个独立的模块组成:配置器模块、感知模块、世界模型模块、成本模块、短期记忆模块和参与者模块。

其中,核心是世界模型模块,其目的是根据感知模块的信息来预测世界。你能感觉到人们在移动吗?汽车转弯还是继续直行?

此外,世界模型必须学习世界的抽象表示,保留重要的细节并忽略不重要的细节。然后,它必须在适合任务级别的抽象级别上提供预测。

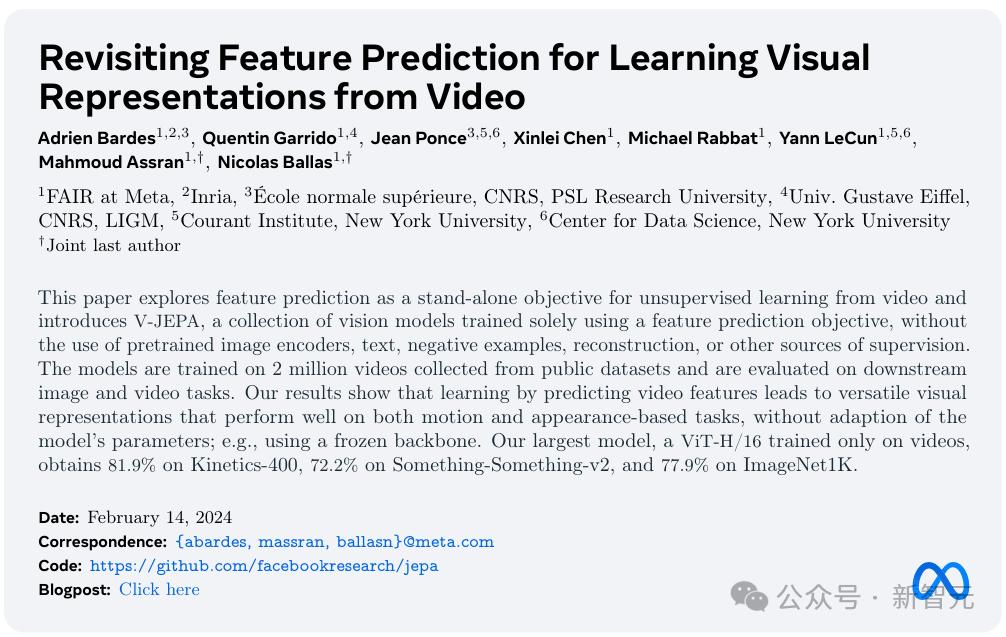

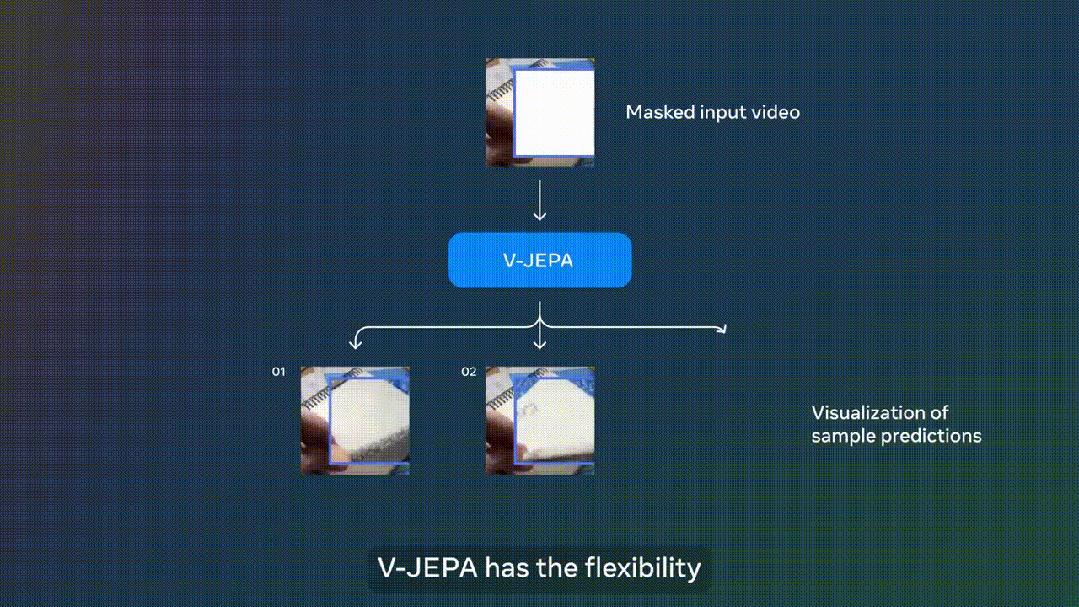

自2022年LeCun首次提及JEPA以来,I-JEPA和V-JEPA分别具有基于图像和视频的强大预测能力。

值得一提的是,V-JEPA的发布恰巧与OpenAI推出Sora模型的同一天。

论文地址:

与生成式AI模型完全不同,V-JEPA是一种“非生成式模型”。它通过预测在抽象空间中表示的视频的隐藏或缺失部分来进行学习。

这类似于图像联合嵌入预测架构(I-JEPA),它通过比较图像的抽象表示而不是直接比较“像素”来学习。

与尝试重建每个丢失像素的生成方法不同,V-JEPA 能够丢弃难以预测的信息,从而使训练和样本效率提高 1.5-6 倍。

由于采用自监督学习方法,V-JEPA可以完全依赖未标记数据进行预训练,然后使用标记数据进行微调。

当您看到下面视频中的动作时,V-JEPA 会说“将纸撕成两半”。

又例如,如果在笔记本电脑上观看的部分视频被屏蔽,V-JEPA 可以对笔记本电脑上的内容做出不同的预测。

这些都是V-JEPA观看200万视频后获得的超能力。

综上所述,现有的大语言模型属于系统一思维,即快速、直观的响应。 AGI需要的是系统2思维:深度思考、理性分析、战略规划。

对此,LeCun提出的“目标驱动人工智能”架构基于系统二思维,即能够向现实世界学习并进行分层规划。

参考:

本文来自微信公众号“新智元”,编辑:埃涅阿斯,好困,36氪授权发布。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/272724.html