鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

DeepSeek 迅速火爆并出圈,各个大的第三方都在紧赶慢赶地纷纷接入,它已经成为了一种现象级的议题。

但话题的热点过去之后,回归到实际落地这一关键要点上,新的问题开始进入到一线从业者的视野里。

怎样才能简单、高效用好DeepSeek?

核心在于,对于企业用户来说,特别是那些更多来自传统行业的企业。在它们自身的业务中引入推理模型,并非仅仅是简单地接入一个 API 这么简单。要想让其运用得好,还必须结合本地的数据以及业务场景。

这意味着存在几方面的困难,比如算力基础设施的建设与管理,还有支持大规模在线业务的性能优化,以及数据的安全合规问题等等。

本周,DeepSeek 官方开始围绕 AI Infra 持续开源内部的秘籍。这对于模型从业者们来说是一件令人高兴的事情。然而,在产业结合层面,这些开源的秘籍却有点“远水解不了近渴”。

好消息是,云厂商们已经第一时间出手。

在这个关键时刻,火山引擎正式推出了 AI 一体机。它提供了一站式的解决方案,具备更高的性能优化、更全面的产品能力以及更好的安全防护。其目标十分明确,即帮助用户在大模型应用领域,以低门槛的方式实现创新技术的探索和业务的增长。

本次发布推出了专门的 DeepSeek 版本,这个版本能够支持 DeepSeek R1 系列模型和 DeepSeek V3 系列模型,并且是开箱即用的,在短短一小时左右的时间内就可以完成部署。

DeepSeek应用端到端解决方案

所谓“AI 一体机”,意思是将人工智能所需的硬件与软件整合在一个设备之中,这样用户无需进行繁杂的安装与配置等操作,就能够直接对其进行使用,它是一种“AI 专用终端”。

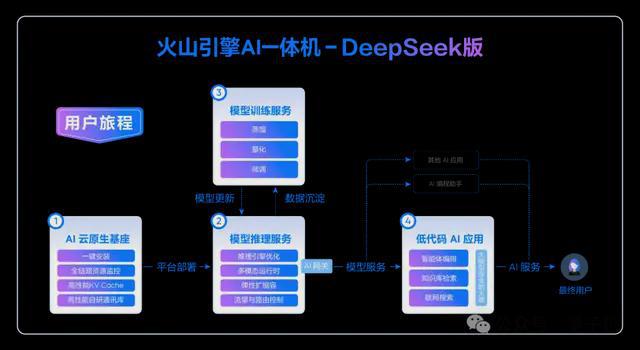

以火山引擎 AI 一体机 - DeepSeek 版为示例,它支持 DeepSeek R1/V3 全系列模型,同时还具备火山引擎自家的 HiAgent 智能体平台、大模型防火墙以及轻量模型训练平台。凭借这些,实现了对模型部署、管理、推理、微调、蒸馏等方面的能力覆盖,也实现了对 AI 应用开发的全链路能力覆盖。

火山引擎AI一体机-DeepSeek版产品架构

具体而言,火山引擎 AI 一体机 - DeepSeek 版具有如下特点:其一,其二,其三等。(可根据实际特点具体描述)

开箱即可使用,不需要进行复杂的配置,也不需要依赖外部的环境,在一个小时左右的时间就能完成部署,从而可以快速地体验到完整的服务。

起步较为轻便,运用的是轻量云原生架构。只需要 1 台 GPU 服务器就能够进行部署,而 3 台节点就可以达成高可用的生产环境。

提供一站式体验,它集成了主流开源模型以及豆包大模型,涵盖了底层基础设施,还有企业级模型服务平台(MaaS)以及智能体开发(HiAgent),能够提供模型调用、部署、精调、测评、应用开发调优等全方位的功能。

软硬件协同进行工作,对 DeepSeek 全系列模型进行深度优化。通过火山引擎自研的通信库 veCCL、推理引擎,以及对算子进行优化和构建高性能的 KV Cache 等全链路技术,使得核心推理性能提升了 20%以上。

安全且高效,它提供了 100 多种行业应用模板以及 100 多种适配插件。企业能够通过自身的工作流来自定义专属的 AI。同时,它还集成了大模型防火墙和 AI 网关,以此满足安全与合规方面的需求,成功打通了从模型到应用的“最后一公里”。

分析其技术组成,能够发现火山引擎 AI 一体机主要着力解决的有 3 个方面的问题。

首先,是基础设施优化和平台运维。

传统的软硬件系统中,软件与硬件是相对独立的。通常情况下,这类系统缺少软硬件之间的协同优化。正因如此,它会对系统的运行效率产生影响。

另外,经常会因为运维系统不完善,导致系统常常出现各类不稳定的情形。

火山引擎 AI 一体机以 AI 云原生基座为基础,在基础设施方面,具备分布式缓存的能力,具备集合通信优化的能力,还具备软硬件协同的资源调度的能力。

在平台运维方面,通过一键部署的能力,能够为平台稳定运行提供保障;通过水平扩容的能力,也能为平台稳定运行提供保障;通过平滑升级的能力,同样可以为平台稳定运行提供保障;通过监控告警的能力,也可以为平台稳定运行提供保障。

其次,是推理模型的实际部署。

以 DeepSeek 为例,它是开源模型。然而,从模型本身到上线生产环境这一过程中,实际上需要面对诸多工程问题,比如优化问题、稳定保障问题以及合规检查问题等。

火山引擎 AI 一体机内置 DeepSeek 等开源模型。它为模型提供了优化的推理引擎。它为模型提供了分布式缓存。它为模型提供了高效的路由能力。这些能力能降低 Token 延时。这些能力能最大化模型服务吞吐量。

同时为推理服务提供流量治理能力,保障其可靠、高效、稳定运行。

最后,是模型迭代和AI应用开发。

结合自身业务数据来精调基础模型,这是一个需要大量技术投入的过程;根据业务需要开发 AI 应用,这也是一个需要大量技术投入的过程。

而很多行业用户往往存在专业人才不足、开发效率低的问题。

火山引擎 AI 一体机集成了从模型调用到应用开发的一站式工具,它提供了全方位的辅助,包括任务管理、低代码开发、灵活集成方式以及大模型安全等。这些辅助能够有效降低企业的应用门槛和开发成本。

大模型应用经验加持

除了“DeepSeek”这个热点之外,值得关注的是,火山引擎推出的 AI 一体机,一方面为企业“拥抱”DeepSeek 等开源模型铺设了一条快速路,另一方面背后还有火山引擎在大模型应用开发和市场领域所积攒的经验的加持。

更高性能优化

展开更多细节来看,在性能优化方面,市场上大多数基于 INT8 精度的 DeepSeek 解决方案是一种情况,而火山 AI 一体机支持的是 DeepSeek 官方推荐的 FP8 精度,这两者是不同的。

同时还进行了基础架构和推理引擎的优化。

在大模型服务启动这方面,70B 模型的启动是通过高性能缓存来进行加载的,并且模型加载的速度相较于本地盘提升了 10 倍。而推理服务采用的是按需加载的方式,使得服务启动的时间提升了 4 倍。

开源算子优化能够提升主流模型的吞吐量。例如 flashattention v3 算子优化,在部分配置硬件上可以将主流模型的吞吐量提升 10%。

高性能 KV Cache 缓存具备 Automatic Prefix Cache 功能,此功能可以有效增强大模型的长上下文记忆能力。火山引擎表明,在内部环境进行测试后,得出了如下结果:

火山引擎针对单机多卡和多机多卡的模型推理和训练场景,在 NCCL 的基础上自研了 veCCL 集合通讯库。在多卡推理的 TP 场景中,能够使核心推理指标提升 5%。

更全产品能力

在产品能力方面,火山引擎的 AI 一体机将火山方舟的同源能力进行了集成。它具备支持模型精调的功能,也具备推理的功能,同时还具备测评的全方位功能和服务。

可以单机 8 卡部署满血的 DeepSeek 等开源模型,还预置了 100 多种插件,如联网搜索等,以及海量的行业应用模板,能够提供零代码和低代码的分钟级 AI 应用构建。

在算力方面,它全面兼容英伟达 GPU 以及国产的异构计算卡,以此来满足多样化的算力需求。在模型官方所推荐的精度之下,无论是在进行推理任务的时候,还是在进行训练任务的时候,都能够实现高效且稳定的性能表现,既兼顾了模型的精度,又兼顾了计算的效率。

更好安全防护

火山引擎 AI 一体机在内容合规和数据安全方面引入了自研的大模型应用防火墙。

DeepSeek R1 在 DeepSeek R1/V3 上进行测试,接入大模型应用防火墙后,其有害内容生成率从 9.1%降至 0.91%;DeepSeek V3 在 DeepSeek R1/V3 上进行测试,接入大模型应用防火墙后,其有害内容生成率从 17.3%降至 2.7%。

大模型应用防火墙能够降低数据泄露风险,也能防御提示词注入攻击等安全威胁。在 DeepSeek R1/V3 上进行测试后发现,接入大模型应用防火墙后,针对 DeepSeek R1 的提示词攻击成功率从 76%降低到了 1%,针对 DeepSeek V3 的攻击成功率从大于 24%降低到了小于 1%。

大模型应用防火墙能够让特定知识所关联的模型幻觉现象降低 90%多。

新技术突破所激发的肾上腺素逐渐消退之时,DeepSeek所引发的讨论与思考,正逐步迈向第二阶段:

从跟风热议,到更加务实的落地探索。

或许不像模型突破本身那样具有话题性,然而这意味着大模型技术更深且更长远的影响已经被纳入到思考和实践之中。

DeepSeek 这条鲶鱼引发了风云的变动,它向全球的大模型研发者们给出了新的挑战,在这同时,还正在促使行业进行更深入的思索以及技术的融合。

谁能把握住机会?火山引擎已经率先迈步。

— 完 —

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/274568.html