在 Nature 论文发表几个月后,正是争议的初始阶段之后,Bae et al., Google 的文档和开源代码,Nature peer review,Yue et al. 提供了更多的数据。

Nature 给出了 Mirhoseini 等人的同行评审论文和对作者的反驳。在漫长的来回沟通中,作者向审稿人保证,在 RL 放置后,宏的位置没有被修改,确认了宏是粗粒度的网格放置。在几份提交的文件中,Bae 等人满足了 Nature 审稿人的要求,并在 17 个公开可用的芯片设计示例上对 Google 的技术进行了基准测试,结果表明,以前的方法明显优于 Google RL。

美国和德国的一些教授公开表达了对《自然》论文的质疑。当研究人员注意到 Google 开源版本中的缺陷时,例如分组(聚类)过程,Google 工程师发布了更多代码(但不是全部),这反过来又引发了更多问题。

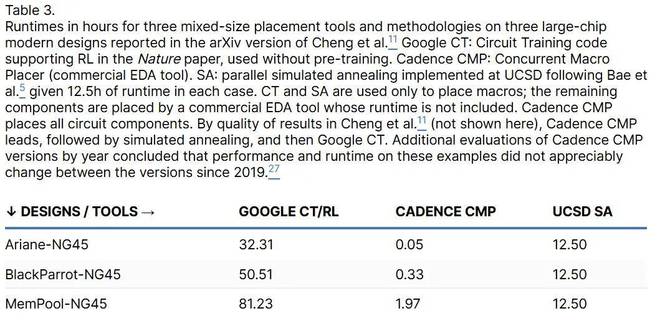

又过了一年,最初的怀疑越来越大,因为结果表明,当宏布局不仅限于网格时,人类设计师和商业 EDA 工具的性能都优于 Google 的方法。在 Cheng 等人的表 2 中,作者估计了 RL 优化的代理成本函数与 Nature 论文表 1 中使用的芯片指标的秩相关性。Cheng 等人在表 3 中估计了基于 RL 的优化后芯片指标的平均值和标准差。

本文的表 2 给出了一些总结,你可以看到所有 chip 指标的 rank 相关性都很低,而 TNS 和 WNS 的噪声水平很高。

因此,Mirhoseini 等人依靠有缺陷的药物来优化 TNS 和 WNS,并产生了统计学显着性可疑的结果。可以注意到,Ariane-NG45 和 BlackParrot-NG45 上的 TNS 具有 σ/|μ |> 0.5。除了媒体的批评,Mirhoseini 等人还受到了三位美国教授的质疑。

商业工具的 (x, y) 位置未披露

UCSD 论文中提供的有力证据和确认表明,作者隐瞒了一个关键细节:在对输入网表进行聚类时,Google 代码中的 CT 合并会读取一个位置,以根据该位置重新组织集群。为了生成宏的 (x, y) 位置,论文作者使用了 Synopsys 商用 EDA 工具生成的所有电路元件(包括宏)的初始 (x, y) 位置。

Mirhoseini 等人的主要作者证实了这一步骤的使用,并声称它并不重要。但在 Cheng 等人的论文中,这一步将关键指标提高了 7-10%。因此,Mirhoseini 等人的结果需要未明确说明的算法步骤,例如从商业软件中获取 (x, y) 数据。

Cheng et al. 的论文还列出了更多论文中没有描述的技术,还提到了 Nature 论文、其源代码与 Google 芯片设计中实际使用的代码之间的差异。这些差异包括代理成本函数中术语的特定权重、邻接矩阵的构造与电路的不同,以及 Mirhoseini 等人的论文中没有来源或完整描述的几个“黑盒”元素。Bae et al., Cheng et al., Macro Placement Repo 提供了缺失的描述。此外,Mirhoseini 等人的结果与所使用的方法不符,因为论文中没有提到一些关键组成部分。结果和方法不能仅通过描述来重现。

训练数据和测试数据之间存在数据泄漏

根据 Mirhoseini 等人的说法,“当我们将战略网络暴露给更广泛的芯片设计时,它就不容易出现过拟合。

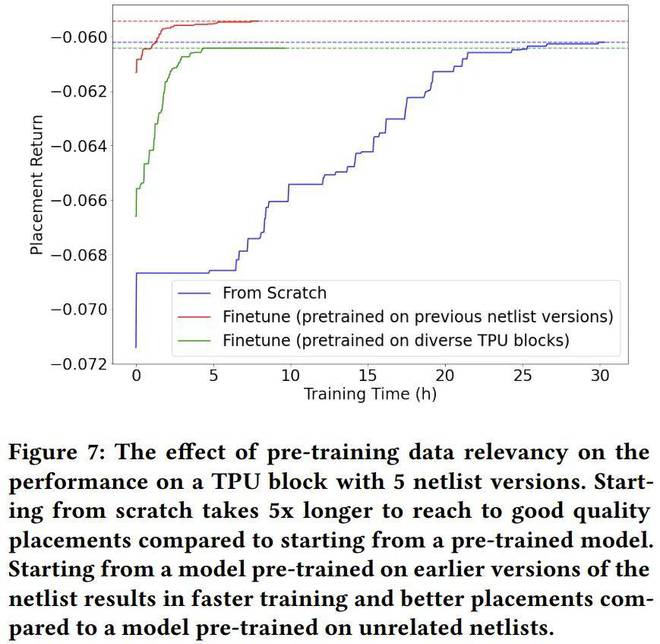

然而,Google Team 1 后来在 Yue 等人中表明,对 “多样化的 TPU 块 ”进行预训练并没有提高结果的质量。对 Previous Netlist Version 进行预训练将略微提高质量。预训练 RL 并在类似设计上对其进行评估可能是 Mirhoseini 等人方法中的一个严重缺陷。由于 Google 不会发布专有的 TPU 设计或每种设计的统计数据,因此无法比较训练和测试数据。

可能的限制

Mirhoseini 等人没有透露他们方法的主要局限性,但表示它可以在更广泛的投资组合优化中取得成功。Mirhoseini 等人的 Ariane 设计显示了相同大小的宏块:这是一个潜在的限制,因为商业芯片设计通常使用多个不同的宏大小。但是,它们不会报告每个 TPU 模块的基本统计数据:宏的数量及其形状、设计区域的利用率以及宏占用的区域百分比。根据同行评审和从 Google 工程师到 Cheng 等人作者的指导,TPU 模块的面积利用率似乎低于典型的商用芯片设计。

Google RL 在 Bae 等人和 Cheng 等人使用的具有挑战性的 Adya 和 Markov 公共基准上表现不佳(如图 2 所示),这表明存在未披露的局限性。

另一个可能的限制是预设(固定)宏的误操作,这在行业布局中很常见,但在 Mirhoseini 等人中没有讨论。通过干扰预设宏,网格划分会影响实际应用中的可用性。

这

在公共基准测试中表现不佳的原因也可能是由于专有 TPU 设计的过度拟合。

使用中等模拟退火基线

Google 的 Team 2 Stronger 基线用于评估芯片布局中的深度强化学习,通过在交换、移位和镜像操作中添加移动和随机操作,改进了 Google Team 1 在 Mirhoseini 等人中使用的并行 SA。当优化相同的目标函数时,这种改进的 SA 通常会在更短的时间内产生比 RL 更好的结果。

Cheng et al. 通过独立实现 SA 再现了 Bae et al. 的定性结论,发现 SA 结果的方差小于 RL 结果的方差。

此外,Bae 等人提出了一种简单快速的 SA 宏初始化启发式方法,并在比较 RL 和 SA 时均衡了计算时间。

鉴于 SA 在 1980 年代和 1990 年代被广泛使用,与较弱的 SA 基线相比,它自然导致对新 RL 技术的高估。

这篇 Nature 论文是否提高了技术水平?《

自然》杂志的一篇社论在评论该论文时推测,“这是一项重要的成就,将大大有助于加速供应链的发展。

但是,在多家芯片设计和 EDA 公司进行评估和复制尝试后,可以肯定地得出结论,这篇 Nature 论文没有取得任何重大成就,因为以前的芯片设计软件,尤其是来自 Cadence Design Systems 的芯片设计软件,可以更快地生成更好的版图。如果论文的审稿人或公众知道这些事实,那么该论文关于改进 TPU 设计的说法将是荒谬的。

Nature 论文声称人类比商业 EDA 工具产生更好的结果,但没有给出证实。

Google Team 2 和 UCSD 团队使用不同的方法将 Mirhoseini 等人的方法与基线方法进行比较,累积报告了与商业 EDA 工具、人类设计师、学术软件和 SA 的两个独立定制实现的比较。

Google Team 2 遵循 Mirhoseini 等人的描述,不提供初始布局信息。UCSD 团队试图复制 Google 实际所做的工作来产生结果(缺乏 Mirhoseini 等人的细节)。

Google Team 2 可以访问 TPU 设计模块,并证明预训练的影响实际上是最小的。

尽管 UCSD 团队无法访问 Google 的训练数据和代码,但他们能够获得与 Mirhoseini 等人相似的结果,而无需进行预训练。他们还按照 Google Team 2 的指示重新实现了 SA,并引入了几个新的芯片设计示例(表 1)。

在 Nature 论文中使用 RePlAce 与其预期用途不一致。Bae et al., Cheng et al. 通过正确使用 RePlAce,在 ICCAD 2004 基准测试中为 RePlAce 取得了优异的结果。

在 Nature 论文中使用的模拟退火的实现存在障碍,消除障碍(在相同的源代码库中)改善了结果。如果实施得当,SA 会使用更少的运行时产生比 Google CT/RL 更好的解决方案,并且两者都具有相同的代理成本函数。Bae 等人和 Cheng 等人证明了这一点。

与 Google CT/RL 相比,SA 继续改进线路长度和功耗指标。对于电路时序指标 TNS 和 WNS,SA 产生的噪声较少,但与 RL 的结果相当。回想一下,SA 和 RL 优化的代理函数不包括时间序列指标,这使得 SA 或 RL 实现这些改进的断言似乎值得怀疑。

Google CT/RL 未能提高人体基线、商业 EDA 工具和 SA 的质量。它也没有改善运行时 SOTA (表 3),作者没有透露每个设计数据或设计过程的时序。如果配置/实施得当,RePlAce 和 SA 将提供更强大的基准。

一个

反驳对这篇 Nature 论文的批评

尽管提出了媒体批评和技术问题,但作者未能消除复制 Mirhoseini 等人的方法和结果的剩余障碍。

这

加州大学圣地亚哥分校团队为克服这些障碍所做的工程工作,通过跟进 Google 第 2 团队对《自然》论文的批评,然后分析了许多问题。在 CT 代码库出现之前,Google Team 2 可以访问 Google 的 TPU 设计和论文中使用的源代码。Cheng et al. 和 Macro Placement Repo 的 UCSD 作者可以访问 CT,并从 Google Team 1 工程师的长期参与中受益,但无法访问 Bae 等人或 Mirhoseini 等人中使用的 SA 代码或 CT 框架中缺少的其他关键代码片段。

然而,Bae et al. 和 Cheng et al. 的结果与 Macro Placement Repo 相互印证,他们的定性结论是一致的。UCSD 的 Ariane-NG45 结果与 Google Team 1 工程师的结果非常吻合,Cheng 等人表明,UCSD 生成的 Ariane-NG45 的 CT 训练曲线与 Google Team 1 工程师生成的曲线相匹配。Google Team 1 工程师仔细审查了这篇论文,以及 2022 年秋冬和 2023 年冬季的研究结果,没有提出异议。

《自然》论文的两位主要作者于 2022 年 8 月离开了谷歌,但在 2023 年 3 月,他们反对 Cheng 等人的结果。原始工作的缺陷没有得到补偿。这些反对意见立即在宏布局代码库的 FAQ 部分得到解决。问题之一是 Cheng 等人的实验中缺乏预训练。

训练前

Cheng 等人使用 Google Circuit CT 库中的代码和指令进行训练,并表示(2023 年 6 月):“以下结果是从头开始训练的结果,因为目前无法共享预训练模型。

根据 Macro Placement Repo 中的 MacroPlacement 常见问题解答,Cheng 等人没有使用预训练,因为根据 Google 的 CT 常见问题解答,不需要预训练来重现 Mirhoseini 等人的结果。此外,Google 没有公布预训练数据。

Google Team 2 使用 Google 的内部代码来评估预训练,发现对与 SA 或 RePlAce 的比较没有影响。

Google Team 1 表明,对 “不同 TPU 块 ”的预训练并没有改善结果,只是改善了运行时间。之前 netlist 版本的预训练略有改进。CT 文件或论文本身未讨论、披露或发布此类先前版本的先前版本。

换句话说,Nature 论文的主要作者希望其他人使用预训练,但他们没有足够详细地描述它来重现它,没有发布它的代码或数据,并且已经表明它不会改善预训练的结果。

2024 年 9 月(发布几年后),作者宣布发布预训练模型,但没有发布预训练数据。因此,我们无法确保用于测试的特定示例未在预训练中使用。

基准测试是旧的

另一个反对意见是,Bae 等人和 Cheng 等人使用的公共电路基准测试据称使用了过时的基础设施。

事实上,这些基准已经使用 HPWL 目标进行了评估,这些目标可以在芯片设计的几何 2D 缩放下精确缩放,并且仍然适用于所有技术节点(第 2 节)。ICCAD 基准测试是由该论文的同行评审员 #3 要求的。当 Bae 等人和 Cheng 等人实施这一要求时,Google RL 在路由变得相关之前就遇到了麻烦:在 HPWL 优化中,RL 差了大约 20%(HPWL 是 CT/RL 优化代理成本中最简单但最重要的项目)。

Cheng 等人没有进行收敛训练

Macro Placement Repo 中的 FAQ #15 立即解决了这个问题:“CT GitHub 存储库提供的任何指南中都没有描述'Train to Convergence'。

后来,他们的其他实验表明,“训练直到收敛会使一些关键芯片指标恶化,同时改善其他指标,突出了代理成本和芯片指标之间的相关性差。总体而言,与 ISPD 2023 论文中报告的模拟退火和人体宏观放置的结果相比,在收敛之前训练没有质的变化。Bae 等人的 RL-vs-SA 实验早于 CT 框架,也早于 Mirhoseini 等人声称的在不到 6 小时的训练后收敛的方法。

Nature 论文中使用的计算资源非常昂贵且难以复制。由于 RL 和 SA 算法都在早期产生可行的解决方案,然后逐渐改进代理函数,因此 Cheng 等人的最大努力比较使用的计算资源比 Mirhoseini 等人使用更少的计算资源,并且 RL 和 SA 之间存在等效性。结果:SA 击败 RL。

Bae 等人使用与 Mirhoseini 相同的计算资源比较了 RL 和 SA。Cheng 等人的结果与 Bae 等人的结果一致。如果提供更多资源,SA 和 RL 不太可能进一步提高芯片指标,因为它们与 Mirhoseini 的代理函数相关性差。

这

论文的主要作者 Goldie 和 Mirhoseini 在他们的声明“关于芯片设计的强化学习的声明”中提到,该论文被大量引用,但他们没有引用任何在 Google 之外的积极可重复结果来清除所有已知的障碍。Bae 等人和 Cheng 等人没有讨论在 IC 设计中使用 RL 的其他方法,因此这里不作一般性结论。

Google 论文的结果可用吗?

发表在《自然》杂志上的谷歌论文声称,这些方法可以应用于最近的谷歌 TPU 芯片,这似乎支持了他们的说法:这些方法改进了技术水平。但除了模糊的一般性陈述之外,没有报告明确说明生产级芯片的芯片指标改进。

已经表明,本文和框架中的方法落后于 SOTA,例如 1980 年代的模拟退火 (SA)。此外,Google 的 Bae 等人在内部实施了 SA,作为 Nature 论文中提出的强化学习方法的适当替代方案。为什么当 Google 声称在其 TPU 设计中使用这种 RL 方法,但实际上它落后于 SOTA 时,会发生这种情况?本文试图给出一些解释。

对 Google Team 1 的后续研究(如图 7 所示)表明,只有在基本相同的设计上进行预训练时,预训练才能改善结果。也许,谷歌在对 IC 设计进行多次修改时利用了强化学习——这是一个有效的背景,但这在《自然》论文中没有描述。此外,从零开始运行时,商业 EDA 工具比强化学习快几个数量级,因此预训练 RL 并不能缩小差距。

Google CT/RL 代码可以改进吗?

RL 和 SA 比 SOTA 慢几个数量级(表 3),但预训练(不是 CT)只会将 RL 速度提高几倍。CT 代码库现在包含已尝试的改进,但我们尚未看到芯片指标的显著改进。改进 CT 库和论文仍然存在四个主要障碍:

总结

本荟萃分析讨论了 Mirhoseini 等人对 Nature 论文结果的复制和评估,以及其中包含的方法、结果和权利要求的有效性。他们发现,该论文包含机器学习中的几种可疑做法,包括不可重复的研究实践、择优挑选结果、误报和可能的数据污染。

根据交叉询问的新数据,本文得出足够的冗余结论,即由于研究中实施、分析和报告的错误,该论文的可信度严重不足。遗漏、不一致、错误和虚假陈述影响了他们的方法、数据、结果和解释。

关于那篇 Nature 论文的结论

Google Team 2 可以访问 Google 的内部代码,而 Cheng 等人则对缺失的组件进行了逆向工程和/或重新实现。Google Team 2 和 UCSD 团队从类似的实验中得出了一致的结论,并且每个团队都进行了额外的观察。

这里交叉研究了 Google Team 2 和 UCSD 团队报告的结果,并考虑了 CT 框架、Nature 同行评审和 Yue 等人,然后总结了这些努力得出的结论。这证实了对这些陈述的许多最初怀疑,以及发现的其他缺陷。

因此,很明显,Mirhoseini 等人的 Nature 论文在几个方面具有误导性,以至于读者无法相信其中最重要的主张和结论。Mirhoseini 等人没有改进 SOTA,原始论文的方法和结果无法从提供的描述中复制出来,这违反了 Nature 既定的编辑政策。依赖专有的 TPU 设计进行评估,以及实验报告不充分,继续阻碍方法和结果的可重复性。

《自然》论文的作者试图反驳这些批评,但没有成功。

令人惊讶的是,Mirhoseini 等人的作者自 Cheng 等人的论文发表以来的一年半时间里没有提供新的令人信服的实证结果。

对芯片设计的影响

这里只强调了 Nature 论文方法论的缺点。但 2024 年来自中国的一项研究“基于 AI 的芯片放置算法的端到端性能基准测试”将 7 种混合尺寸布局技术与 20 个电路(其中 7 个具有宏)使用其新的独立评估框架进行了比较。

他们对芯片指标的端到端发现表明,基于 ML 的技术落后于 RePlAce(嵌入在 OpenROAD 中)和其他基于优化的技术:DREAMPlace(基于 GPU 的 RePlAce 算法变体)和 AutoDMP(围绕 DREAMPlace 的贝叶斯优化包装器)。尽管显然需要重现 Mirhoseini 等人的方法,但 Wang 等人的作者无法提供这样的结果。

政策影响

理论论证和实证证据表明,在各个领域发表的大量论文无法复制,也可能不正确。例如,《自然》杂志的论文加剧了复发危机,破坏了对已发表研究的信任。

Retraction Watch 每年跟踪 5,000 起撤稿事件,包括突出的研究不端行为案例。“研究不当行为是一个严重的问题,而且 [可能] 会变得更糟,”它说,这使得区分诚实的错误与故意夸大和不当行为变得更加必要。各机构必须做出回应,包括在《自然》撤稿通知中明确说明。

应该广泛而严格地遵守 Nature 的编辑政策。引自 Nature Portfolio:

“出版业的一个固有原则是,其他人应该能够复制和借鉴作者发表的主张。在 Nature Portfolio 期刊上发表文章的条件是作者及时向读者提供材料、数据、代码和相关协议,而无需资格......如果读者在出版后遇到作者拒绝遵守这些政策,他们应该联系期刊的主编。

在 Mirhoseini 等人的案例中,该杂志的社论坚持认为“技术专长必须广泛分享”。然而,当手稿作者无视开放基准的要求并阻碍复制时,他们的技术主张应该受到怀疑(特别是如果他们后来不同意将它们与他们的作品进行比较)。

根据同行评审文件,这篇论文的接受取决于代码和数据的发布,但这在 Mirhoseini 等人发表时或之后并没有发生。

作者还对 Nature 论文进行了修改,声称代码已经可用。但发布的代码中仍然存在严重的遗漏。这尤其令人担忧,因为该论文遗漏了关键的比较和细节,而且负责评估该项目的 Google 举报人已在加州法院宣誓欺诈罪名成立。这使得繁殖变得更加重要。

对已发表的科学主张得出明确的结论符合每个人的利益。Nature 期刊的作者、编辑和审稿人以及研究界都有责任。寻求真理是所有人的共同义务。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/270779.html