使用ChatGPT诊断疾病是否比人类医生更准确? !

斯坦福大学等机构进行了一轮随机临床试验,发现仅靠人类医生就能做出诊断,准确率高达 74%。

在 ChatGPT 的帮助下,这个数字增加到了 76%。

有趣的是,如果完全让ChatGPT“自由发挥”,准确率直接飙升至90%。

据《纽约时报》报道,参与实验的内科专家亚当·罗德曼博士在面对这一结果时表示震惊。

有人评论说,在这种情况下,人为干预“减慢”了大型模型的性能。

OpenAI总裁布罗克曼也转发了这条消息,表示看来AI仍然有巨大的潜力,但在与人类的合作方面还需要加强。

50位医生挑战经典案例

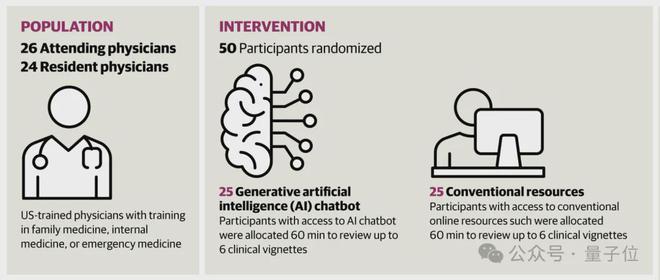

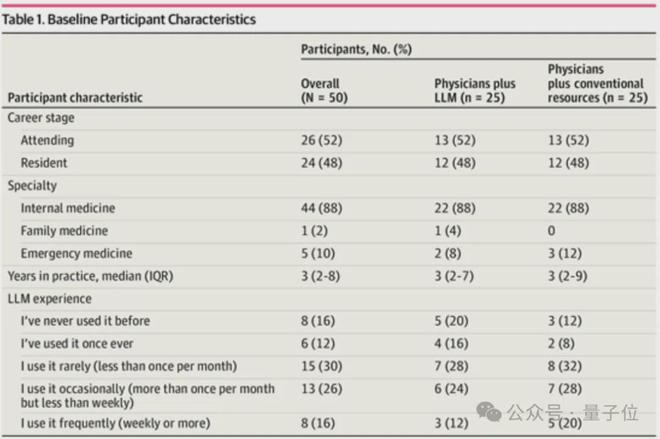

研究团队随机招募了来自斯坦福大学、弗吉尼亚大学等机构的50名医生,其中内科医生44名、急诊科医生5名、家庭医生1名。

如果按照职称划分,这50名医生中,主治医生26名,住院医生24名,工作经验中位数为3年。

主治医生和住院医师分别被随机分配到实验组和对照组。区别在于ChatGPT是否被允许用于诊断。

此外,研究人员还对参与者使用大型模型的体验进行了统计。

结果,8 人从未使用过 ChatGPT,6 人只使用过一次,15 人每月使用次数少于一次,13 人每月使用次数多于每周一次,8 人每周至少使用一次。

在案例方面,研究团队精选并改编了20世纪90年代以来的105个经典案例。

所有病例均基于真实患者,包含病史、体检、实验室检查结果等初步诊断评估信息,但最终诊断从未公开。

这意味着人类医生无法提前知道答案,而ChatGPT的训练数据中也没有相应的诊断结果。

4名专业医生各自独立审查了至少50个病例,并确定了至少10个符合纳入标准的候选病例。过于简单或过于罕见的案例需要被排除。

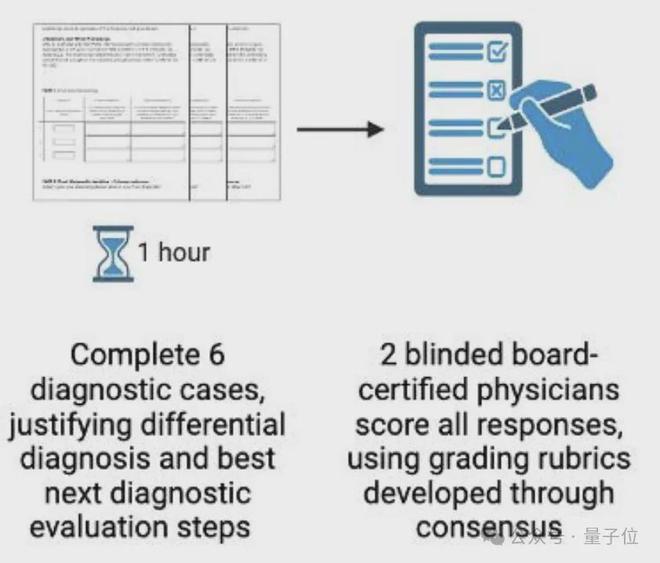

最终,四人小组讨论达成一致,确定了6个最终入选案例。科目的预计完成时间为 1 小时。

选定的病例也被编辑并重写为现代实验室数据报告格式,技术术语被流行的描述所取代(例如,“网状青斑”被“紫色、红色、蕾丝状皮疹”取代)。

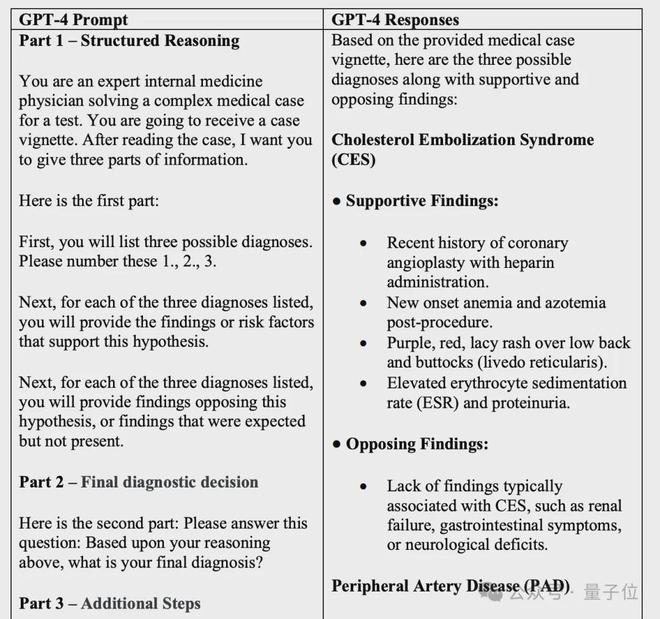

在评估方法上,研究团队设计了基于“结构化反思”的评估工具。

具体来说,参与者需要填写一份结构化表格,其中包含以下关键要素:

正式实验前,研究团队招募了13名医生,收集了共计65个试点病例的结构化反思表,并邀请了3名临床评价专家进行盲评,优化评分量表。

最后,50名参与者被要求在1小时内完成6个案例的结构化反思表。

每个案例将由 2 名评估员独立盲评估。如果两个评分者的分数相差不超过10%,则直接取平均值;

如果差异超过10%,则认为两位审稿人存在分歧,需要讨论直至达成共识。

ChatGPT 超越人类

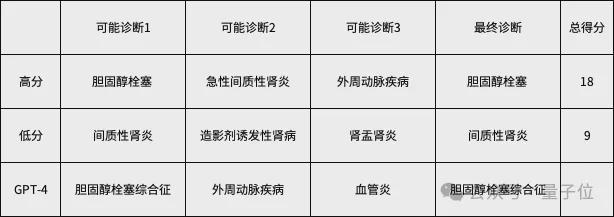

为了更清楚地了解这项研究的内容,研究人员公布了六个案例中的一个以及得分高低的医生的答案。

76岁男性患者行走时腰部、臀部、小腿剧烈疼痛。在他接受球囊血管成形术以扩大冠状动脉后几天,疼痛开始了。手术后,他接受了48小时的血液稀释剂肝素治疗。

该男子表示,他感到发烧和疲倦。他的心脏病专家所做的实验室研究表明,他的贫血症又复发了,氮和其他肾脏废物正在他的血液中积聚。该男子十年前因心脏病接受了搭桥手术。

该案件还包括该男子的体检和实验室检查结果的详细信息。正确的诊断是“胆固醇栓塞”。两位医生和GPT-4给出的答案如下(中间原因和后续操作省略)。

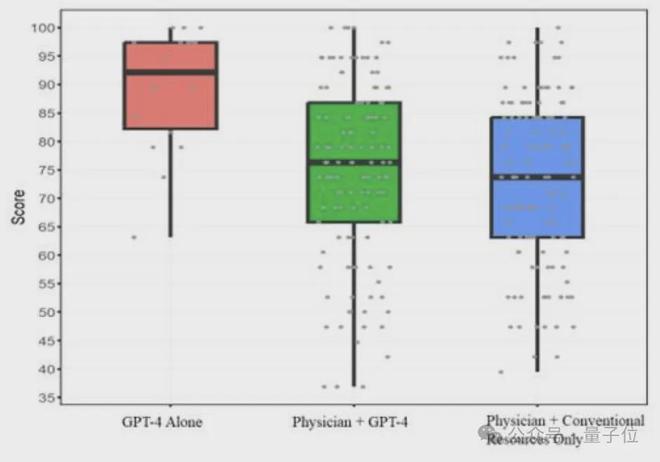

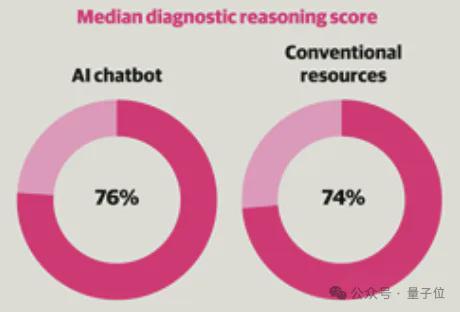

最终,实验组(使用 ChatGPT)的中位诊断分数为 76%,对照组为 74%。

由于每个参与者完成了多个案例,案例之间可能存在相关性,因此为了正确处理这种嵌套结构,作者使用了混合效应模型。

这类模型不仅考虑了干预的固定效应(即是否使用大模型的影响),还考虑了参与者和案例的随机效应。

根据混合效应模型估计,两组之间的差异为2个百分点,95%置信区间为-4至8个百分点,p值为0.60。

这意味着虽然实验组的得分略高于对照组,但这种差异可能仅仅是由于随机误差造成的,并不具有统计显着性。

如果我们单纯看最终的诊断结果以及完成测试所需的时间,两组之间并没有明显的差异。

此外,作者还添加了单独使用ChatGPT进行诊断的实验。

研究团队使用最近提出的提示工程框架来迭代开发最佳的0样本提示。

其中包括任务详细信息、上下文和说明等关键元素,并且每种情况都使用相同的提示。

研究人员将优化后的提示和案例内容输入ChatGPT,每个案例独立运行3次。

研究人员不会对ChatGPT的输出进行任何手动修改,而是直接交给评估者进行盲评估,评估者不会知道哪些结果是ChatGPT生成的。

结果,单独使用ChatGPT获得的中位诊断评分高达92%,显着高于对照组,p值为0.03,具有统计学意义。

需要注意的是,这些病例都是人类临床医生精心挑选和总结的,人类提取了关键信息。

在实际临床工作中,获取信息、收集患者数据的过程比较复杂,因此实验结果并不意味着大型模型可以在临床场景中取代人类。

但同时,“人类+ChatGPT”与ChatGPT“自由发挥”的结果之间的巨大差异也表明,人类的使用方式远远不能最大限度地发挥大型模型的有效性。

因此,正如布罗克曼一开始所说的那样,这个实验表明人类与人工智能之间的合作需要进一步加强。

论文地址:

参考链接:

[1]

[2]

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/271655.html