随着AGI/ASI的持续接近,比人类更聪明的系统完全颠覆了人类社会的外观。像欣顿这样的专家预测,一旦AGI可以取代人类的劳动,人类将“越富裕,贫穷越贫穷”,社会结构将经历震惊的变化。

在“经济蓝图”中,Openai描绘了AI给人类带来的未来:在不久的将来,普通百姓的生活将比当今最“富有”的富人更好。

但这真的是这样吗?

毕竟,由于AI的进步,硅谷主要制造商Salefor冻结了相关职位的招聘,而诸如Meta之类的主要制造商也正在开发中介程序员。

这样,CS毕业生将来很难找到就业机会。他们的生活会比现在更好吗?

关于通用人工智能(AGI)和超级智能(ASI)的预测是压倒性的。

这对其他专业意味着什么?

尽管此主题不是新的,但也不简单。

围绕AI及其对生活的影响的讨论可以分为三个部分:

是否会产生超级智能或通用人工智能(AGI),这是一个超越人类智能的实体,

它如何改善/破坏我们的生活,

我们现在可以做的事情来控制结果。

AGI/ASI近似

Google Docs的父亲史蒂夫·纽曼(Steve Newman)详细解释了AGI的含义:“在超过95%的经济活动中,AGI可以以具有成本效益的方式取代人类,包括未来的新作品。”

此外,这种能力水平还可以帮助人类完成梦想,例如太空移民和星际旅行,并将加速科学发现,等等。

尽管这只是一个可能的预测,但纽曼对AGI的解释代表了大多数领域的专家对下一代AI的看法。

与AGI相似,超级智能(ASI)更多地关注AI在促进科学发现中的作用。

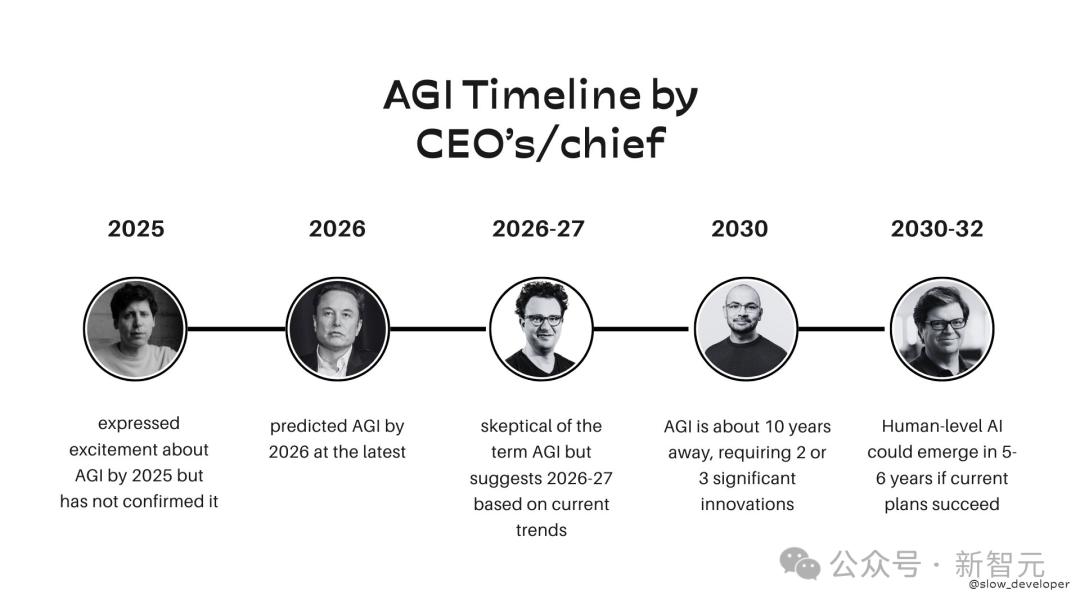

实施AGI只剩下几年,许多AI巨头的专家或首席执行官也给出了更具体的时间节点。

去年,欣顿表示,我们最终将迎来超级聪明,它的到来将比预期的快。

加拿大不列颠哥伦比亚大学计算机科学教授杰夫·克莱恩(Jeff Clune)也同意欣顿。

他说:“我认为超级智能有一个完整的机会,这个机会并不苗条,它可能会出现在今年。我们进入了一个月越来越接近超级智能的时代。而且,过去一个月的每个可能性都会增长。

但是,专家警告不要低估AI的力量,无论其后果如何。

超智能风险

如果您失去了对AI的控制,那么人类的未来可能不会太光明。

AI扩大了富人与穷人之间的差距

在最近的公开讨论中,杰弗里·辛顿(Geoffrey Hinton)预测,AI会加剧富人与穷人之间的差距,并使社会“更糟”。

在历史悠久的河流中,技术进步引起的“裁员”并不是什么新鲜事物。

随着全球工业化和现代化,一些传统的职业正在消失,一些行业甚至被彻底摧毁。

但是人工智能越来越强大,越来越多的工作有被淘汰的风险。

2025年,主要公司表示打算启动“虚拟员工”,而AI进入劳动力市场。 AI可能会成为许多人失业的“最后一根稻草”。

在最近的圆桌会议上,欣顿预测,随着人工智能的发展,财富差距将迅速扩大:

我们谈论的是生产力大大提高。因此,每个人都应该获得更多的商品和服务,每个人都应该变得更好,但实际上情况并非如此。

如果无法正确处理,他说接下来发生的事情将是:

大公司和富人的生产率大幅提高将赚取更多的钱,从而扩大富人与失业者之间的差距。

这主要是因为失业者将失去收入,而控制AI的人(即生产商品和服务的人)将享有而无需劳动成本的财务特权。

研究已经证实,一些自由职业工作受到CHATGPT的影响,工作机会和收入正在继续下降。研究人员甚至推测,一旦AI有能力取代人类的立场,人类将无法恢复其原始位置。

许多富人和大公司都将精力集中在AI上。

很难相信他们是免费的,不是为了未来的利润,而是为了全人类的光明未来。

毕竟,即使Openai几乎都变成了“ Closeai”:Ultraman正在将Openai从非营利组织转变为更商业的营利性组织。

网民还推测,公众失去财富的损失将导致社会失衡。

普通百姓变得微不足道

去年12月28日,L Rudolf L发布了“资本,AGI和人类野心”,强调了人工智能对社会价值观的影响。

他的核心观点如下:

可以取代劳动力的人工智能将迅速改变人类和非人类生产因素的相对重要性,这将减少社会照顾人民的动机,同时增强现有的权力。

现在,如果您想用金钱来实现自己的野心,那么您面临的最深处的问题可能是您无法招募合适的才能,因为招募人才会面临几个问题:

除非您具有相当大的才能,否则通常很难判断一个人的才能。否则,通常会错过真正的才能。

才能很少(最终,脱颖而出并具有伟大才能的才能)。

即使您可以找到顶尖的才能,最高才能通常也不像其他人那样容易被钱购买。

可以取代劳动力的人工智能根本没有这种问题。

首先,尽管AI的“人才”也很难估算,但可以复制AI。

每个人 - 至少有足够的钱在GPU上燃烧 - 都可以带来突破性的AI。

人类与此完全不同。人才不仅难以确认,而且很难复制。

而且,由于人工智能的成本将小于人类劳动力,因此人才的成本将大大下降。

而且,由于可以复制AI的功能,因此竞争将更加激烈。

将资金转化为才华的最大瓶颈是,许多顶尖人才具有复杂的人类偏好,这比AI更难被金钱贿赂。

顶尖的天才通常对自己的学科或职业具有高度的奉献和使命,并将“金钱视为污垢”。

相比之下,AI存在出售(至少在安全范围内)。

显然,AI没有“人性”。无论执行哪种类型的任务,它都会“不后悔”,并且远远超出了人类。

在劳动力被AI取代之后的世界中,将:

在现实世界中,金钱将比以往任何时候都更好。

人们的劳动比以往任何时候都没有影响。

通过劳动致富几乎是不可能的。

在各个国家之间或之间,无法实现基本资本的基本平衡。

这意味着,当可以取代劳动力的AI出现时,拥有大量资本的人将具有永久的优势。

他们将对今天的富人拥有更多的力量:只要自由主义机构保持强大,他们可能不一定超过人民,但至少它们在物质和精神术语上将更加强大。

而且没有新兴的力量可以击败他们,因为现在资本可以轻松地转变为任何领域的“超人”劳动。

此外,世界上权力的机构将不再有动力来照顾人们维持或发展自己的权力,因为所有真正的权力都来自AI。

但是,政治机构可能会坚定捍卫自由人文主义的价值观。

如果每个人都有有意义的无条件基本收入(或类似措施),并且经济保留以人为本的部分,则它也可以维持人们的购买力。

在劣势下,AI亿万富翁拥有几乎无限的权力,并且是永久的贵族。

阶级之间的力量差异可能会使现代人颤抖,就像现代人无法认同封建的等级制度一样。

因为这是权力和金钱激励措施指出的方向。

聪明的诅咒

根据L Rudolf L的理论,AI治理专家Luke Drago进一步解释了AI的隐藏危险,他称之为:“智能诅咒”,也就是说,由于AGI,当权者失去了投资对人民的动机。

他认为,与犁,蒸汽机或计算机之类的工具,AGI更像是煤炭或石油等资源。

就像煤炭和石油等自然资源一样:

发现和利用AGI需要很多钱。

一些玩家将控制AGI,主要是开发AI及其所在国家 /地区的实验室。

从AGI中赚取大部分收入或全部收入的国家和公司不再依靠人们获得收入。

AGI将取代上一代文明资源。对于煤炭,它是木头。对于Agi来说,这是人力资源。

尽管某些国家拥有丰富的自然资源,并且具有自然的收入来源,但其经济发展模式是单身的,普通公民的生活尚未改善。

这称为“资源诅咒”。

有许多因素导致资源诅咒,但核心因素之一是:创造激励措施,而不在乎人们的经济福祉。

那些用AI取代劳动力的人将面临类似的情况,但后果将更加严重。

因为他们的收入将来自“人工智能”,而不是人类。

因此,只要他们继续投资于AI,他们就可以赚取更多的收入。

最终,他们将不再需要为人们提供工资或福利,也不会再提供社会保障,例如教育和医疗服务。

最终结果是普通人无法维持生计。人类无处可利用自己的力量,因此不会得到回报。

这是情报的诅咒 - 一旦执政的人创造并实施了普遍的情报,他们将失去投资人民的动机。

一旦AI系统比人类更好,更便宜,更快,更可靠,智能诅咒开始生效。在接下来的1到5年中,后果将出现。

此外,人类再也无法摆脱这种“诅咒”,但是预计将解决“资源诅咒”。

因为考虑石油的气候影响和可再生能源的兴起,任何国家现在都可以产生能源。生产石油的国家被迫寻求新的收入来源,在此过程中将权力委派给人民,从而摆脱了“资源诅咒”。

AGI不会产生这种影响 - 随后的模型将比上一代更强大,并且一些人将永远处于垄断地位。

AGI不会像油一样“耗尽”。计算能力或现有能量可能会耗尽,但是随着时间的流逝,计算能力变得更便宜,能量变得更加绿色。

如何控制AI

尽管有关技术范围和时间范围的预测可能会有所不同,但研究人员通常认为,超级智能是不可避免的。

仍然开放的问题是,人类是否可以保持对AI的控制。

对于欣顿来说,答案是选举强烈重视AI的政客:“我们应该做的是鼓励政府迫使大公司进行更多的研究以及如何在开发这些技术时保持这些技术的安全。”

但是,Google DeepMind的高级研究顾问Clune表示,许多领先的AI公司拥有正确的价值,并且正在“努力做对”。

“我比开发领先的AI模型的公司更担心其他国家和组织试图赶上的公司,它们的关注远不如AI顶级实验室。”

Clune提出的实用解决方案类似于核时代实践,该实践邀请所有主要的AI参与者进行定期对话。

他认为,AI从业者应该共同努力,以确保它可以安全发展。

克莱恩说:“这是人类历史上最大的赌注,甚至比核武器更大。”并建议世界各地的研究人员了解彼此的进步,并在需要时减慢研发。

“赌注非常高。如果我们做对的话,好处也很大。如果我们做错了,我们可能会讨论人类文明的终结。”

参考:

本文来自作者:Xin Zhiyuan的微信公共帐户“ Xin Zhiyuan”,由36KR发表并授权。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/273980.html