作者| Yoky

发送电子邮件至yokyliu@pingwest.com

DeepSeek,Li Feifei,Limo,全球AI行业最近被这些条款所包围,在所有这些条款之后,我们必须从“隐藏在城市中”的大师开始。

2月3日,Li Feifei和Stanford University和其他团队在Arxiv上发表了一篇名为“ S1:Simple Test Time Scaling”的论文,该论文仅在16 H100时进行了微调26分钟,并接受了小于50美元的培训。新的模型S1-32B具有数学和编程功能,可与OpenAI O1和DeepSeek R1等尖端推理模型相媲美。

几乎同时,来自上海乔孔大学的一名本科生Yixin Ye和他的团队培训了一种具有1%数据量的新豪华轿车模型,以培训具有高达94.8%的数学测试准确性的新模型。

人们普遍认为,在低成本下训练强绩效模型的方法基本上是从启动R1模型时进行的DeepSeek进行的蒸馏演示开始。这一系列作品出现了,海外AI社区惊讶地发现他们使用的码头模型实际上是Qwen,这是幕后的真正大师。

中国人更熟悉的名字是Qwen系列,这是由阿里巴巴云开发和开发的大型模型。

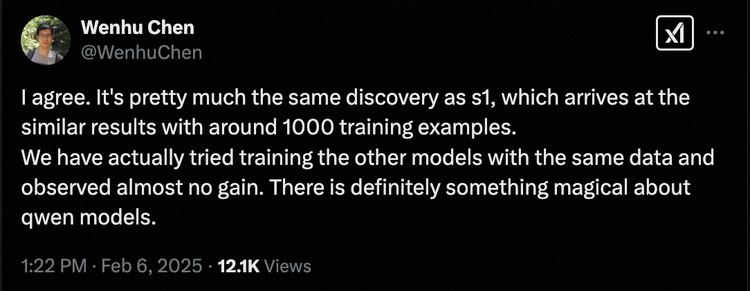

加拿大滑铁卢大学的助理教授陈·温胡(Chen Wenhu)直言不讳地说,他们也尝试过其他模型,但同样的培训数据根本没有起作用。他总结说:“ Qwen模型中一定有一些神奇的东西!”

那么,这些神奇的事情到底是什么?

1他们为什么从研究中选择QWEN?

在本文中,Li Feifei的团队提到,性能优化的核心技术是S1K数据集和预算强迫方法。

S1K数据集包含1,000个精心选择的问题,Li Feifei团队还使用Google的Gemini Flash Thinking模型来为每个问题生成推理痕迹和答案。预算强制性方法的特征是在模型完成思考时添加“等待”,鼓励探索更多答案。

最后,在Li Feifei团队监督并微调开源QWEN2.5-32B实施官员并强制使用预算之后,获得了S1-32B型号。也就是说,在16 H100 GPU上进行26分钟的培训的阶段花在50美元上。

应该打破的第一个神话是,这不是只需50美元即可完成的事情。 Li Feifei的新方法不是从头开始训练模型,而是根据QWEN模型进行微调。公共数据表明,QWEN2.5型系列单独使用18万亿代币进行预培训,您可以想象它是什么样的支出。

陈·温胡(Chen Wenhu)在X上的信息在一个句子中揭示了秘密,并非所有模型在微调后都能产生如此效果。

上海Jiotong大学团队的豪华轿车几乎是对同一技术的探索。它使用的817个选定的培训样本。通过建立更高质量的推理链,结合计算扩展和推理时间进行微调,这是极具挑战性的。 AIME基准测试的准确率从6.5%提高到57.1%,在数学基准中达到的精度为94.8%。

该数据量表仅占经典方法达到模型级别所需的数据的约1%。

关于X的研究科学家奥马尔·卡塔布(Omar Khattab)即将成为麻省理工学院的助理教授,现在是Databricks的研究科学家,他说,这些论文更像是Qwen的研究结果,而不是推理。

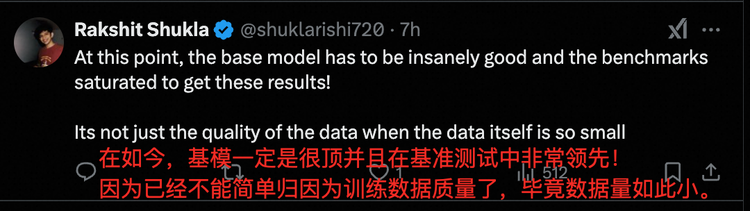

前三星研究所科学家拉克希特·舒克拉(Rakshit Shukla)也表示,这些新成就证实了基本模型的强劲表现(即QWEN)。

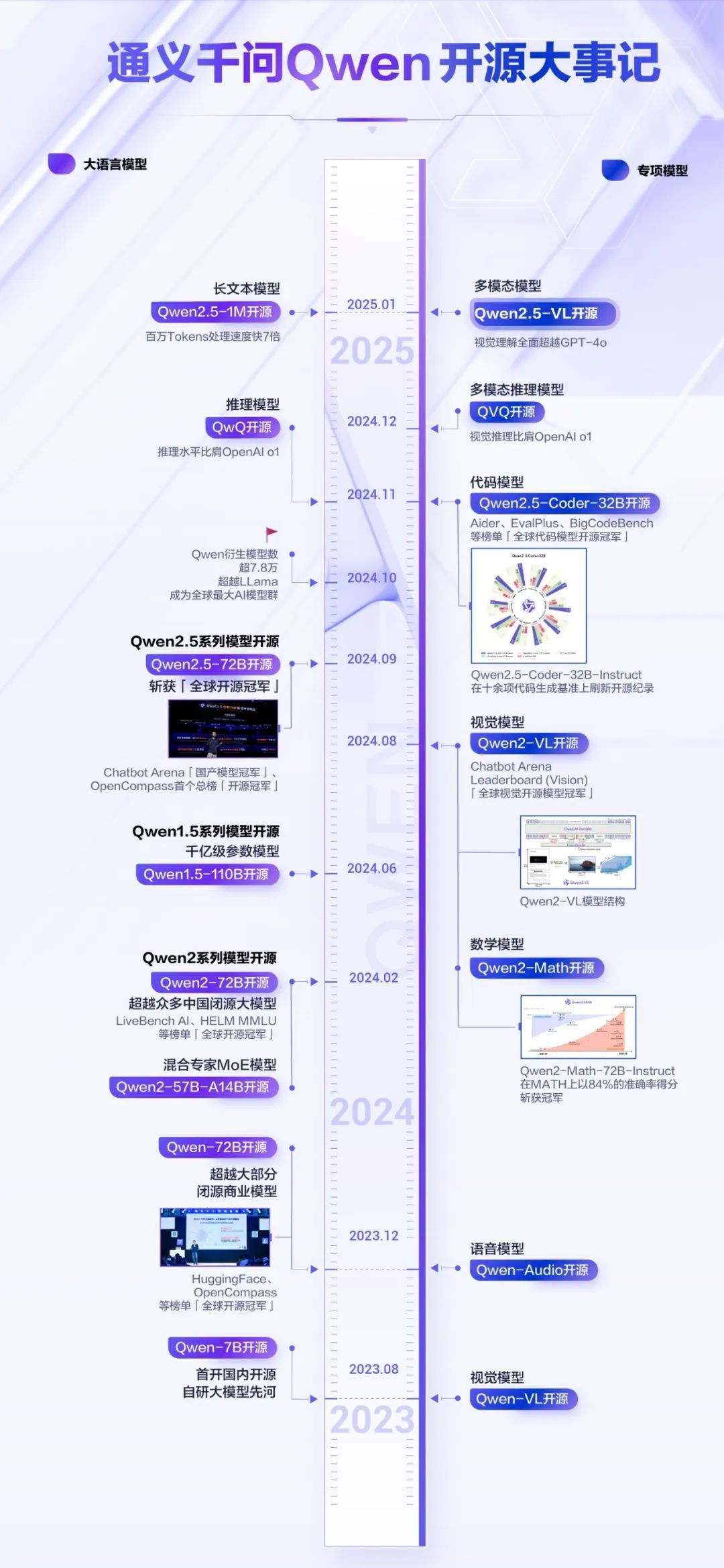

实际上,国际开源社区对Qwen非常熟悉。从QWEN2到QWEN2.5,来自不同一代的开源QWEN模型在Huggingface的Open LLM排行榜和Chatbot Arena大型型号的盲目测试列表中反复列出,并多次赢得了“全球开源”。冠军”,毫无疑问,表现很强。

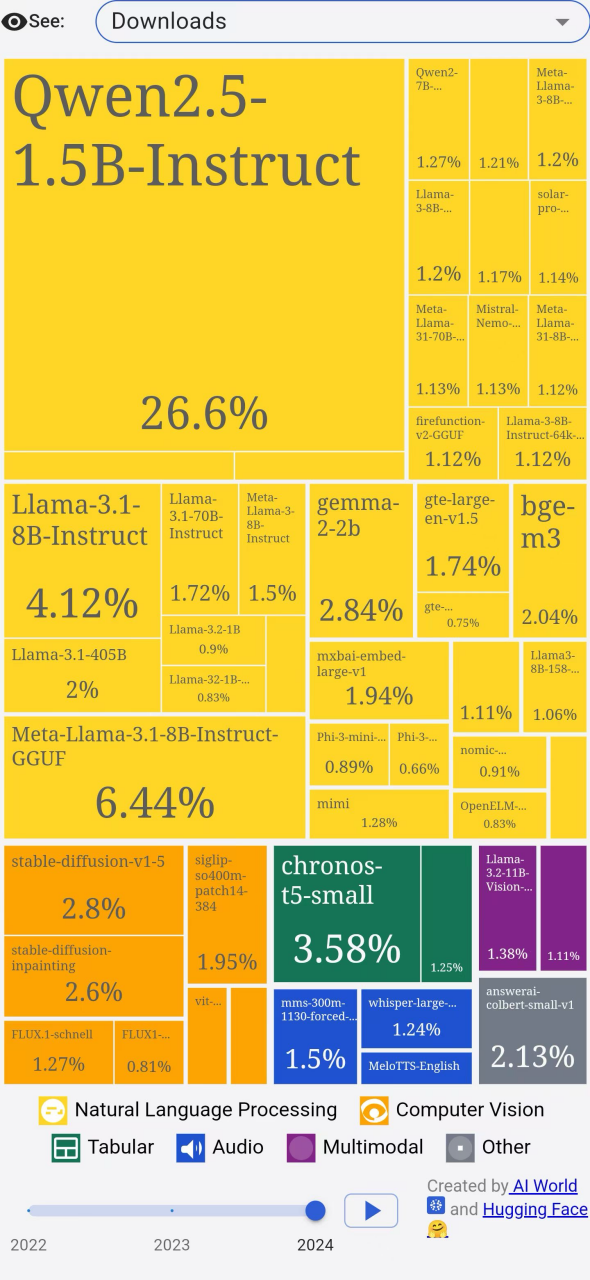

更重要的是,Qwen推出了不同尺寸的开源模型,范围从0.5B到110B,可以更好地满足数千个行业的需求。开发人员用脚投票并下载QWEN模型。在Huggingface平台上,仅Qwen占去年所有模型下载的26.6%。

拥抱面提供的官方照片

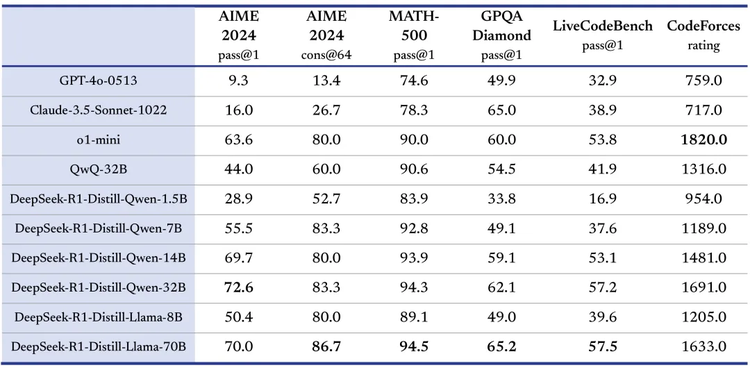

DeepSeek在世界范围内很受欢迎,也选择了Qwen。

当R1释放时,DeepSeek正式透露,校对蒸馏R1的能力是6个型号,其中4个型号为QWEN,选择了4种尺寸,即1.5b,7b,7b,14b和32b。其中,选择了基于QWEN-32B的蒸馏模型。在多个功能中,达到与Openai O1-Mini相同的效果。

世界上越来越多的开发人员和企业选择了QWEN,并为开源社区开发了QWEN衍生模型。目前,开发人员Erchuang的QWEN衍生模型数量已超过90,000,成为世界上最大的AI模型组。

也许这就是李·菲菲(Li Feifei),Yixin Ye甚至DeepSeek选择Qwen的另一个原因。毕竟,从学术界到行业都使用的Qwen是最容易比较性能基准基础模型。

2不仅是最好的开源模型,而且QWEN2.5-MAX在这里较强

就像每个人都为杰出的开源Qwen车型加油时,在农历新年的第一天,阿里巴巴云也发布了新年的第一子弹:Qwen2.5-Max早上1:30。

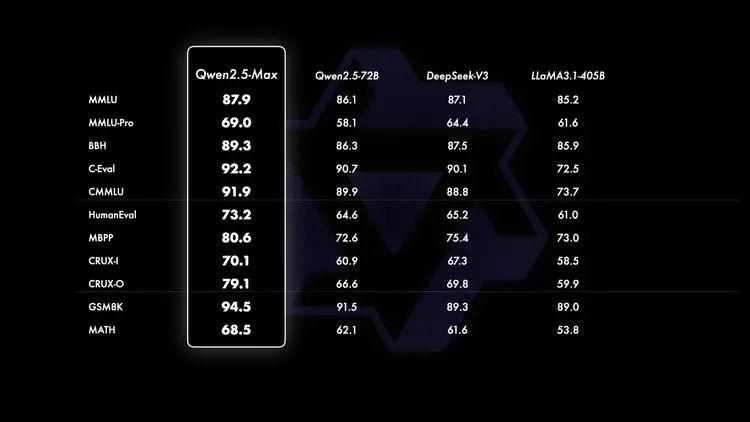

与所有行业领先的模型相比,QWEN2.5-MAX仍然表现出极强的性能。

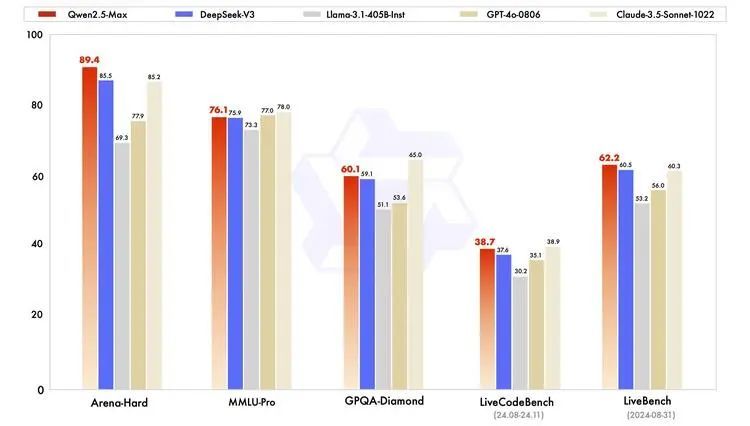

在测试大学级知识的MMLU-PRO等主流评估中,评估编程功能的LiveCodeBench,全面评估全面能力的LiveBench和Arena-Hard,Qwen2.5-Max,几乎总是可与Claude-3.5-Sonnet相当对整体功能有很好的评估。它在各个方面都超过了GPT-4O,DeepSeek-V3和Llama-3.1-405b。

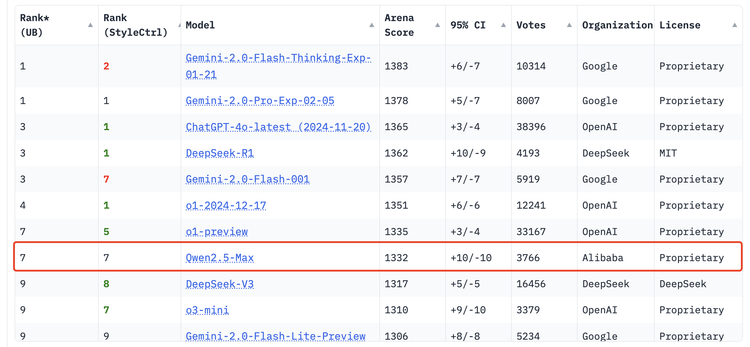

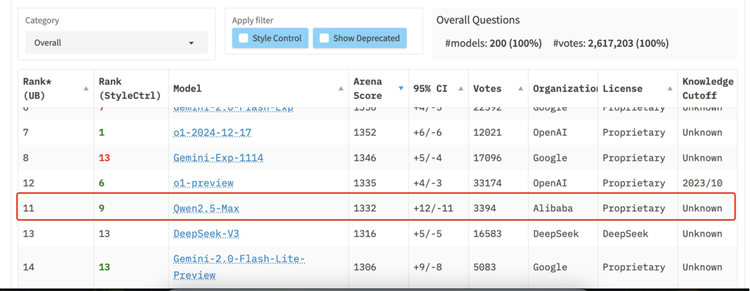

就在过去的两天中,Qwen的新型号再次进入了全球前十名,即主流大型模型审查列表,其超级绩效:

2月4日,该行业最著名的三方评估列表-Chatbot Arena Big Model Flind测试列表发布了。 Qwen2.5-Max得分1332分,超过了国内外球员,例如DeepSeek V3,O1-Mini和Claude-3.5-Sonnet,在世界上赢得了第七名,并赢得了数学和节目的第一名。 。

2月6日,在由Meta Yang Likun领导的最新LiveBench列表中,Qwen2.5-Max也进入了世界前十名,领导了许多优秀的球员,例如DeepSeek-V3,Gemini-2.0-Flash-lite。

QWEN团队技术博客的最后一段关于QWEN2.5-MAX的技术博客提到:“不断改善数据和模型参数的规模可以有效地提高模型的智能水平。”

这相当于根据MOE(Hybrid Expert)体系结构开发的超大级MoE模型中回答秘密:扩展法律,继续扩展参数规模并不断改善培训解决方案。扩展法既是一个想法,又是实践。

就训练前数据量表而言,QWEN2.5-MAX模型是根据多达20万亿代币的数据进行预训练的,该数据超过了由QWEN2.5训练的18万亿代币。 QWEN2.5-MAX的预训练数据涵盖了广泛的领域,并且具有较高的知识密度。同时,通过精心设计的数据过滤和比例,确保数据的数量和质量。此外,完全优化的培训后数据和强化学习方法使QWEN2.5-max产生的内容更符合大多数用户的偏好。

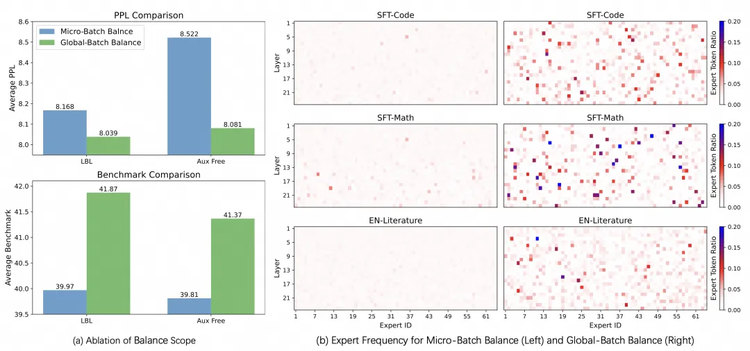

在培训技术层面上,QWEN团队于今年1月在本文中提交,题为“详细的恶魔:实施培训专业混合物模型的负载平衡损失”,重点介绍改进MOE模型培训的解释方法。

在DeepSeek Training V3的技术报告中,讨论了基于全球均衡的专家选择的效果。 Qwen走得更远,通过轻量级的通信成本实现了全球均衡,并在大规模上验证了该方法的有效性,从而大大提高了MOE模型的性能和专家特异性。

由于这些关键改进,在模型裸露性能的11个评估比较中,即基本模型,QWEN2.5-MAX是行业领先的Moe Mode DeepSeek V3,是最大的开源密度密集模型Llama-3.1-405B和同一系列。 QWEN2.5-72B竞赛的总领先优势。

3不是从DeepSeek到Qwen,而是从Qwen到开源世界

当许多人为Qwen2.5-Max的表演加油呼吸时,DeepSeek-V3并再次为中国大型模型而欢呼时,他们实际上忽略了一个重要的事实:在DeepSeek变得流行之前,海外大型模型圈就已经闻名了。姓名。

在我们以前访问硅谷时,每当我们谈论中国大型模型时,许多CEO和开发人员弹出的名字就是阿里巴巴的Qwen。

在过去的两年中,Qwen确实是最开源和最深入的中国大型模型的代表。 QWEN模型具有很强的性能,不同的开源规模,并且拥有世界上最大的衍生品模型组,使其成为学术界和行业中最重要的开源模型系列。

自2023年8月发布第一个开源模型QWEN-7B以来,QWEN已连续打开了涵盖不同参数量表,不同模式和不同应用程序场景的数十个模型。这些模型不仅包括一般的大型语言模型,而且还包括多模式,对话和代码生成等专业领域的专业版本。

在Github社区中,Qwen受到了世界各地开发人员的赞扬。特别是,QWEN2.5系列模型于2024年9月发布,在代码生成和调试任务中表现出色。一些开发人员已在本地成功部署了QWEN2.5-32B模型,并与VS Code扩展工具结合使用,完全替换了Chatgpt和Claude 3.5 SONNET的先前依赖的编程辅助功能。

图像源x屏幕截图

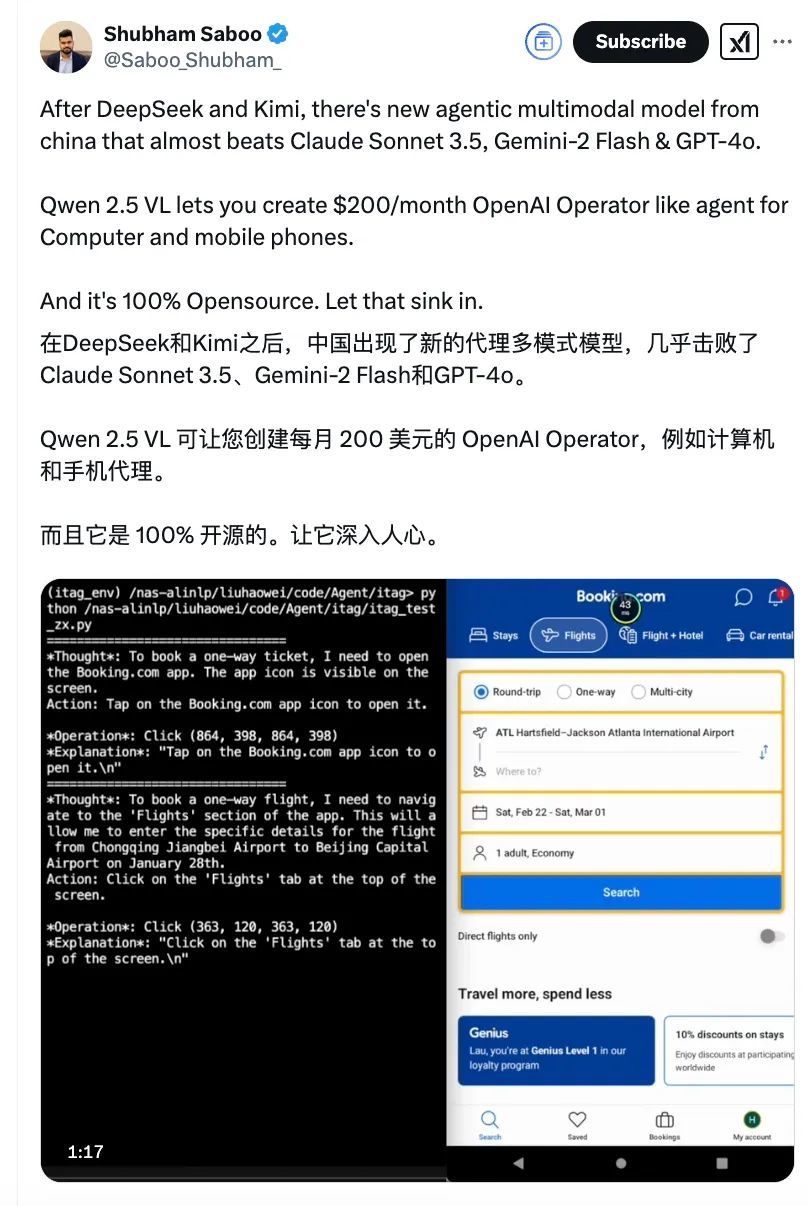

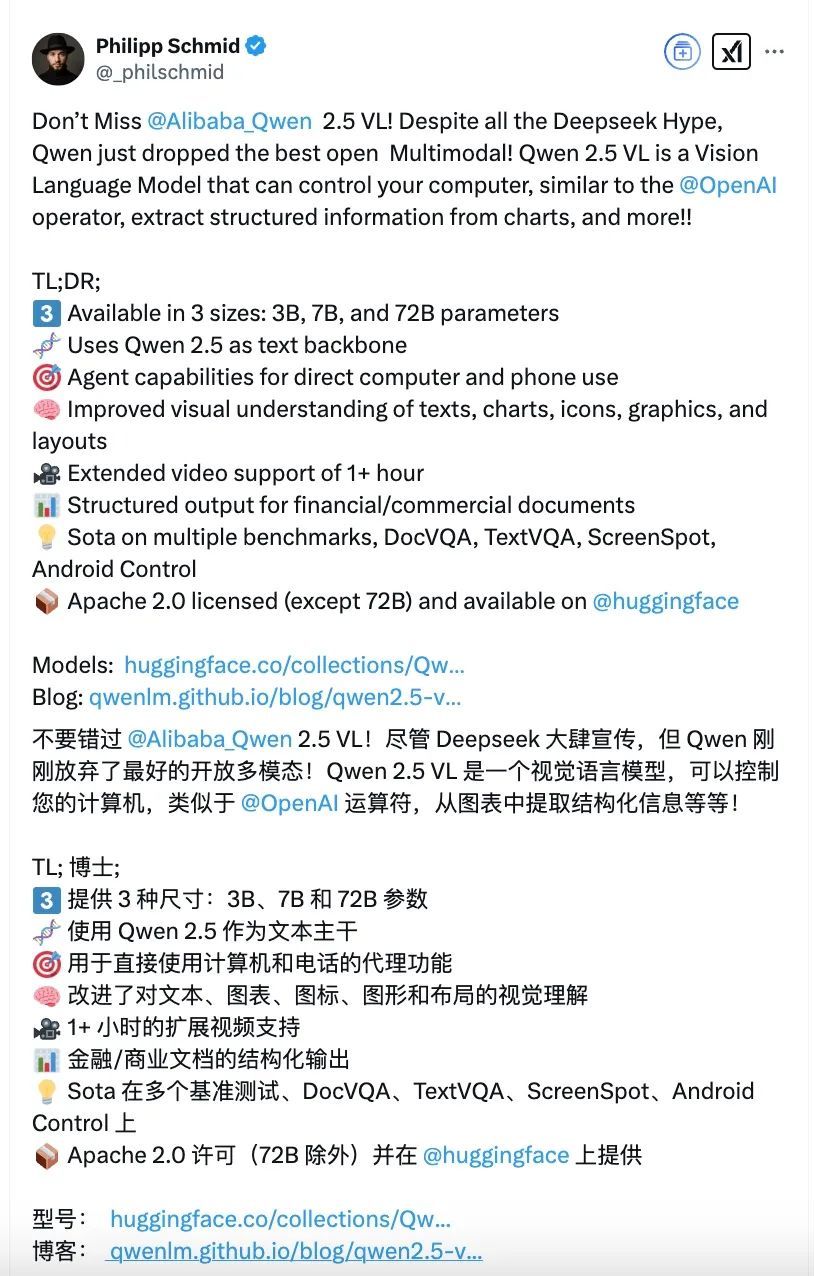

在过去的三个月中,QWEN连续打开了推理模型QWQ的来源QWQ,多模式推理模型QVQ,数学推理过程奖励模型QWEN2.5-MATH 2.5-MATH-PRM和长期文本模型QWEN2.5-1M,支持100万个令牌。以及最新一代的视觉理解模型qwen2.5-vl。

以视觉理解模型为例,阿里巴巴云(Alibaba Cloud)曾经打开了QWEN-VL和QWEN2-VL两代模型的来源,总全球下载量超过3200万次。它是开源社区中最受欢迎,最有力的视觉理解模型。开发人员使用它。它了解无法识别的手写手稿,回答书籍中困难的数学物理问题,甚至试图探索月球和银河系的秘密。

正是由于这个原因,Qwen2.5-VL发行了开源,它引发了海外Qwen粉丝的狂欢。开源社区的最大老板VB总结了一句话:它继续变得越来越好。

一个行业共识是,Qwen首先以中国AI模型的开源旗帜旗帜,也带来了开源浪潮,从而培育了AI生态系统。由阿里巴巴云(Alibaba Cloud)领导的莫达(Modai)社区已推出了40,000多个AI型号,并为超过1000万开发人员提供服务。

像李·菲维(Li Feifei)这样的学术名人选择Qwen,像Yixin Ye这样的年轻大学生探索基于Qwen的新技术,甚至像DeepSeek这样的惊人初创公司都使用Qwen模型进行蒸馏。由于Qwen具有强大的语言能力,更多来自阿拉伯语,法语,日语和讲西班牙语地区的开发人员首次拥有出色的民族语言模型。

Qwen将AI技术从杭州带到了世界。

4“神秘的东方力量”的公开秘密

人们经常在一年内高估变化,但五年来低估了变化。

不到一年前,一些大人物认为封闭的消息来源是AI大型模型开发的主流。现在,世界各地的开发人员正在为中国AI技术挑战传统霸权而欢呼。

今天,当我们谈论中国大型模型的集体崛起时,我们将谈论DeepSeek,这是其背后的足够定量资本及其追求AGI的纯粹原始意图;我们还将谈论汤蒂·Qianwen(Tongyi Qianwen),这是阿里巴巴云,诞生了它,较大的阿里巴巴巴巴生态学。

巧合的是,这两种著名的中国模型来自杭州,所以有人在开源世界中称它们为“内战”,甚至有传言说阿里巴巴将投资于DeepSeek。无可争议的事实是,当DeepSeek所需的计算能力支持最大的功能时,阿里巴巴云正式宣布支持DeepSeek-V3和R1模型的部署。

AI不是零和游戏,最终的胜利将不属于某个公司。在如此激动人心的时代,手头移动可能是最好的解决方案。

当然,时间将测试所有人,一切都刚刚开始。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/274040.html