不仅是OpenAI备受期待的下一代模型Orion,谷歌和OpenAI的竞争对手另一家明星人工智能(AI)初创公司Anthropic也传出高级AI模型的开发遇到了瓶颈。

美国东部时间 11 月 13 日星期三,彭博社援引两位知情人士的话报道称,OpenAI 在今年 9 月完成了 Orion 的第一轮训练,希望能够大幅超越之前的一些版本,离 AI 超越人类的目标更近一些。此事。 ,但 Orion 的表现并没有达到公司的预期。截至夏末,该模型在尝试回答未经训练的编码问题时表现不佳。

知情人士评价,总体而言,到目前为止,相比 GPT-4 超越 GPT-3.5 的性能,Orion 和 OpenAI 现有模型并没有取得那么大的进步。

报道还援引另外三名知情人士的话称,谷歌即将推出的新版本 Gemini 没有达到内部预期,Anthropic 也推迟了计划发布名为 3.5 Opus 的 Claude 模型。

报告认为,上述三家公司在开发AI模型方面面临多重挑战。他们越来越难以找到未开发的高质量人工训练数据。例如,Orion 的编码性能不理想部分源于缺乏足够的编码数据进行训练。即使模型性能的适度改进也可能不足以证明构建和运行新模型的巨额成本是合理的,也不足以满足重大升级的期望。

AI模型开发的瓶颈问题挑战了被许多初创企业甚至科技巨头视为指导方针的Scaling法则。它还对大规模投资人工智能以实现通用人工智能(AGI)的可行性提出了质疑。

华尔街新闻曾提到,OpenAI早在2020年就提出的定律意味着,大模型的最终性能主要与计算量、模型参数量和训练数据量有关,并与模型的具体结构(层)。数量/深度/宽度)基本上不相关。今年7月,微软首席技术官(CTO)Kevin Scott也为这一定律进行了辩护,称Scaling law仍然适用于当前的行业——在扩展大型模型的同时,边际效益并没有减少。

无独有偶,上周有媒体爆料,OpenAI 发现 Orion“没有实现那么大的飞跃”,进度远不及前两代旗舰机型。这一发现直接挑战了AI领域一直奉行的Scaling法则。由于高质量训练数据的减少和计算成本的增加,OpenAI 的研究人员不得不开始探索是否有其他方法来提高模型的性能。

例如,OpenAI 正在将更多代码编写功能嵌入到其模型中,并尝试开发可以接管 PC 通过执行点击、光标移动和其他操作来完成网络浏览器活动或应用程序任务的软件。

OpenAI还成立了专门的团队,由此前负责预训练的Nick Ryder领导,探索如何优化有限的训练数据并调整扩展方法的应用,以保持模型改进的稳定性。

对于彭博社周三的报道,谷歌 DeepMind 发言人表示,该公司“对 Gemini 的进展感到满意,我们将在准备就绪时分享更多信息”。 OpenAI 拒绝置评。 Anthropic 也拒绝置评,但提到了周一发表的一篇博文,其中 Anthropic 首席执行官达里奥·阿莫迪 (Dario Amodei) 在一个长达 5 小时的播客中发表了讲话。

阿莫德尔说,人们所说的缩放定律并不是定律。这是用词不当。它不是普遍规律,而是经验规律。 Amodel 预计比例定律将继续存在,但并不确定。他表示,“很多事情”可能会“破坏”未来几年更强大人工智能的进展,包括“我们可能会耗尽数据”。但他乐观地认为人工智能公司将找到克服任何障碍的方法。

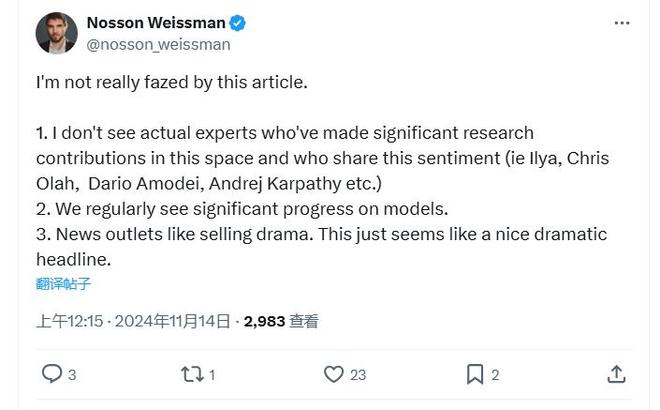

对于彭博社的报道,提供企业定制人工智能解决方案的公司NossonAI的创始人Nosson Weissman评论道,该报道并没有让他感到困惑,因为首先,他没有看到在人工智能领域做出过重大贡献的真正专家的表情。人工智能领域。其次,我们经常看到建模方面的重大进步,最后,他认为新闻媒体喜欢制造戏剧性,而这篇报道似乎有一个很好的戏剧性标题。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/271467.html