爆炸性新闻——

ViT 的三位核心作者集体从 Google DeepMind 辞职。下一站:OpenAI!

他们是翟晓华、卢卡斯·拜尔和亚历山大·科列斯尼科夫。

相关消息已得到本人证实,三人均已正式公布新动向。

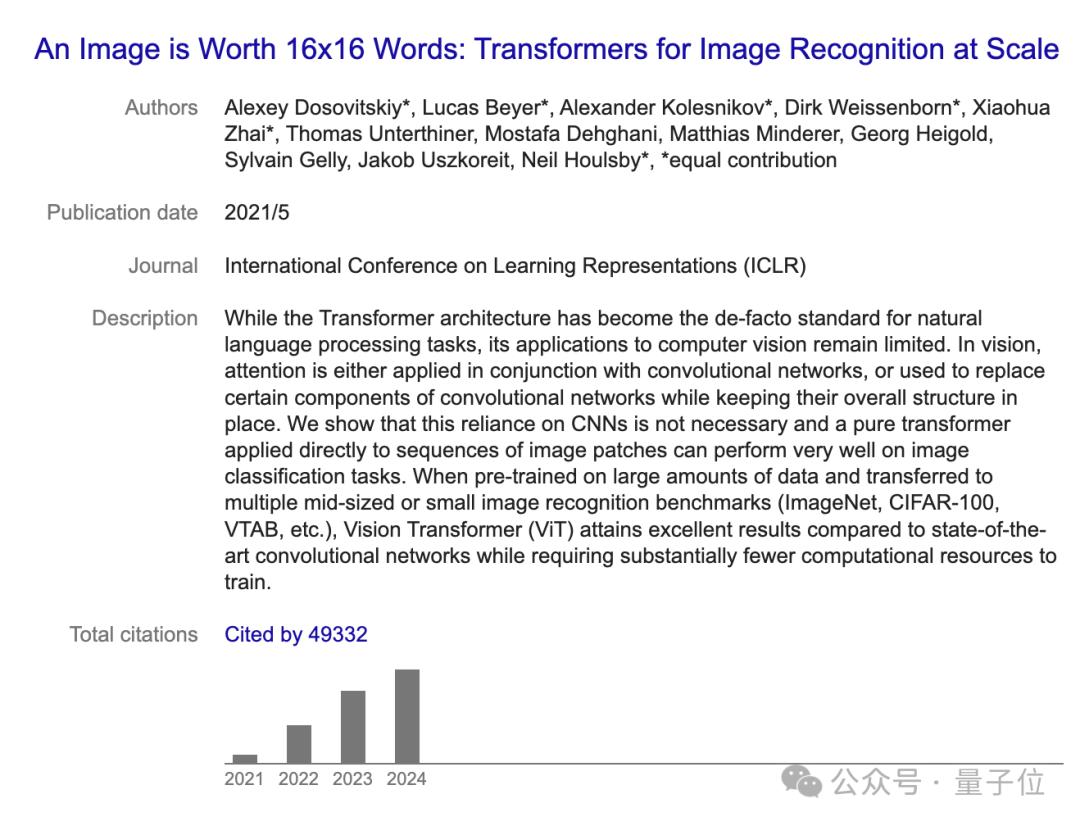

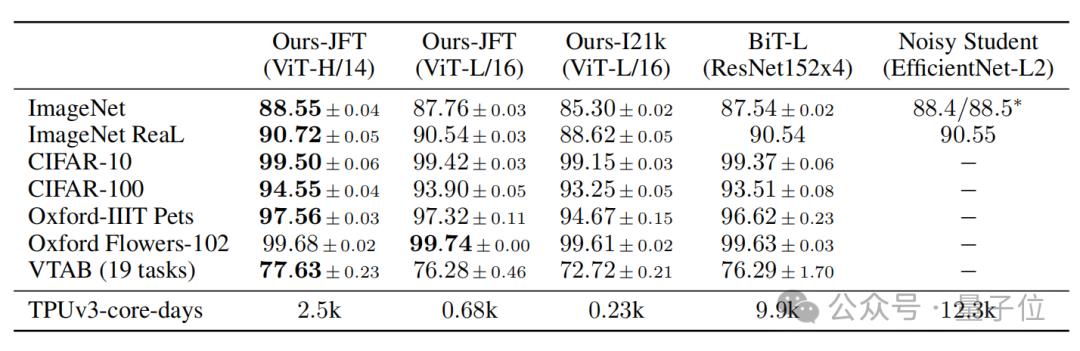

2021年,他们三人共同打造了计算机视觉领域的杰作ViT,一发布就刷新了ImageNet的记录。

这项研究证实了 CNN 在 CV 领域并不是必需的。 Transformer 是从 NLP 跨过来的,仍然可以取得先进的结果。开创了Transformer在CV领域的应用。

迄今为止,该论文已被引用超过 49,000 次。

此外,他们还联合提出了SigLIP、PaliGamma等SOTA级别的工作。

几周后,他们将正式加入 OpenAI 苏黎世实验室。

值得一提的是,《连线》报道称,这三人是被OpenAI挖走的。

网友评论:能够撬动这个“铁三角”黄金组合,OpenAI真的很幸运。

ViT 三位核心作者叛逃 OpenAI

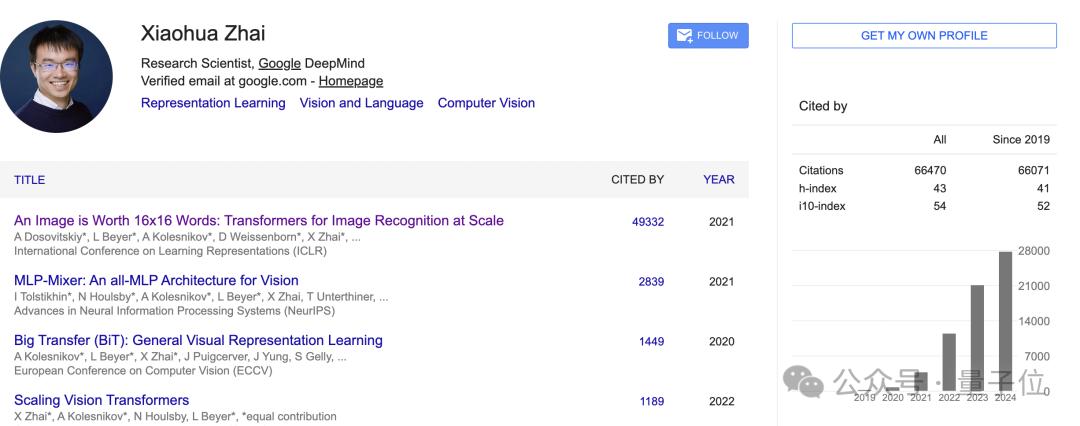

翟晓华

此前,他是 Google DeepMind 的高级研究员,领导苏黎世的一个多模式研究小组。重点关注多模态数据 (WebLI)、开放权重模型(SigLIP、PaliGemma)和文化包容性。

目前,谷歌学术引用次数超过6万次。

2014年毕业于北京大学计算机专业,获博士学位;毕业于南京大学,获学士学位。毕业后,我就去苏黎世谷歌工作。

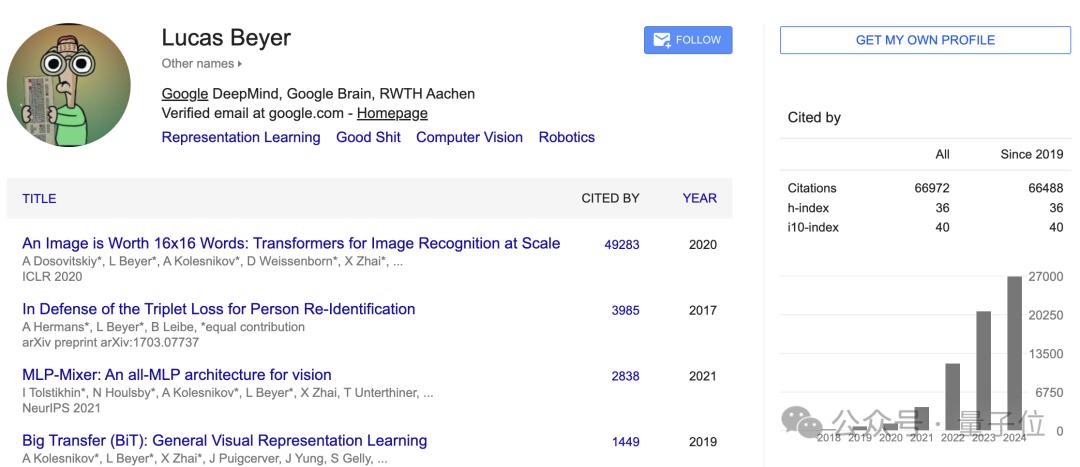

卢卡斯拜尔

他还是 Google DeepMind 苏黎世团队的成员,并共同领导 DeepMind 的多模式研究团队和基础设施。

目前已撰写论文50余篇,已被CVPR、NeurIPS、ICCV等顶级会议接收。

据他的官网介绍,他在比利时长大,梦想制作视频游戏并从事人工智能研究。自称为“自学成才的黑客和致力于创造非凡事物的研究科学家”。

他在德国亚琛工业大学学习机械工程,并获得机器人感知和计算机视觉博士学位。 2018 年加入谷歌。

亚历山大·科列斯尼科夫

他自 2018 年以来一直在 Google Brain 工作,目前在 DeepMind 团队工作。此前的主要成就包括训练SOTA视觉模型*(ImageNet SOTA于2019年至2021年实施);开放权重模型(SigLIP 和 PaliGemma),并致力于神经架构:BiT、ViT、MLP-Mixer 和 FlexiViT。

除此之外,编写灵活的、高性能的研究基础设施,尤其是 Jax。

此前,他在奥地利科学技术研究所(ISTA)攻读博士学位,研究兴趣为弱监督学习和图像生成模型。

曾经的Google CV“金铁三角”

在谷歌任职期间,三人多次合作并做出了影响该领域发展的重要工作。

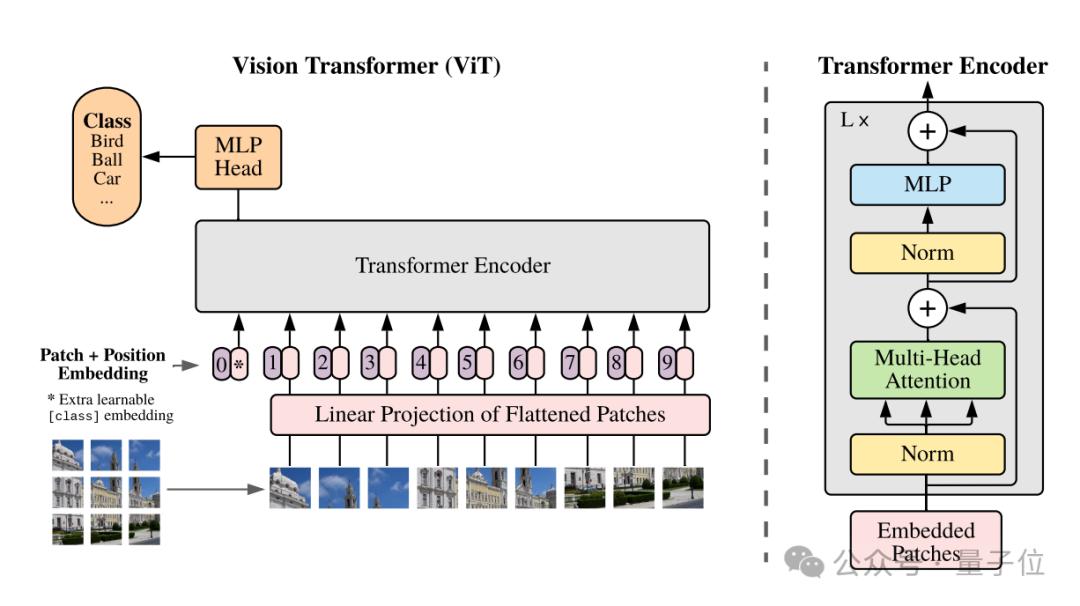

最重要的一个是ViT。

这项研究验证了 Transformer 架构在计算机视觉领域的多功能性。在此基础上又衍生出了Swin Transformer、DeiT(Data-efficient Image Transformers)等。

它创新性地提出将图像分割成固定大小的块,并将每个块视为一个序列元素,类似于 NLP 中的单词。然后通过变压器处理这些块。

ViT 在许多视觉任务中都优于传统的 CNN 模型,尤其是在大规模数据集上进行训练时。例如,在 ImageNet 分类任务上,ViT 取得了与最先进的 CNN 模型相当甚至更好的结果。

此外,他们还合作推出了MLP-Mixer、BiT(CV界的BERT)等领域的知名工作。

参考链接:

[1]

[2]

[3][4]

本文来自微信公众号“量子比特”,作者:明敏白小娇,36氪经授权发布。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/272975.html