12月10日,谷歌发布了最新一代量子芯片——Willow,引起全球科技界轰动。连马斯克都惊呼“哇”!

Willow芯片的威力有多大?距离量产还有多远?

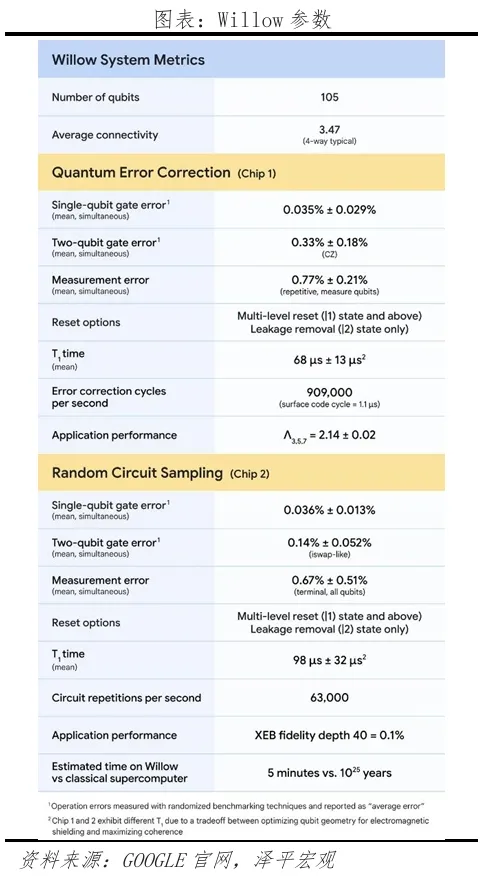

1、谷歌最新一代量子芯片Willow推出。最大的突破在于其超强的计算能力和纠错能力。

对于一项名为“随机电路采样”的基准任务,目前最快的超级计算机需要10^25年才能解决,这远远长于宇宙的年龄(267亿年);威洛用了不到10年的时间就完成了这项任务。至 5 分钟。

量子计算有潜力显着提高计算速度,在特定任务上超越经典计算机,这被称为“量子优越性”。早在 2019 年,谷歌就已经验证了这一事实,并在 Nature 上发表,表明其使用 54 量子比特的量子计算机 Sycamore 实现了传统架构计算机无法完成的任务:世界上第一台超级计算机需要在 10000 人的某个实验中进行计算年,梧桐只用了3分20秒。当时,谷歌首席执行官桑达尔·皮查伊表示,这就是研究人员等待已久的“Hello World”。这是迄今为止量子计算实际应用中最有意义的里程碑。

Willow的发布无疑是量子计算领域的又一里程碑事件。

然而,“快”并不是 Willow 最值得关注的突破。

Willow最大的亮点就是其超强的纠错能力。

过去,量子芯片在数据处理过程中,由于量子态的脆弱性,很容易受到环境干扰而发生退相干,导致量子比特的状态出现错误。因此,尽管量子计算机具有“量子优越性”,但它很容易受到环境影响,并且非常容易出错。一般来说,量子位越多,发生的错误就越多。

因此,“量子纠错”成为一项关键技术。量子芯片需要特殊的量子纠错技术。这也是该领域的一个重要挑战,一度严重制约了量子计算的实际应用和发展。

Willow芯片成功解决了困扰研究人员近30年的量子纠错问题,实现了错误率的指数级降低。谷歌的研究表明,Willow 中使用的量子位越多,系统的错误率就越低。

当量子比特数量增加时,从3×3阵列到5×5再到7×7阵列,Google的Willow芯片实验中的每一次扩展都可以将编码错误率降低2.14倍,并且错误率进一步降低。来得越来越快。

2.什么是量子计算?为何如此强大?

1935年,奥地利物理学家薛定谔提出了一个伟大的思想实验:把一只猫放在装有放射性物质的盒子里。放射性物质有50%的概率会衰变并释放出有毒气体杀死猫。同时,放射性物质有50%的概率不会衰变,猫就能活下来。在打开盒子之前,没有人知道猫是死是活。只能用“生与死的叠加状态”来形容。

量子世界就像“薛定谔的猫”一样,处于未解的叠加态;对应的新计算理论是“量子计算”,硬件层以量子芯片、量子计算机为代表。

量子计算具有两大优势:

一是强大的数据存储能力。经典计算以比特为基本单位,而量子计算以量子比特为基本单位。

在经典计算中,一个位的状态是确定的,要么是0,要么是1;而量子位则是0和1的叠加状态。也就是说,它可以同时存储0和1。

传统的n位芯片可以同时存储n条数据;而具有n个量子位的芯片可以同时存储2^n条数据。

其次,它展示了针对特定问题的强大并行计算能力。

传统的电子计算机是串行计算的。每个运算只能将单个值转换为另一个值,这意味着必须按顺序计算。量子计算机可以在一次操作中同时将 2^n 数据转换为新的 2^n 数据。

3、未来量子芯片能否取代GPU,推动AI发展?

近年来,人工智能技术和各种应用迅速发展,对计算能力的需求也呈指数级增长。

理论上,量子计算的并行处理能力使其在处理复杂的人工智能算法时具有天然的优势,可以极大地提高模型的训练速度和准确性。 Willow芯片的出现可能会为人工智能的进一步发展提供强大的计算能力。

事实上,现在广泛应用于人工智能的GPU最初是为了加速图形处理而设计的。比如游戏中的3D场景渲染、动画制作中的建模与特效处理、影视制作中的视频视觉效果等。不过,由于GPU强大的计算能力,后来被广泛应用于科学计算、人工智能等领域。人工智能,特别是深度学习的神经网络训练和推理阶段。它在处理大规模数据集和高并行计算任务方面表现良好。杰出的。

从这个角度来看,量子芯片未来将逐步取得突破,突破计算限制,加速各类AI机器学习算法的训练进程。量子芯片目前主要应用于一些需要极高计算复杂度的特定领域,如密码学中的加密算法破解(例如基于RSA算法对传统加密方法构成潜在威胁)、量子系统模拟(模拟分子、材料等量子层面的物理和化学性质)、解决复杂的优化问题(如物流规划、资源分配等复杂的组合优化问题)等。在这些领域中,量子计算的优势可以得到充分发挥,并且可以解决任务传统计算机无法在可接受的时间内完成。

量子芯片算力的增长主要与量子比特数量和质量的提高有关。未来,随着量子比特数量的增加,量子计算机的计算能力将呈指数级增长。每个额外的量子位都会使可能的状态组合数量加倍。例如,2个量子位有4种状态组合,3个量子位有8种状态组合,依此类推。同时,量子比特的质量(如相干时间、保真度等)也对计算能力产生重要影响。高质量的量子比特可以更有效地维持量子态,从而实现更准确、更复杂的计算。

不过,短期内量子芯片很难撼动GPU的地位。量子芯片的计算能力比GPU更强,理论上可以被替代。但GPU的护城河只是一方面:计算能力。更重要的是:可编程架构和开发者生态优势、制造技术和产业成熟度。

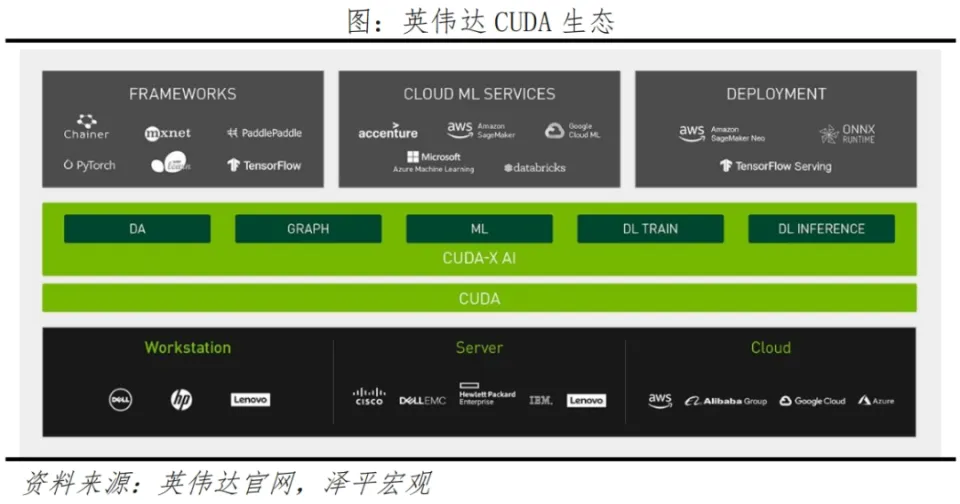

GPU的可编程架构和开发者生态是核心壁垒。 NVIDIA用GPU发起的“AI算力革命”已经铺垫了十多年。

CUDA(Compute Unified Device Architecture)是NVIDIA于2006年开发的第一个GPU编程架构平台,其价值在于构建GPU开发者生态系统。算法工程师可以根据自己的需求探索GPU的能力,这也扩展了GPU的能力。应用领域已从图形渲染扩展到通用领域。

如果基于新硬件(如量子芯片)开发新软件,需要向前兼容。但现有的主流AI软件基本都依赖CUDA平台开发,脱离CUDA架构需要很高的成本。再加上开发社区的护城河效应,很多高性能计算开发者在CUDA生态中积累了开发经验。 CUDA 每年的下载量高达 500 万次。将开发者社区推向其他编程模型还需要十年的时间。计划的项目。

GPU芯片制造技术和产业链成熟,拥有广阔的消费市场和良性的产业循环。

GPU诞生已经25年了,下游个人PC、定制开发、AI数据中心等商业应用场景已经落地10到30年。目前,GPU从芯片立项到流片需要一年时间,从流片到量产需要一年时间。以GPU发展为主基调,形成了光刻设备开发、晶圆代工工艺迭代等相应的联动循环。如此牢固的产业链,在十几年的良性循环中将很难被打破。

量子芯片制造和GPU产业链很难重叠。量子芯片的设计和制造过程极其复杂,需要高纯度的实验环境、精确的量子控制技术和稳定的量子比特。因此,长期以来,少数顶尖科技公司一直在“单打独斗”,尚未成熟。产业供应链。因此,短期内实现量子芯片的量产和商业应用是一个大问题。

4、量子芯片影响最大的领域:加密货币和“HPC+AI”

4.1 量子芯片或将是加密货币的“克星”

就比特币而言,其安全性建立在两个关键机制之上。首先是“挖矿”机制。比特币的输出是基于依赖于哈希函数的工作量证明(Proof of Work)。算力越高,挖矿成功的可能性就越大。二是交易签名,基于椭圆曲线数字签名算法(ECDSA),相当于用户的“身份钱包”。这两种机制的设计使得比特币在传统计算中几乎不可能被破解,而量子芯片将对比特币构成直接威胁。

一是通过量子计算暴力破解“挖矿”机制。量子计算算法可以加速哈希函数的计算,即挖矿速度加快,程度大于以往所有传统设备。挖矿成功率提高,加密货币供应量急剧增加,导致其市场价格大幅波动。 12月10日,比特币从10万美元跌至9.4万美元。 Coinglass数据显示,12月10日至12日,共有23.7万人平仓。

二是量子计算对交易签名的直接威胁。加密货币交易的凭证有两种类型:“公钥”和“私钥”。前者相当于银行卡号,后者相当于钱包密码。通常情况下,公钥地址的泄露不会影响用户资金的安全,但量子计算可以利用公钥破解签名、伪造交易。例如,量子计算中的Shor算法专门用于破解大整数的素因数分解和离散对数问题,这将对交易签名造成严重威胁。

虽然目前Willow对比特币构成的威胁不大,但未来加密货币很可能会被量子计算所突破。理论上,要对比特币的签名和挖矿机制发起攻击,大约需要数百万个物理量子比特。与威洛目前拥有的105个物理量子比特相比,差距还是很大的。但如果Willow像通用GPU一样迭代并实现量产和算力飞跃,那么未来十年比特币“被妥协”也不是没有可能。

4.2 量子芯片将推动“HPC+AI”,推动高水平人工智能发展

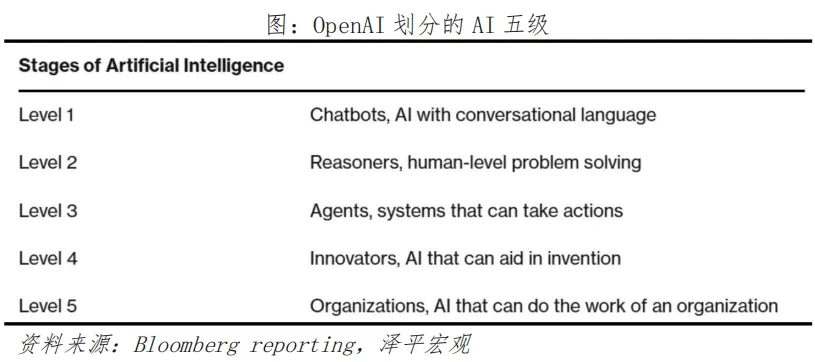

根据OpenAI对AI的分类,从L1(Chatbot)到L5(AGI),目前大型AI模型的发展仅处于L1到L2的过渡阶段。 L5级AGI被定义为“组织级能力”,能够在动态复杂的现实环境中判断、推理、预测和规划行动。业界认为,“HPC+AI”将是实现AGI的关键一步。

高性能计算(HPC)是指利用强大的计算机能力来解决科学、工程和技术实施问题。它在一定程度上类似于今天的大型AI模型,但方向和侧重点不同。

HPC 专注于“解决复杂问题”。例如,超级计算机在气象、物理、天文学等领域的应用带来了重大科研突破。

AI模型侧重于“推理和生成”。虽然它不擅长解决复杂模型,但具有良好的通用性。

量子芯片的实现是HPC领域的革命性突破。复杂问题的解决不再需要传统HPC的长期“蛮力计算”,而是可以向新的方向发展——结合AI进行更复杂的通用训练。

首先,传统的人工智能训练无法处理量子比特数据,而量子计算可以优化传统计算无法处理的特定学习模型,构建对量子现象敏感的系统模型。也就是说,未来的AI模型将具备推理和预测复杂世界的能力,与当前的大型模型相比,减少甚至消除“AI幻觉”的现象。

二是量子纠错技术的优势。 Willow芯片克服了量子纠错的关键挑战,实现了错误率的大幅降低。在高水平人工智能训练中,量子纠错技术的应用可以保证模型在训练和处理大量复杂数据时的准确性和可靠性,减少因量子比特的脆弱性带来的计算误差,从而提高人工智能的有效性和可靠性训练。可靠性。

虽然目前的AI训练还不具备应用量子芯片的条件,但未来很可能需要量子芯片作为算力的核心支撑。由于量子位极其敏感,容易受到外部环境因素(包括温度、电磁场)的影响,这些因素可能会导致量子态退相干,从而影响计算结果的准确性。尽管Willow在量子纠错技术上取得了一定进展,但在实际的人工智能训练应用中,为了实现长期稳定运行,量子系统的稳定性和抗干扰性能仍需进一步提高。

谷歌发布新一代量子计算芯片Willow,在全球科技界引起巨大轰动。这不仅是量子计算领域的重大突破,也是全球技术的下一个前沿。

未来量子计算技术的发展之路依然荆棘丛生,在人工智能训练大规模应用之前还有很多问题需要解决。

技术的进步从来都不是一帆风顺的,就像GPU从默默无闻到辉煌一样。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/273277.html