IT Home在2月7日报告说,Deep Opery System今天宣布UOS AI现已适应了DeepSeek-R1端端模型,并且官方在UOS AI中提供了两种“离线部署”和“在线访问”的方法DeepSeek-R1模型,用户可以根据自己的设备和网络环境进行选择。

IT主页注:离线部署方法支持Deepin 23和Deepin 25预览系统;在线访问方法支持UOS V20,Deepin 20.9,Deepin 23和Deepin 25预览系统。详细信息如下:

UOS AI脱机部署DeepSeek-R1 1.5B模型步骤1:更新UOS AI和矢量化模型插件

如果您使用的是Deepin 23,则可以将UOS AI从App Store更新为最新版本。

注意:如果您第一次下载并使用deepin中的UOS AI,则可以根据接口“检查用户协议 - 获取免费试用帐户”的提示直接输入UOS AI的新版本。 UOS AI的新版本。

如果您使用的是Deepin 25预览,请通过遵循命令将UOS AI升级到最新版本。

更新完成后,打开UOS AI的“设置”选项,在“模型配置 - 本地模型”中选择“矢量化模型插件安装/更新”,它将自动跳到App Store界面,然后单击install/install/update更新。 。

步骤2:安装DeepSeek-R1型号GGUF版本

UOS AI的模型后端驱动程序框架基于Llama.cpp。您可以在Magic Pai社区中直接找到DeepSeek-R1的GGUF版本。

在这里,我们将以最通用,最方便的1.5B型号为例。它的型号大小是中等的,需要低硬件配置。它仅需要CPU才能实现平稳的推理。 (如果您使用的是CUDA推理,则可以等待随后的Deepin系统更新推理后端框架的CUDA版本)。

已适应UOS AI的DeepSeek-R1 1.5B模型的下载地址如下:

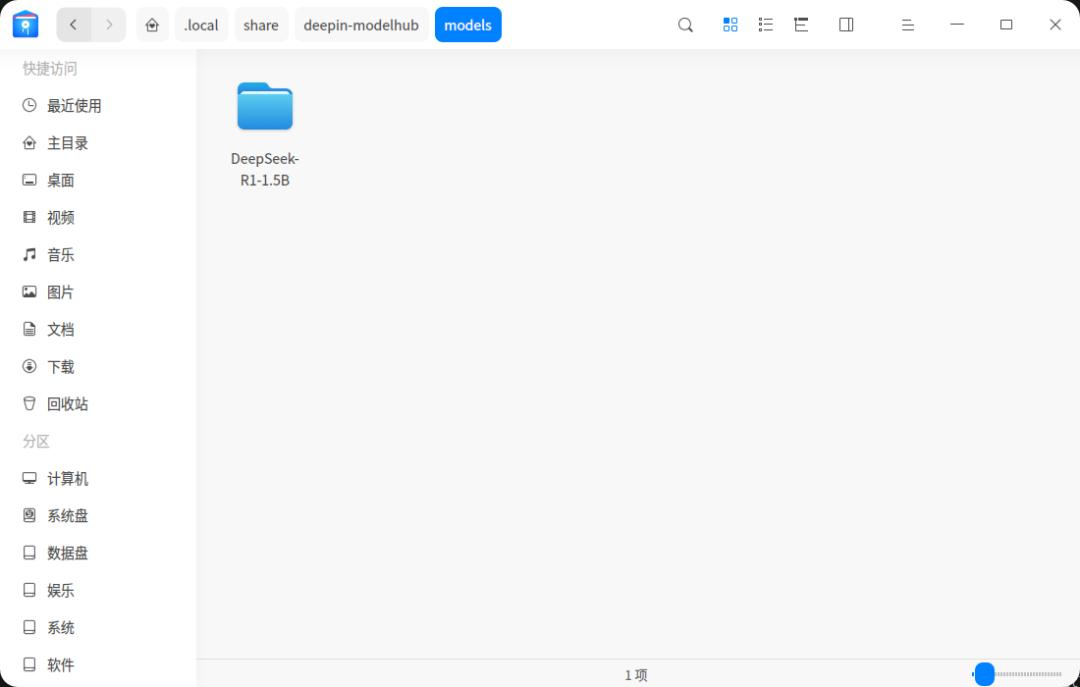

下载模型文件后,打开文件管理器并直接转到以下目录:

/home/用户名/.local/share/deepin-modelhub/models #其中用户名替换为自己的计算机用户名

注意:如果您没有Deepin-Modelhub文件夹和下面的型号文件夹,则可以自己手动创建文件夹。

输入模型文件夹,解开已下载的模型文件夹,然后将其直接复制到您刚创建的文件夹路径。请小心检查路径是否没有很多名称。该模型的完整途径如下:

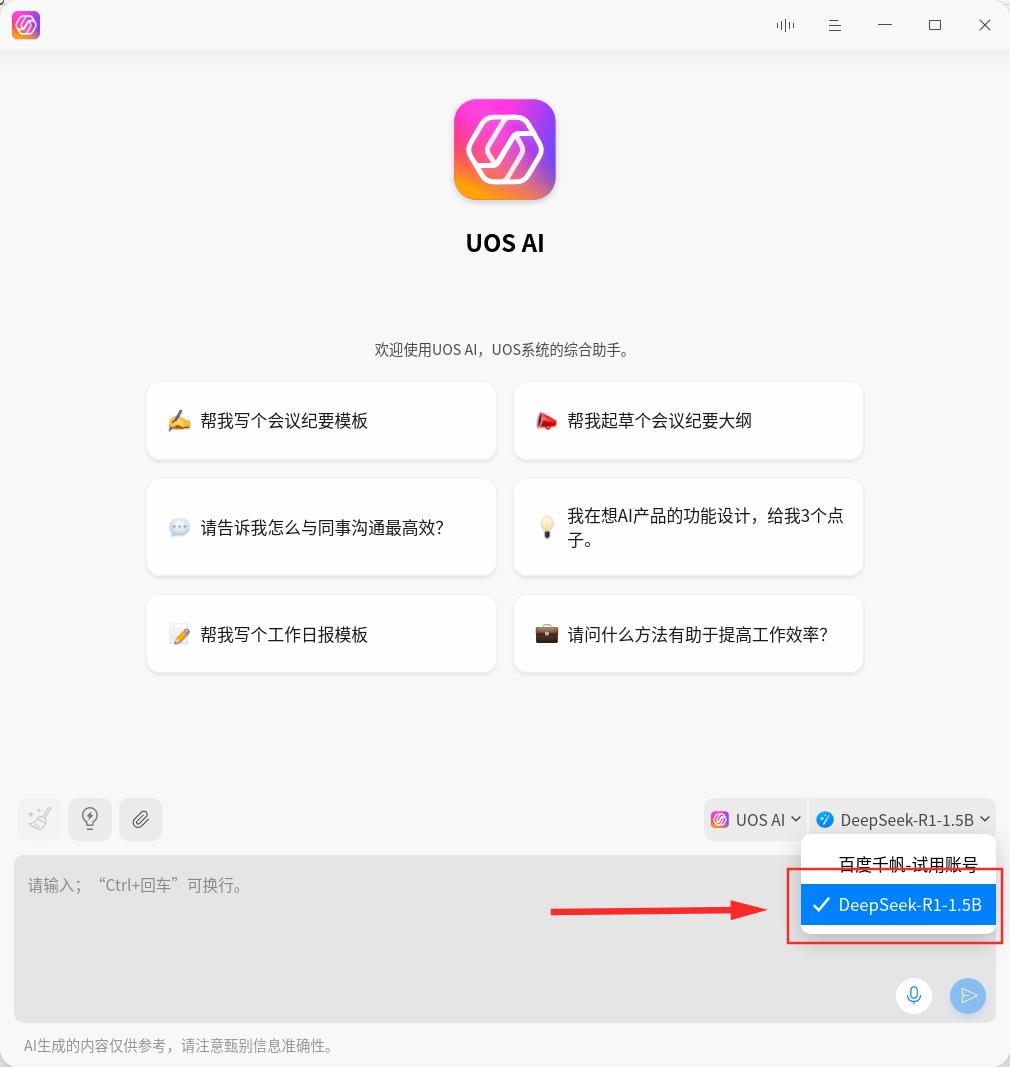

在上述步骤之后,再次打开UOS AI接口,您可以手动切换到DeepSeek-R1-1.5b型号。

这是一个简单的DeepSeek-R1运行示例:

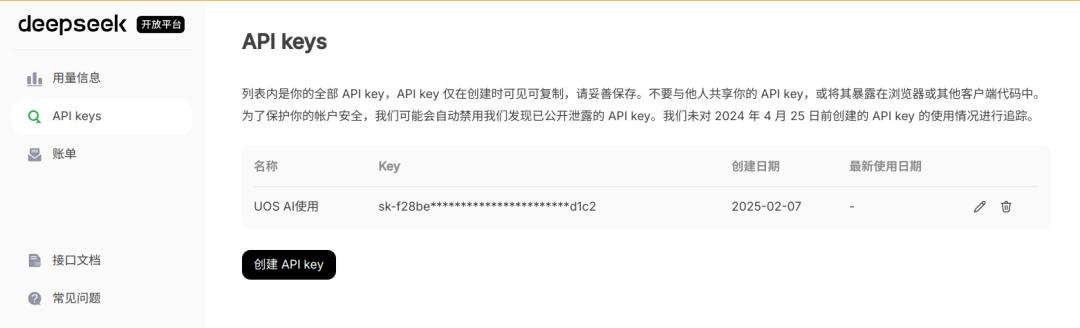

UOS AI在线访问DeepSeek-R1 Apistep 1:获取API密钥

访问DeepSeek官方网站,注册/登录到帐户,并创建并获取API密钥。如果由于服务器压力或其他问题,您无法访问上页,也可以使用其他访问渠道获取API密钥。

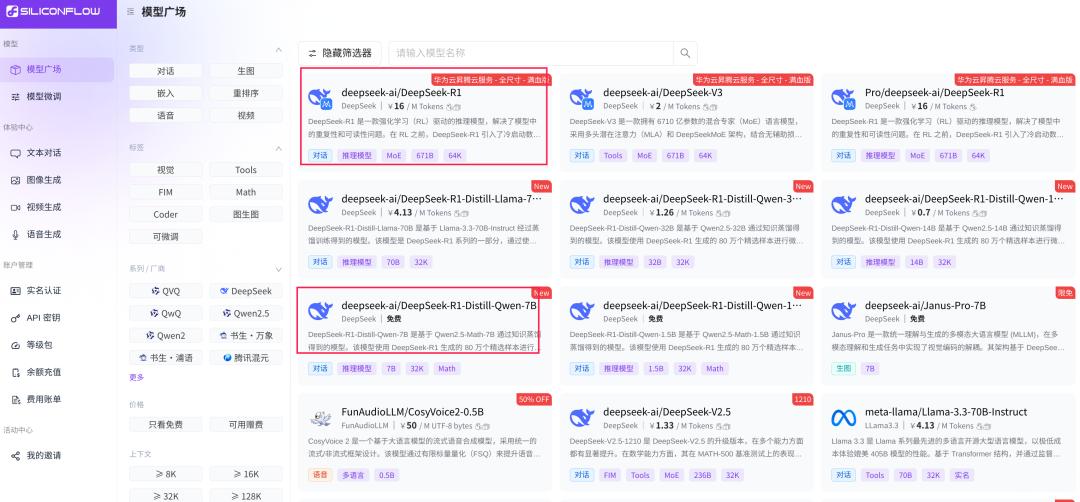

本文将以基于硅的流程为例。在帐户中注册/登录后,请访问API密钥管理页面以创建和获取API密钥。

步骤2:访问UOS AI中的DeepSeek-R1在线模型

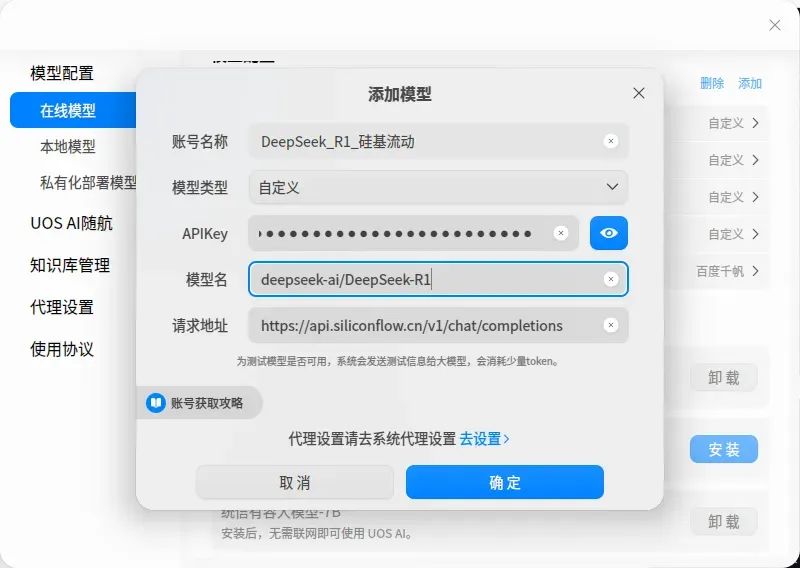

打开UOS AI的“设置”选项,在“模型配置”中选择“在线型号”,然后输入UOS AI的添加模型接口。

在添加窗口中完成内容,然后单击“确定”。此示例中使用的信息如下:

填写并提交确认后,您可以选择UOS AI中的DeepSeek-R1模型。

从理论上讲,只要您的基于硅的经常帐户中的余额就足够了,则可以通过上述方法在UOS AI中配置并调用其模型仓库中的所有模型。只需在上面的配置方法中填写模型名称中的相应完整模型名称即可。是的,其余的保持不变。

应该注意的是,在线大型模型会受到网络和用户访问的影响,偶尔可能会访问,超时或无法访问的情况缓慢。建议多次尝试。

由于当前的在线模型适应问题,DeepSeek的深思熟虑和对话内容的内容尚未分开,但这不会影响正常使用。 UOS AI团队将在随后的更新中尽快优化体验。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/273950.html