在 GPT 的多模态内容识别能力方面,Apple 智能的使用体验出现了奇特的情况。手机系统界面和 Apple 智能都已设置为中文,也能够用中文进行沟通。然而,经苹果私有云服务器转发的 GPT 请求,却只能给用户返回一个英文结果。并且,目前 Apple 智能在与 AI 交互的部分较为简单,用户暂时也无法手动将其设定为英文。

有时候,通过 Apple 私有云服务器转发的 GPT 返回的内容会以英文呈现。图片来源是极客公园。

在图像识别智能的综合体验方面,目前是基于 Google 搜索的图像内容搜索能力。在全部在中文环境下运行后,它所返回的搜索结果会优先从中文内容中抓取。对于更依赖即时中文互联网内容的搜索情况来说,这能够显著提升返回内容的流畅度,并且能提升信息的准确度。

我尝试用 Apple 智能去拍华为上周刚发布的新机 Pura X。Apple 智能通过搜索,准确地识别出了这款手机的具体型号以及官网开售信息。仅从这一点的体验来看,它已经在识别准确度上比主流多模态大模型做得更高。

Apple 精准地识别到了华为新发布的 Pura X 新机的信息。图片源自极客公园。

整体体验较之前的英文版本 Apple Intelligence 有提升。但客观而言,当下仅使用 GPT 或 Google 搜索,且未接入中国本土服务商的多模态大模型识别服务时,Apple 智能在多模态内容识别方面的体验仍需提升。

换句话说,即便你的 iPhone 目前已具备 Apple Intelligence 功能,但该功能在中国大陆的可用程度并非很高。即便你能够顺利地完成当前“视觉智能”所提供的所有服务,然而由 Google 搜索所给出的诸如商品购买链接等信息,对于大多数中国用户而言确实只是“仅供参考”而已。

这个问题的解法是明确的。我们可以期待苹果在今年推进与百度或阿里的合作,待这部分功能完全本地化后,去体验其成果。

在 Writing Tools 写作工具中,除了能进行这些直接交互外,还可以校对、改写或总结文本,并且支持通过 GPT 直接起草内容,这部分能力如今也已加入对中文的支持,对于不少朋友来说,这可能是最熟悉大模型能力的使用场景之一。

语言生成工具或许是很多人最为熟悉的大模型应用领域。图片的来源是极客公园。

实际体验后发现,这部分功能在备忘录中的整合情况是,无论是进行改写,还是直接生成一份文档,在中文场景中都能提供类似 GPT 的体验。并且,由于它与 Apple 输入法/第一方 App 进行了整合,所以对于 iPhone 用户来说,确实变得更加方便了。

02

不求最快,但求最「稳」

但这显然并非苹果在端侧 AI 上所能达成的全部。虽然将 Siri 目前所展现出的综合体验与 GPT、豆包等模型的使用体验相比较,它还远远称不上“行业领先”。

苹果的“保守”,或许能被解读为苹果对新技术一贯的“谨慎”。它不仅不急于在智能手机上拓展 AI 能力的边界,还主动为 AI 设置围栏。在备忘录的 AI 改写功能中,它对于改写写作风格的调性是偏向保守的;

在用于创建风格化自定义图像的 Playground 中,之前有提到过,用户能明显察觉到它与其他大厂发布图像生成工具的不同。它完全不能像今年爆火的预训练图像生成模型 Lora 那样,用于生成和真人几乎无异、让人真假难辨的图像。

Playground 生成了 Genmoji 的效果,图片的来源是 Apple。

实际上这种谨慎是有道理的。多模态大模型已经出现几年了,然而当下伴随着大模型应用“蒙眼狂奔”,存在着一些问题,比如内容幻觉,还有 AI 生成内容被用于犯罪等。近年来,AI 生成的虚假内容在网络中大量充斥。

在 AI 时代,除了要应对内容泛滥的问题,如何保护用户的私有数据也成为了一个重要的命题。苹果是率先直面这一问题的厂商,并且喊出了自家的解决方案。

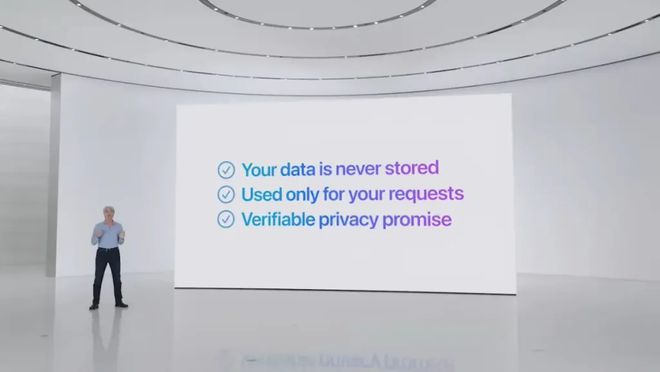

Apple Intelligence 有一个重要特征,即在 AI 时代依然坚持“隐私优先”的技术路径。系统会在设备本地首先进行处理;若任务超出本地处理能力,就会借助“私有云计算”来调用苹果自研的服务器,并且整个过程都是加密的,这样能保证用户数据不会被用于模型训练或者被第三方存储。

苹果是目前唯一一个会公开讲解利用私有云转发机制来保护用户隐私的厂商。图片来源为极客公园。

硬件之外,面向开发者的便捷工具正在筹备中。iOS18.2 Beta 测试版发布之后,苹果紧接着更新了三个重要的 Apple Intelligence 功能的 API,分别是编写工具 API、Genmoji API 和 Image Playground API。

这三个 API 接口,其目的是帮助开发人员把 Apple Intelligence 整合到他们的应用程序里。也就是说,随着越来越多这样的 API 接口加入进来,开发者能够在所有 Apple 生态的硬件设备上调用端侧模型的计算能力,并且不需要额外的服务器成本。当前 Apple 生态有数以亿计的用户,这对中小开发者和巨头来说,都是一个极具吸引力的条件。

由此可见,苹果的第一方应用目前并非追求短暂效果来取胜。它通过构建软硬件深度整合的体系,以及搭建原生 AI 硬件生态平台,为开发者提供了一个适宜 AI 时代超级 App 生长的土壤。

从长期来看,只有像苹果和华为这样,具备自有生态、硬件以及掌控能力的厂商,才具备参与深度竞争的机会;拥有生态的平台级玩家,与仅仅只有“硬件制造商”这一单一标签的厂商,或许在这场竞争开始的那一刻,就已经拉开了巨大的差距。

回到文章最初提出的那个问题:“支持简体中文后,Apple 智能真的更加好用了吗?”

在长期使用英文版 Apple Intelligence 之后,又使用了主流手机 AI 助手类工具。我的回答是,它变得更加好用了。然而,对于苹果来说,或许真正能让 AI 更加好用的下一步更加值得关注。

对于用户而言,这或许是 Apple 智能在逐步靠近中国用户的过程中,最值得我们关注的问题。 Apple 智能在向中国用户靠近的过程中,此问题最值得用户关注。 在 Apple 智能迈向中国用户的进程里,这是最值得我们关注的问题。 对于用户来说,Apple 智能迈向中国用户的过程中,这一问题最值得关注。 这或许是 Apple 智能走向中国用户过程中,最值得用户关注的问题。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/275308.html