内容来自:机器之心

Meta 选择在周六和周日这两天发布了最新的 AI 模型系列——Llama 4,它是 Meta 的 Llama 家族中的最新成员,这真是让人万万没想到。

该系列包含 Llama 4 Scout、Llama 4 Maverick 以及 Llama 4 Behemoth。这些模型都历经了大量的未标注文本、图像和视频数据的训练,从而让它们具备了广泛的视觉理解能力。

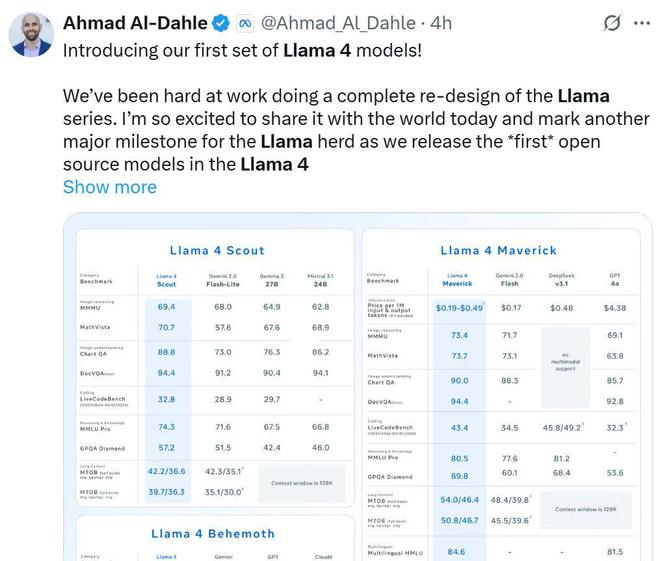

Meta GenAI 负责人 Ahmad Al-Dahle 称,Llama 4 展现出 Meta 对开源 AI 的长期投入,以及对整个开源 AI 社区的坚定信念,即开放系统能够产出最优秀的小型、中型和即将出现的前沿大模型。

谷歌的 CEO 劈查伊发出了感叹,他觉得人工智能的世界从来都不会无聊。他向 Llama 4 团队表示了祝贺,并且希望他们能够继续前进。

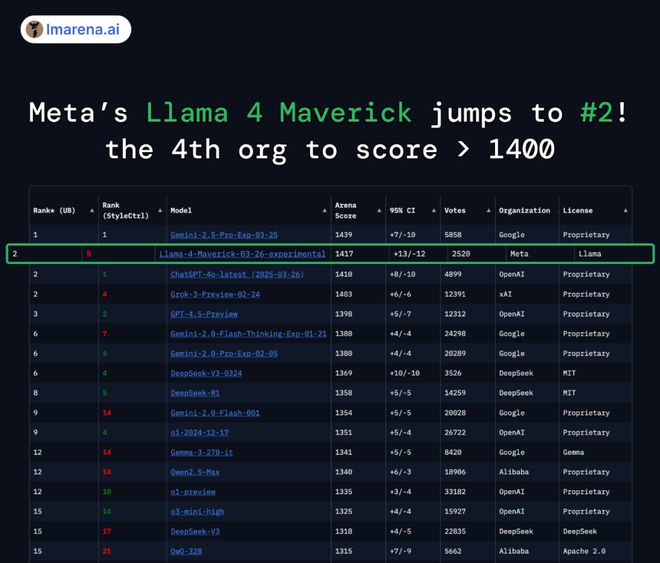

Llama 4 Maverick 在大模型竞技场(Arena)中总排名第二,并且它成为了第四个突破 1400 分的大模型。开放模型排名第一,它超越了 DeepSeek;在困难提示词任务、编程任务、数学任务、创意写作任务等中排名都是第一;大幅超越了自家的 Llama 3 405B,得分从 1268 提升到了 1417;风格控制排名第五。

那么 Llama 4 模型系列有何特点呢?具体而言:

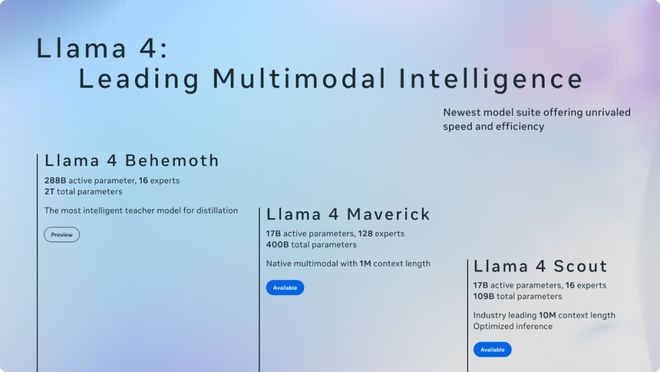

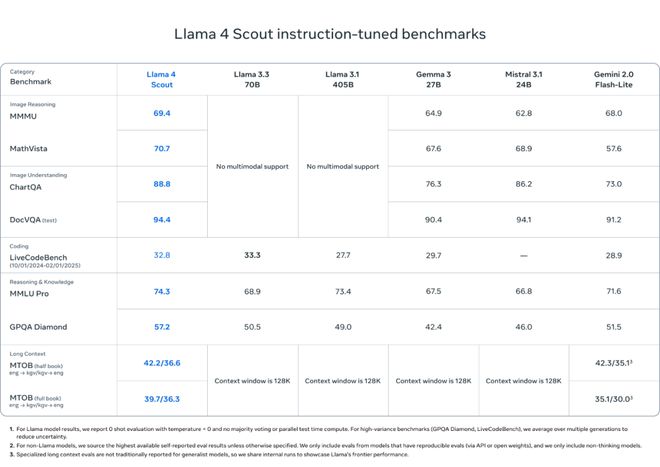

Llama 4 Scout 具有 170 亿激活参数以及 16 个专家。它是同类中全球最为出色的多模态模型。相较于前几代 Llama 模型,它更为强大。并且它能够适配单个 NVIDIA H100 GPU。Llama 4 Scout 提供了 10M 上下文窗口,在业界处于领先地位。并且在基准测试中表现良好,这些基准测试有广泛的报道。它的表现优于 Gemma 3、Gemini 2.0 Flash-Lite 和 Mistral 3.1。

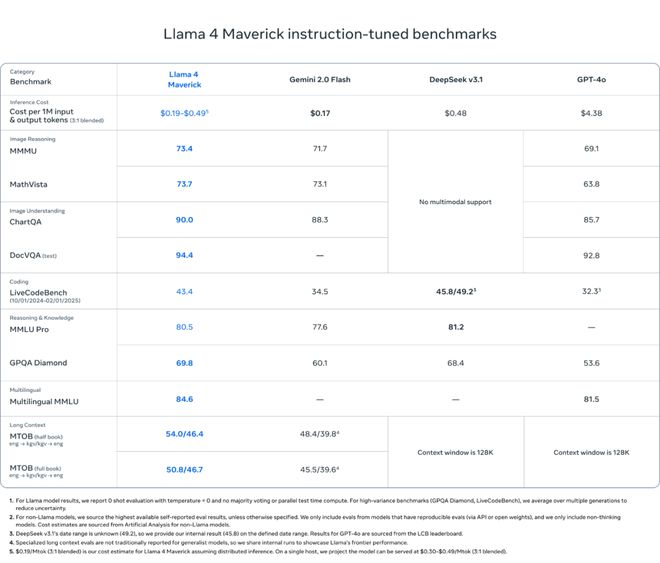

Llama 4 Maverick 拥有 128 位专家,它有 170 亿个激活参数,是同类中最好的多模态模型。在广泛报道的基准测试中,它击败了 GPT-4o 和 Gemini 2.0 Flash,并且在推理和编程方面取得的结果与新 DeepSeek v3 相当,但其激活参数不到一半。Llama 4 Maverick 具备一流的性价比。它的实验性聊天版本在 LMArena 上的 ELO 得分是 1417。

Meta 迄今最好的这两个模型,主要是因为它们由拥有 2880 亿激活参数和 16 个专家的 Llama 4 Behemoth 模型进行知识蒸馏而得。

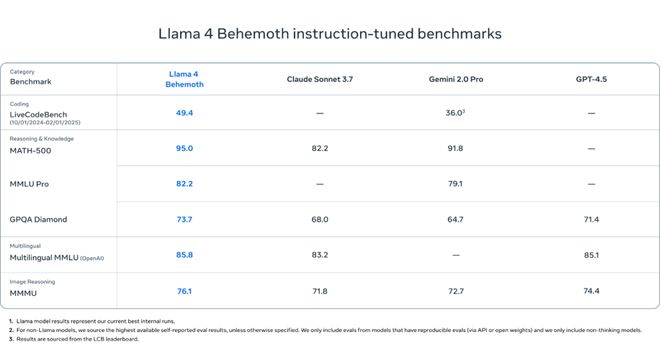

Llama 4 Behemoth 是 Meta 当下最为强大的模型之一,同时也是世界范围内最为智能的大型语言模型之一。在诸多科学、技术、工程以及数学(STEM)的基准测试里,Llama 4 Behemoth 的表现要比 GPT-4.5、Claude 3.7 Sonnet 和 Gemini 2.0 Pro 都好。

Llama 4 Behemoth 仍处于训练阶段,之后 Meta 将会放出更多的相关内容。

好消息是,用户当下就能够在 llama.com 以及 Hugging 平台上下载 Llama 4 Scout 和 Llama 4 Maverick 的最新模型。

Llama 4 模型都采用了原生多模态设计。例如,上传一张图像后,你能够询问关于这张图像的任何问题。

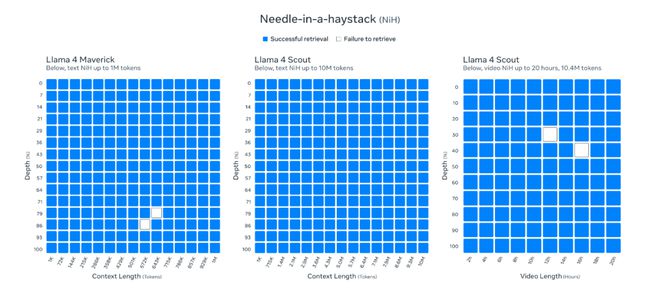

Llama 4 Scout 能够支持的上下文长度达到 1000 万 token 。这在目前的行业中是最长的上下文长度。它解锁了围绕记忆的新用例,也解锁了围绕个性化的新用例,还解锁了围绕多模态应用的新用例。

Llama 4 在图像 grounding 方面表现出色。它能够把用户的提示和相关的视觉概念进行对齐,还能够将模型的响应固定在图像中的区域。

Llama 4 经过了预训练以及微调。它能够理解 12 种语言的文本,且这些文本是无与伦比的。它还支持在全球进行开发和部署。

预训练

Meta 在构建下一代 Llama 模型的过程中,在预训练这个阶段,尝试了诸多不同的新方法。

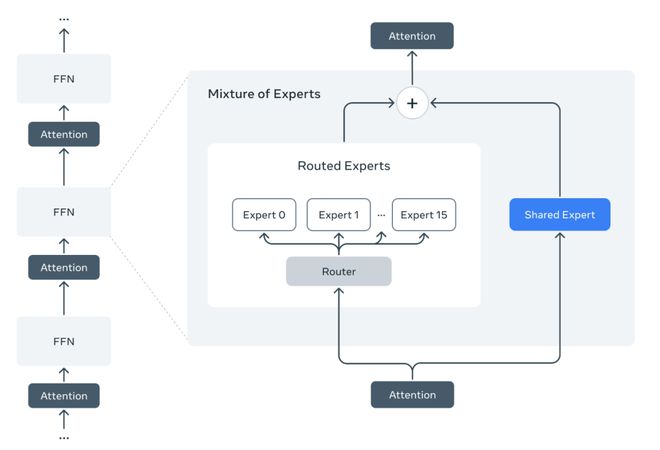

Meta 首次采用了混合专家(Mixture of Experts, MoE)架构。在这种 MoE 模型里,单个 token 只会激活全部参数中的一部分。Meta 宣称,MoE 架构在训练以及推理过程中计算效率更高,在固定的训练 FLOPs 预算之下,相较于密集模型能够提供更高的质量。

以 Llama 4 Maverick 模型作为例子,此模型具备 170 亿激活参数以及 4000 亿总参数。Meta 通过运用交替的密集层与混合专家(MoE)层,以提升推理效率。在 MoE 层当中,他们运用了 128 个路由专家以及一个共享专家。每个 token 也会被发送到 128 个路由专家中的一个。

所有参数都存储在内存中。然而,在服务这些模型时,只有总参数的一部分会被激活。这样做能够降低模型服务成本和延迟,从而提高推理效率。Llama 4 Maverick 既可以在单个 NVIDIA H100 DGX 主机上运行,便于部署,也可以通过分布式推理来实现最高效率。

Llama 4 系列模型采用原生多模态设计。它通过早期融合的方式,将文本和视觉 token 无缝整合到统一的模型骨干中。早期融合是一个重大进步,因为利用这种方式能够使用大量未标记的文本、图像和视频数据对模型进行联合预训练。Meta 改进了 Llama 4 中的视觉编码器,此编码器是以 MetaCLIP 为基础的,目的是让编码器能更好地适应 LLM。

Meta 开发了一种新的训练技术,名为 MetaP。这种技术能够设定模型的超参数,并且设定得很可靠,比如每层的学习率以及初始化规模等。Meta 发现,所选定的超参数在不同的批量大小、模型的宽度、深度以及训练 token 值之间,有着良好的迁移性。

Llama 4 对 200 种语言进行了预训练。它支持开源微调工作。这些语言中包含超过 100 种。每种语言的 token 数量超过 10 亿。总体而言,它比 Llama 3 多 10 倍的多语言 token。

Meta 运用 FP8 精度来进行训练,这样既保证了质量,又确保了高 FLOPs 利用率。Meta 在使用 FP8 以及 32K GPU 对 Llama 4 Behemoth 模型进行预训练的时候,达到了每 GPU 390 TFLOPs 的效果。训练使用的数据混合总量达到了 30 万亿 token 以上,这个总量比 Llama 3 的预训练数据混合量要多两倍多。并且,它涵盖了各种不同类型的文本、图像以及视频数据集。

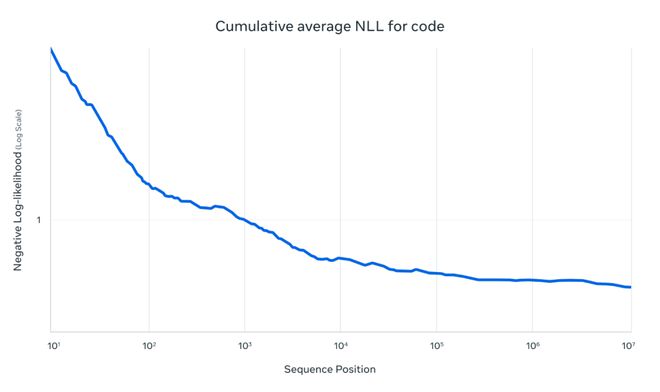

Meta 借助所谓的中期训练来持续训练模型,以此提升模型的核心能力。其中包括运用专门的数据集来扩展长上下文。这样一来,Meta 在提升模型质量的同时,也为 Llama 4 Scout 开启了业界领先的 1000 万输入上下文长度。

后训练

Llama 4 Maverick 在图像和文本理解领域提供了卓越且处于行业领先地位的性能,能够构建跨越语言障碍的复杂人工智能应用。它作为通用助手和聊天用例的主要产品模型,在精确理解图像以及进行创意写作方面都有着出色的表现。

在对 Llama 4 Maverick 模型进行后训练的过程中,最大的挑战在于平衡多种输入模态、推理能力以及对话能力。Meta 为了实现混合模态,设计了一种经过精心策划的课程策略,并且这种策略与单一模态专家模型相比,不会使性能降低。

Meta 在 Llama 4 中采用不同方法全面改进后训练流程,依次为轻量级监督微调(SFT)、在线强化学习(RL)、轻量级直接偏好优化(DPO)。Meta 发现,SFT 和 DPO 可能会对模型过度约束,限制在线 RL 阶段的探索能力,进而致使推理、编程和数学领域的精度降低。

为解决此问题,Meta 以 Llama 模型作为评判依据。它移除了超过 50%标记为简单的数据。接着在剩余较难的数据集上进行了轻量级监督微调。在后续的多模态在线强化学习阶段,通过精心挑选较难的提示,使得性能有了显著提升。

Meta 实施了持续在线的 RL 策略,对模型进行交替训练,并且利用该策略持续地过滤和保留中等至高难度的提示。这种策略在计算和准确性的权衡方面有着很大的益处。

Meta 进行了轻量级的直接偏好优化(DPO),其目的是处理与模型响应质量相关的边缘情况。通过这种方式,有效地实现了模型智能与对话能力的良好平衡。这些改进使得 Meta 拥有了一个业界领先的通用聊天模型,该模型具备最先进的智能和图像理解能力。

性能

它以更低的价格提供了更高的质量。由下表能看出,Llama 4 Maverick 是同类里最棒的多模态模型。在编码方面,它的性能超越了类似模型如 GPT-4o 等;在推理方面,它也超越了类似模型如 GPT-4o 等;在多语言方面,它表现出色;在长上下文方面,它很突出;在图像基准测试中,它的性能超过了类似模型如 GPT-4o 和 Gemini 2.0;并且在编码和推理方面,它与规模更大的 DeepSeek v3.1 具有竞争力。

Llama 4 Scout 是通用型模型。它拥有 170 亿激活参数,有 16 个专家。总参数达 1090 亿。能在所属类别中提供最先进性能。它将支持的上下文长度从 Llama 3 的 128K 提升至 1000 万 token,且处于业界领先地位。这为推理庞大代码库提供了更多可能性。

Llama 4 Scout 在预训练阶段使用 256K 上下文长度,在其后训练阶段也使用 256K 上下文长度。这使得基础模型具备了强大的长上下文泛化能力。在大海捞针检索等任务中,该模型展示出了令人信服的结果。

Llama 4 架构的一个关键创新在于运用无位置嵌入的交错注意力层。这种交错注意力层能够增强长上下文的泛化能力,并且是通过推理时的温度缩放来实现的。这种架构被称作 iRoPE 架构。在该架构中,i 代表交错注意力层,这强调了它能够支持无限上下文长度的长期目标。RoPE 指的是在大多数层中所使用的旋转位置嵌入。

Meta 对两款模型进行了广泛的图像训练,同时也进行了视频帧静止图像训练。通过这样的训练,赋予了它们广泛的视觉理解能力,其中包括对时序活动以及相关图像的理解。这使得模型在面对多图像输入和文本提示时,能够轻松地进行视觉推理和理解任务。这些模型在预训练阶段最多可支持 48 张图像,在后训练过程中则可以支持 8 张图像,并且取得了良好的结果。

Llama 4 Scout 在图像定位方面表现很出色。它可以把用户的提示和相关的视觉概念对应起来,还能把模型的响应固定在图像中的特定区域。这样一来,大型语言模型就能更精准地进行视觉问答,也能更好地理解用户的意图并且定位出感兴趣的对象。

Llama 4 Scout 在编码方面超越了类似模型,在推理方面也超越了类似模型,在长上下文方面同样超越了类似模型,在图像基准测试中也超越了类似模型,并且比所有之前的 Llama 模型表现都更强。

将 Llama 推向新的尺度:2T Behemoth

Llama 4 Behemoth 预览版是一个教师模型。它还是一个多模态混合专家模型。该模型拥有 2880 亿激活参数,有 16 个专家,并且总参数近 2 万亿。

它在数学、多语言和图像基准测试方面,提供了非推理模型的顶尖性能,并且是教授较小的 Llama 4 模型的绝佳选择。

对拥有两万亿参数的模型进行后训练是个巨大挑战,这需要研究者从数据规模着手,对训练方案进行彻底的重新设计和改进。Meta 为了最大化性能,不得不将监督微调(SFT)数据进行 95%的剪枝,而较小模型的剪枝比例是 50%。此举措是为了在质量与效率上取得必要的平衡。Meta 发现,先进行轻量级的监督微调(SFT),接着进行大规模的强化学习(RL),这样做可以显著地提升模型的推理能力和编码能力。

Meta 的强化学习方案重点在于利用策略模型开展 pass@k 分析,会采样那些难度较高的提示,同时构建难度逐步提升的训练课程。另外,在训练期间会动态地把零优势的提示过滤掉,并且构建包含多种能力的混合提示训练批次,这些举措在数学、推理以及编码方面让模型取得了显著的性能提升。最后,从多种系统指令中进行采样是很重要的。这样能确保模型在推理任务中保持指令遵循能力,也能让模型在编码任务中保持指令遵循能力。这使得模型能够在多种任务中都表现出色。

为两万亿参数的模型扩展强化学习(RL)是一项极大的挑战,这使得 Meta 必须重新设计并改良底层的强化学习基础设施,从而应对前所未有的规模。

Meta 优化了混合专家(MoE)并行化的设计,目的是提升速度,进而加快迭代过程。同时,他们开发了一个完全异步的在线强化学习训练框架,使灵活性得到了增强。现有的分布式训练框架与之不同,它会将所有模型加载到内存中,从而牺牲了计算内存。而 Meta 的新基础设施很灵活,能够把不同模型分配到不同的 GPU 上,还能依据计算速度在多个模型间平衡资源。这一创新使训练效率比上一代提升了约 10 倍。

Llama 4 Maverick 现已开放下载,其地址为:

参考链接:

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/275310.html