推理已成为语言模型的下一个主要前沿领域,近期在学术界取得了突飞猛进的进展,同时在工业界也取得了突飞猛进的进展。

在探索过程中,有一个核心议题,那就是:对于提升模型推理性能而言,什么是有效的?什么是无效的?

DeepSeek - R1 论文提到:我们发现把强化学习用在这些蒸馏模型上能得到明显的进一步提升。3 月 20 日,该论文再次验证了 RL 对于蒸馏模型的有效性。

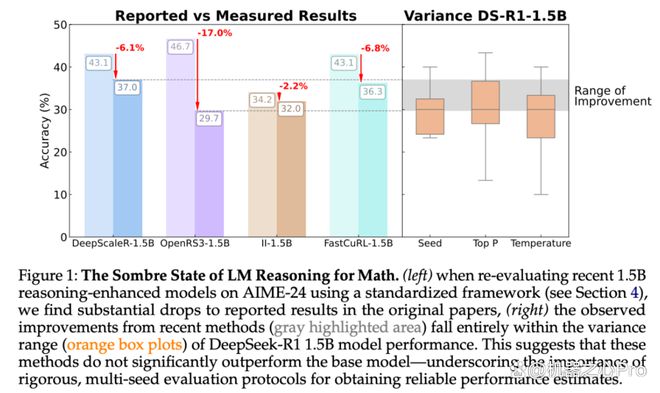

这些论文的结论都指向了强化学习带来的显著性能提升,然而,图宾根大学和剑桥大学的研究者发现,强化学习所导致的许多“改进”或许仅仅是噪音。

从严肃的角度审视语言模型推理的进展:可重复性的陷阱与路径

论文链接:

受推理领域中越来越多相互矛盾的经验性说法的影响,我们对推理基准的现况展开了严谨的调查。我们尤其关注了在数学推理领域中,用于评估算法进展的最常用测试平台之一——HuggingFaceH4(2024 年)以及 AI - MO。

论文表明,在诸如 AIME24 这样的小型基准测试里,结果呈现出极不稳定的状态。仅仅对一个随机种子进行改变,就能够让得分出现几个百分点的变化。当在更为可控且标准化的设置下对强化学习模型进行评估时,它所获得的收益要比最初所报告的小很多,并且通常不具备统计显著性。

然而,一些经强化学习训练的模型确实展现出了一定程度的改进。这些改进通常相较于监督微调所获得的成果而言更弱。并且,它们通常难以很好地推广至新的基准。

研究者对造成这种不稳定性的根本原因进行了系统分析,这些原因包含采样差异、解码配置、评估框架以及硬件异质性。我们指出,如果不加以仔细控制,这些因素将会极大地扭曲结论。与此同时,研究者提出了一套最佳实践,其目的是提升推理基准的可重复性和严谨性。

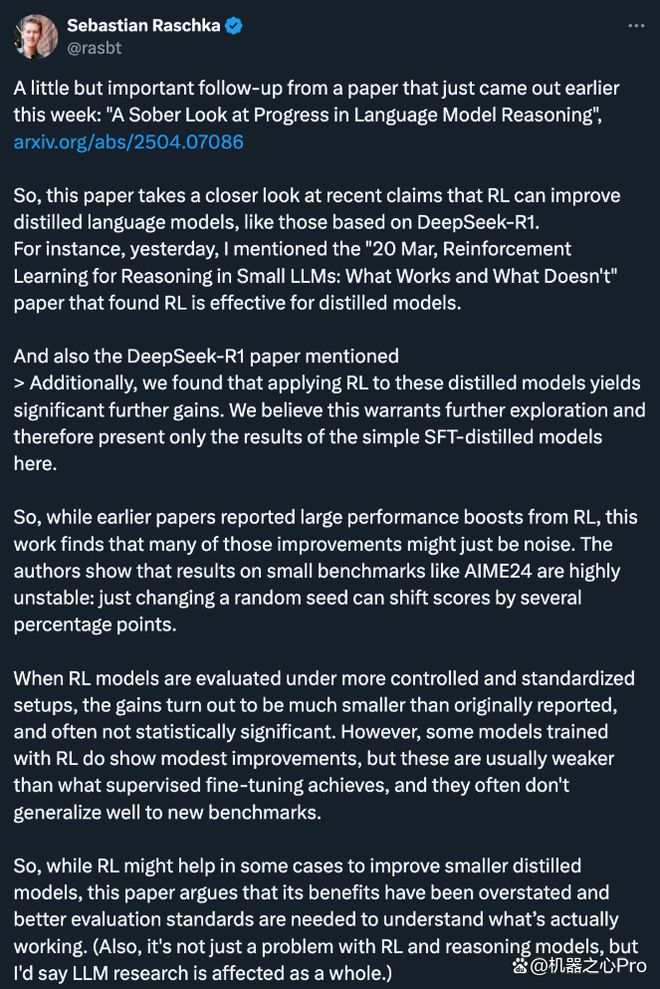

AI 研究者 Sebastian Raschka 称:强化学习在某些情形下或许有助于提升较小的蒸馏模型。然而,它的益处被夸大了,需要更优良的评估标准,以知晓哪些方法切实有效。并且,这并非仅仅是强化学习与推理模型的问题,他认为 LLM 研究在整体上都受到了影响。

探索推理的设计空间:什么最重要?

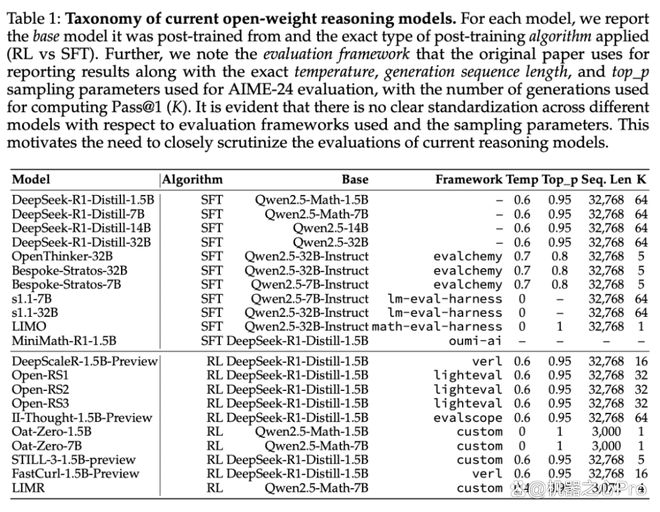

最近的以推理为重点的语言模型是在不同的条件下进行评估的。这些条件包括评估框架的差异,还有硬件的差异,以及随机种子数量的差异、温度的差异和核采样参数(top_p)的差异。(见表 1)

此前的研究考察了采样参数在多选题和编码任务中的影响。然而,这些选择对开放式推理模型(特别是那些用强化学习训练的模型)的影响尚未得到充分探索。

本文的研究者对这些设计选择影响性能的情况进行了系统评估,同时强调了对结果可靠性影响最大的变异来源。

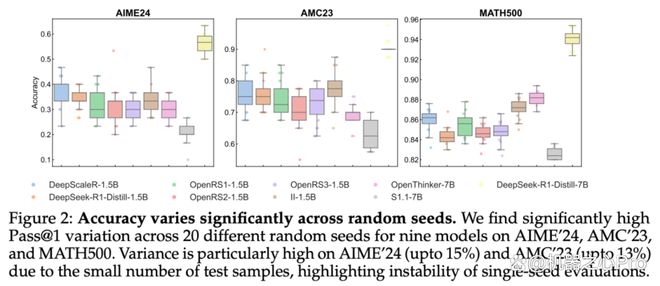

评估中的种子方差

研究者首先对评估过程中使用的随机种子所导致的方差进行了分析。这是基准测试实践中常常被忽略的一个方面。近期的工作虽然要求统计的严谨性,比如使用误差棒和进行多次运行,但评估通常依赖单种子运行,这就掩盖了潜在的变异性。本文评估了九种模型,每种模型在 20 次独立评估运行中种子所引起的变异。结果如 2 图所示。

可以看到,Pass@1 值的标准偏差很高。各种子的标准偏差在 5 个百分点到 15 个百分点之间。这一问题在 AIME'24 和 AMC'23 中较为严重。AIME'24 只有 30 个测试样本,AMC'23 只有 40 个测试样本。仅一个问题的变化就能使 Pass@1 偏移 2.5 - 3.3 个百分点。

硬件和软件因素造成的差异

硬件以及评估框架等并非显而易见的因素会引发性能差异,然而这一点却很少被承认。模型一般是在异构系统上进行测试的,并且会运用不同的工具链来进行评估。

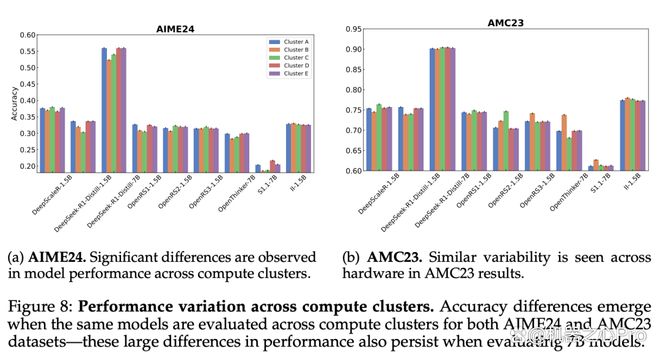

硬件差异

研究者对同一模型进行了评估,评估在五个不同的计算集群上进行。每个集群的 GPU 类型不同,内存配置也各不相同。

如图 8 所呈现的那样,在 AIME'24 这一平台上,OpenRS - 1.5B 的性能存在高达 8%的差异,而 DeepSeek - R1 - Distill - 7B 的性能差异是 6%。并且,在 AMC'23 上也观测到了与之相似的这种趋势。众所周知,vLLM 等推理引擎对硬件差异较为敏感。在 PyTorch 或 CUDA 中,底层优化可能会引入非确定性。然而结果显示,即便对多个种子进行平均,这些影响依然会对基准精度产生显著的影响。

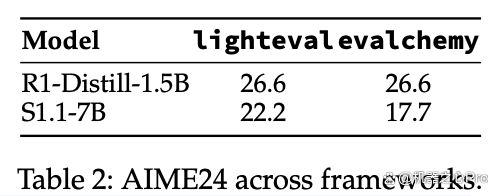

不同 Python 框架下的评估

研究者为了评估这种影响,将 lighteval 和 evalchemy 进行了比较,并且在比较过程中让所有其他变量保持固定不变,这些变量包括模型、数据集、硬件、解码参数和随机种子,每种模型都有 3 个。

研究者为了进行公平比较,在单个 GPU 上,以默认的温度和 top_p 参数值,对 DeepSeek - R1 - Distill - 1.5B 以及 S1.1 - 7B 这两个模型进行了评估。为提升鲁棒性,本文给出了三个种子的平均结果。

如表 2 所呈现的那样,框架所导致的差异一般较为微小,大概在 1 - 2pp 之间。然而,即便在聚类较为紧密的情形下,它依然会对模型的排名产生影响。

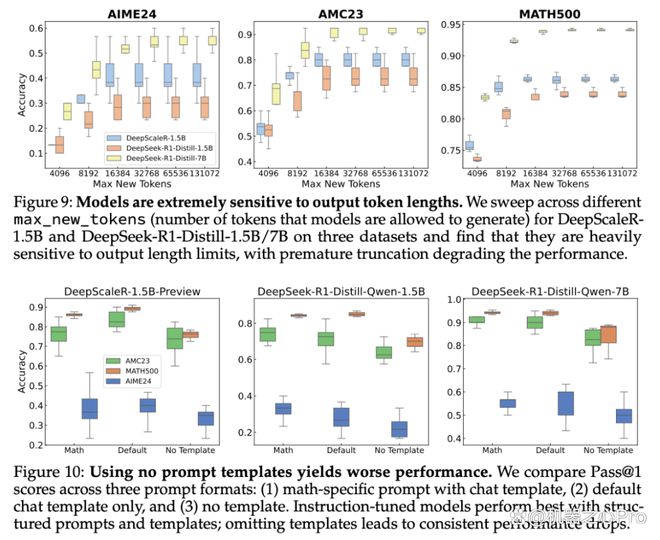

Prompt 格式和上下文长度的影响

最大输出的 token。从图 9 能够看出,降低 max_new_tokens 会使性能下降,尤其在长表单问题方面。这种敏感度会因模型以及数据集的不同而有所差异。尽管减少这一设置能够降低成本,然而却可能引发过早停止的情况,进而导致出现错误答案。

如图 10 表明,模型在运用数学特定 Prompt 以及其本地聊天模板时能达到最佳状态。省略模板会使性能降低,尤其对经过指令调优的模型而言。

(一级)怎么解决?答案是「评估的标准化」

研究者在本节会对评估框架进行标准化处理,同时会对现有的方法展开全面的评估。关键结论呈现如下:

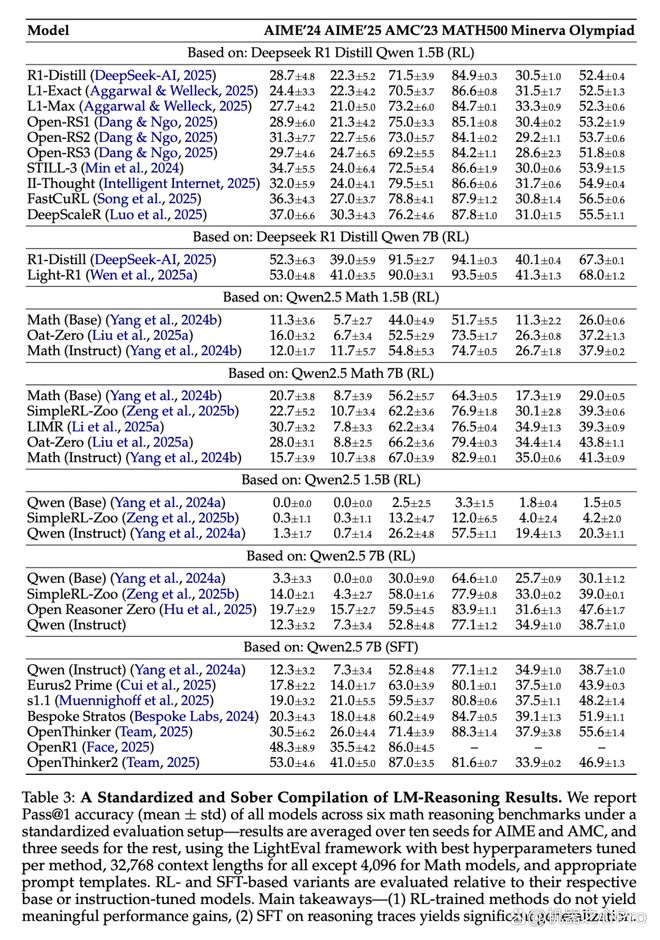

大多数 DeepSeek R1 - Distill 模型的变体是通过强化学习(RL)训练的,这些变体未能显著提高性能,除了 DeepscaleR 之外,这表明目前仍缺乏可靠且可扩展的强化学习训练方案。

通过强化学习训练的方法通常能显著改善基础模型的性能。然而,指令调优优于强化学习训练的方法(Open Reasoner Zero 除外)。这表明目前仍缺乏可靠且可扩展的强化学习训练方案。

在较大模型的推理轨迹上进行监督微调,能够在基准测试中获得显著的提升,并且这种提升是可推广的。同时,随着时间的推移,相关的进展得以成功复制。这凸显了这种监督微调作为训练范式的稳健性和成熟性。

当前基于强化学习的方法很容易出现过拟合的情况,这强调了需要进行更严格的异域基准测试。而 SFT(监督微调)模型在这方面表现出了更强的泛化能力以及更好的韧性。

较长的响应往往与较高的错误概率有联系,而在 consensus@k 中,响应长度是识别低置信度或失败生成的一种较为实用的启发式思路。

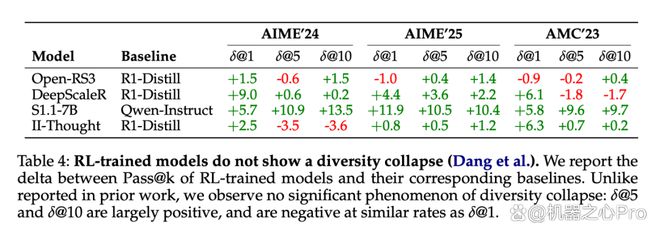

准解码策略似乎能够把模型在有效推理路径上的完整分布给捕捉住,这反驳了多样性坍缩假说。

清醒的观察:结果

表 3 展示了实验结果,并对结果的不同方面进行了分析。

研究者在标准化评估环境下,分别对六个数学推理基准测试进行了模型评估。并且针对这些模型的 Pass@1 准确率(均值 ± 标准差)进行了报告。在 AIME 基准测试中,结果是十个随机种子的平均值。在 AMC 基准测试中,结果也是十个随机种子的平均值。而对于其他基准测试,结果则是三个随机种子的平均值。研究者运用了 LightEval 框架,并且针对每种方法都调试出了最佳的超参数。

需要指出的是,数学模型的上下文长度是 4096 ,而其他模型的上下文长度被设定为 32768 ,并且使用了合适的提示模板。同时,基于强化学习(RL)的模型变体以及基于监督微调(SFT)的模型变体,分别针对各自的基础模型或者指令调优模型进行了评估。

主要结论如下:

通过强化学习训练的方法未能显著提升性能。

在推理路径上,SFT 展现了显著的泛化能力。

发现的现象是否可复现?详细分析

研究者对最近注意到的两种现象进行了进一步调查,目的是验证这两种现象在实验中是否能够复现。

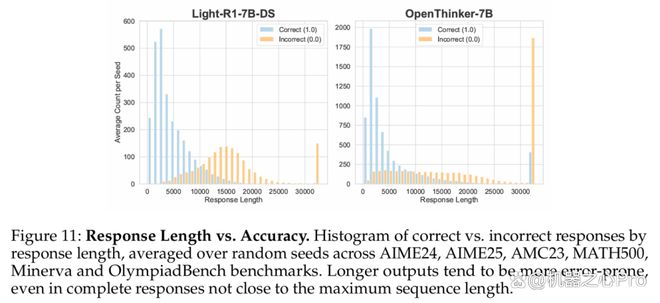

响应长度与性能之间的关系。

以推理为重点的训练后,响应的多样性是否有所下降。

1、错误响应是否更长?

较长的响应是否意味着错误答案的可能性更高呢?他们分别对六个数据集(AIME24、AIME25、AMC23、MATH500、Minerva 和 OlympiadBench)中正确答案的响应长度分布以及错误答案的响应长度分布进行了比较,并且在每个模型的随机种子上都进行了平均。

图 11 展示了这样的情况:将响应进行分组,按照响应长度来划分,然后统计每个种子的平均响应数量,并形成了直方图。

数据表明存在一个明显的趋势,较短的响应更有可能是正确的,而较长的响应逐渐显示出更高的错误率。这一模式在所有种子中都保持相同,尤其在超过 10000 个 token 的响应中最为明显。研究者针对此提出了两个关键问题:

这一模式是否适用于基于 RL 训练的模型?这一模式是否适用于基于 SFT 训练的模型?

分析结果显示,这一趋势在 RL 训练的模型中存在,同时在 SFT 训练的模型中也存在。

RL 训练模型(左侧显示)中这一效应更为显著

SFT 训练模型(右侧显示)中这一效应相对较弱

Qwen 2.5 Math 基础模型呈现出一定程度的长度相关性,然而这种相关性在 R1 - distill 以及后续的 RL 训练模型里更为显著。

Q2. 这种现象是否主要由截断或不完整的响应导致?

接近 32000 token 限制的响应几乎总是错误的,这是由上下文长度限制导致的。即便响应较短且完整,这一趋势依然存在,即较长的响应与较高的错误概率相关。

2、在推理训练中是否存在多样性坍缩?

研究者为了验证这些主张,将 RL 训练模型在所有数据集中的 Pass@k 性能(其中 k 属于 1、5、10)与相应的基础模型(例如 DeepSeek - R1 - Distill - Qwen - 1.5B)进行了比较。表 4 展示了各方法的 Pass@k 相对于基础模型的变化情形。

结果表明,没有观察到一致的多样性坍缩情况。Pass@1 的提升通常会伴有 Pass@k 的整体提升,不过不同指标的提升幅度有差异。当 Pass@k 性能下降时,这种下降往往与 Pass@1 的偶尔下降同时出现,而不是单独发生,此发现不支持多样性坍缩的假设。

本文采摘于网络,不代表本站立场,转载联系作者并注明出处:http://mjgaz.cn/fenxiang/275417.html